Кластерний спосіб навчання нейронної мережі

Номер патенту: 96457

Опубліковано: 10.02.2015

Автори: Турти Марина Валентинівна, Кутковецький Валентин Якович

Формула / Реферат

Кластерний спосіб навчання нейронної мережі з прямим розповсюдженням сигналів від початкового до кінцевого шару, яка призначена для визначення класів α навчальних об'єктів, що представлені навчальними вхідними векторами змінних ![]() , де

, де ![]() - порядковий номер класів навчальних об'єктів,

- порядковий номер класів навчальних об'єктів, ![]() - порядкові номери змінних xj навчальних об'єктів, за умови, що нейрони першого сенсорного шару в кількості n не мають активаційних функцій і їх використовують для розмноження та нормалізації змінних xj навчальних векторів, другий та третій шари з проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують як асоціативні шари, у яких кількість нейронів та ваги їх входів визначають у процесі навчання, четвертий вихідний шар із проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують для розділу об'єктів на класи, який відрізняється тим, що в першому шарі додають (K+1)-ий насправді неіснуючий "умовний клас об'єктів" з уведенням порядкових номерів усіх класів

- порядкові номери змінних xj навчальних об'єктів, за умови, що нейрони першого сенсорного шару в кількості n не мають активаційних функцій і їх використовують для розмноження та нормалізації змінних xj навчальних векторів, другий та третій шари з проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують як асоціативні шари, у яких кількість нейронів та ваги їх входів визначають у процесі навчання, четвертий вихідний шар із проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують для розділу об'єктів на класи, який відрізняється тим, що в першому шарі додають (K+1)-ий насправді неіснуючий "умовний клас об'єктів" з уведенням порядкових номерів усіх класів ![]() ,

, ![]() , де порядковий номер

, де порядковий номер ![]() належить до умовних об'єктів "умовного класу", з описаним нижче алгоритмом уведення їх векторів змінних, які умовно "заповнюють" координатний простір, що не заповнений змінними векторів навчальних об'єктів, кожну групу навчальних об'єктів

належить до умовних об'єктів "умовного класу", з описаним нижче алгоритмом уведення їх векторів змінних, які умовно "заповнюють" координатний простір, що не заповнений змінними векторів навчальних об'єктів, кожну групу навчальних об'єктів ![]() класу α розділяють у загальному випадку на

класу α розділяють у загальному випадку на ![]() кластерів класу α (підгрупи об'єктів однакового класу α, у яких спостерігається найменша відстань між ними) і позначають вектори змінних навчальних об'єктів кластерів

кластерів класу α (підгрупи об'єктів однакового класу α, у яких спостерігається найменша відстань між ними) і позначають вектори змінних навчальних об'єктів кластерів ![]() верхнім індексом ″іα″, де

верхнім індексом ″іα″, де ![]() - порядкові номери кластерів класу α, для кожного навчального об'єкта кожного кластера іα класу α на визначеній відстані знаходять сусідній навчальний об'єкт кластера іk класу k, помічають на векторі змінних об'єкта кластера іα номер класу k та кластер іk сусіднього об'єкта у вигляді

- порядкові номери кластерів класу α, для кожного навчального об'єкта кожного кластера іα класу α на визначеній відстані знаходять сусідній навчальний об'єкт кластера іk класу k, помічають на векторі змінних об'єкта кластера іα номер класу k та кластер іk сусіднього об'єкта у вигляді ![]() , вилучають із кластерів іα навчальні вхідні вектори змінних

, вилучають із кластерів іα навчальні вхідні вектори змінних ![]() , які на фіксованій відстані в усіх напрямах координат мають сусідами лише об'єкти власного класу і мають позначення

, які на фіксованій відстані в усіх напрямах координат мають сусідами лише об'єкти власного класу і мають позначення ![]() (тобто, якщо α=k та іα=іk), аналогічним чином помічають координати сусіднього об'єкта іншого класу у вигляді вектора змінних об'єкта

(тобто, якщо α=k та іα=іk), аналогічним чином помічають координати сусіднього об'єкта іншого класу у вигляді вектора змінних об'єкта ![]() і об'єднують у пару сусідні вхідні вектори змінних різних класів (

і об'єднують у пару сусідні вхідні вектори змінних різних класів (![]() ,

,![]() ), а якщо сусідній об'єкт іншого класу на заданій відстані відсутній, то у вектора змінних навчального об'єкта кластера іα помічають верхнім індексом вектор змінних умовного об'єкта у вигляді

), а якщо сусідній об'єкт іншого класу на заданій відстані відсутній, то у вектора змінних навчального об'єкта кластера іα помічають верхнім індексом вектор змінних умовного об'єкта у вигляді ![]() , і за його даними створюють на заданій відстані парний йому умовний об'єкт кластера іK+1 класу (K+1) з відповідним поміченим вхідним вектором змінних умовного об'єкта

, і за його даними створюють на заданій відстані парний йому умовний об'єкт кластера іK+1 класу (K+1) з відповідним поміченим вхідним вектором змінних умовного об'єкта ![]() , для кластера іα класу α групують отримані пари вхідних векторів змінних (

, для кластера іα класу α групують отримані пари вхідних векторів змінних (![]() ,

,![]() ) з однаковими значеннями сусіднього класу k та кластера сусіднього кластера іk і за координатами цих пар визначають поверхню, яка розділяє два сусідні кластери (іα та іk) різних класів у вигляді лінійної чи нелінійної вирішальної функції

) з однаковими значеннями сусіднього класу k та кластера сусіднього кластера іk і за координатами цих пар визначають поверхню, яка розділяє два сусідні кластери (іα та іk) різних класів у вигляді лінійної чи нелінійної вирішальної функції ![]() , та відповідну їй активаційну функцію

, та відповідну їй активаційну функцію ![]() , де

, де ![]() - порядковий номер поверхні вирішальної функції та відповідної активаційної функції кластера іα класу α,

- порядковий номер поверхні вирішальної функції та відповідної активаційної функції кластера іα класу α, ![]() - загальна кількість вирішальних функції та відповідних активаційних функцій кластера іα класу α, знаки ″±″ вказують знаки розрахованих значень вирішальної функції, які є протилежними для об'єктів сусідніх класів α та k, і яких вирішальна функція набуває при використанні координат відповідних навчальних об'єктів двох сусідніх класів за номерами α та k, повторюють вказану операцію для всіх границь між всіма кластерами, об'єднують та уточнюють отримані вирішальні функції u2 та відповідні активаційні функції у2 всіх класів, у другому шарі, який є шаром визначення границь між двома кластерами (іα та іk) для кожної окремої границі кластера іα з порядковим номером

- загальна кількість вирішальних функції та відповідних активаційних функцій кластера іα класу α, знаки ″±″ вказують знаки розрахованих значень вирішальної функції, які є протилежними для об'єктів сусідніх класів α та k, і яких вирішальна функція набуває при використанні координат відповідних навчальних об'єктів двох сусідніх класів за номерами α та k, повторюють вказану операцію для всіх границь між всіма кластерами, об'єднують та уточнюють отримані вирішальні функції u2 та відповідні активаційні функції у2 всіх класів, у другому шарі, який є шаром визначення границь між двома кластерами (іα та іk) для кожної окремої границі кластера іα з порядковим номером ![]() вводять відповідний нейрон, кількість входів якого та вагові коефіцієнти визначають згідно з вирішальною функцією

вводять відповідний нейрон, кількість входів якого та вагові коефіцієнти визначають згідно з вирішальною функцією ![]() , із відповідною активаційною функцією виходу

, із відповідною активаційною функцією виходу ![]() , шляхом повторення цієї операції визначають для другого шару кількість нейронів

, шляхом повторення цієї операції визначають для другого шару кількість нейронів ![]() , що припадає на кластер іα, кількість нейронів

, що припадає на кластер іα, кількість нейронів ![]() , що припадає на весь клас α, у третій шар за умови, що в другому шарі або є більше ніж один нейрон границь для кластера іα, або є лише один нейрон границь із виходом "0", вводять один нейрон з ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх границь одного кластера іα і який виконує багатовхідну логічну граничну функцію AND3, що об'єднує границі одного кластера і видає на виході ″+1″, якщо всі вхідні змінні відповідають заданим значенням ″0″ чи ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона третього шару всі виходи активаційних функцій

, що припадає на весь клас α, у третій шар за умови, що в другому шарі або є більше ніж один нейрон границь для кластера іα, або є лише один нейрон границь із виходом "0", вводять один нейрон з ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх границь одного кластера іα і який виконує багатовхідну логічну граничну функцію AND3, що об'єднує границі одного кластера і видає на виході ″+1″, якщо всі вхідні змінні відповідають заданим значенням ″0″ чи ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона третього шару всі виходи активаційних функцій ![]() нейронів границь одного кластера іα другого шару, у результаті чого в третьому шарі визначають відповідну кількість кластерних нейронів класу α у четвертий шар за умови, що існує більше ніж один вихід із попередніх шарів для виділення кластеру класу α, вводять один нейрон із ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх кластерів іα у клас α і який виконує багатовхідну логічну граничну функцію OR4, що видає на виході ″+1″, якщо хоча б одна вхідна змінна дорівнює ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона четвертого шару всі виходи кластерів іα, у результаті чого визначають необхідність застосування одного нейрона класу α у четвертому шарі, а після аналогічного розгляду всіх класів визначають необхідність застосування четвертого шару для сукупності конкретних навчальних об'єктів.

нейронів границь одного кластера іα другого шару, у результаті чого в третьому шарі визначають відповідну кількість кластерних нейронів класу α у четвертий шар за умови, що існує більше ніж один вихід із попередніх шарів для виділення кластеру класу α, вводять один нейрон із ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх кластерів іα у клас α і який виконує багатовхідну логічну граничну функцію OR4, що видає на виході ″+1″, якщо хоча б одна вхідна змінна дорівнює ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона четвертого шару всі виходи кластерів іα, у результаті чого визначають необхідність застосування одного нейрона класу α у четвертому шарі, а після аналогічного розгляду всіх класів визначають необхідність застосування четвертого шару для сукупності конкретних навчальних об'єктів.

Текст

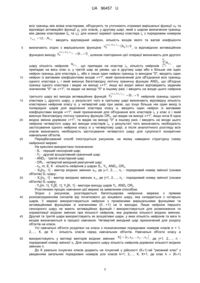

Реферат: UA 96457 U UA 96457 U 5 Корисна модель належить до нейрокібернетики і може бути застосованим для навчання нейронних мереж при розв'язанні задач обробки даних. Відомий спосіб навчання нейронів за дельта-правилом або правилом Відроу-Хоффа (Widrow-Hoff), згідно з яким на початку навчання ваговим коефіцієнтам нейронів надаються малі випадкові значення, наприклад із діапазону [-0,3;…; +0,3] із випадковим призначенням знаків «+» та «-», а розрахунки вагових коефіцієнтів виконуються за формулою: w HOBE w СТАРЕ y1E y1 x j w СТАРЕ x j j j j де y1E y1 ; 10 15 w СТАРЕ j , w HOBE j , (1) - старе та нове значення вагових коефіцієнтів; 0...1 коефіцієнт навчання (звичайно приймається за такий, що дорівнює 0,05…0,25); y1E , y 1 еталонне та реальне (розраховане) значення виходу. У процесі навчання на вхід нейрону подається одна навчальна еталонна пара за іншою, у результаті чого вагові коефіцієнти нейронів коригуються доти, доки для всіх еталонів похибка в розпізнаванні об'єктів не стане меншою від деякого прийнятого значення [1; 2]. Недоліком цього способу навчання нейрона є ускладнення аналізу багатошарових мереж, для яких стає невідомим еталонний навчальний вихід для всіх шарів, крім останнього. Найближчим аналогом є спосіб зворотного розповсюдження похибки (back-propagation), призначений для навчання багатошарової нейронної мережі з будь-якою кількістю шарів, у тому числі і для навчання мереж зі зворотними зв'язками та визначення класів α навчальних об'єктів, , що представлені навчальними вхідними векторами змінних X0 x1, x 2 ,..., x j ,..., x n , де 1 2,...,K j 1 2,...,n - порядкові номери змінних xj , порядковий номер класів навчальних об'єктів, навчальних об'єктів, за умови, що нейрони першого сенсорного шару в кількості n не мають активаційних функцій, і їх використовують для розмноження та нормалізації змінних xj навчальних векторів, другий та третій шари з проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують як асоціативні шари, в яких кількість нейронів та ваги їх входів визначають у процесі навчання, четвертий вихідний шар із проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують для розділу об'єктів на класи, який відрізняється [3-5]. Спосіб зворотного розповсюдження помилки (back-propagation) використовує два потоки розрахунків у багатошаровій нейронній мережі (пряме переміщення вхідного вектора змінних навчальної пари "вхід-вихід" від початкового вхідного шару до кінцевого вихідного шару; зворотне переміщення отриманої похибки розрахунків від кінця до початку нейронної мережі) при застосуванні в таких переміщеннях описаного вище дельта-правила. Недоліком цього способу навчання багатошарової нейронної мережі є невідомість оптимальної структури мережі, яка коригується в процесі навчання шляхом зміни кількості шарів та кількості нейронів в асоціативних шарах на основі компромісу за точністю роботи НМ та за часом її навчання. Причиною, що перешкоджає одержанню очікуваного технічного результату в найближчому аналогі (спрощення схеми за рахунок визначення оптимальної кількості шарів та кількості застосованих нейронів у всіх шарах, прозорість отриманого рішення за рахунок визначення логічного призначення і функції кожного нейрону в системі, спрощення процедури навчання за рахунок того, що практично навчається лише другий шар нейронної мережі) є відсутність зв'язку внутрішньої структури нейронної мережі з розв'язком поставленої задачі. Недоліками найближчого аналога способу навчання нейронної мережі є: - підвищена вартість нейронної мережі у зв'язку з неоптимальністю структури схеми, яка пояснюється відсутністю критеріїв визначення кількості асоціативних шарів та кількості нейронів у них; - непрозорість отриманого рішення зв'язку з відсутністю опису функції, яку виконує кожний шар та кожний нейрон у цьому шарі для розв'язання логічної проблеми; - ускладнення процедури навчання за рахунок того, що навчаються всі шари нейронної мережі, крім вхідного, у якого ваги нейронів можуть змінюватись лише з метою нормалізації змінних. В основу корисної моделі поставлено задачу оптимізації структури та зменшення вартості нейронної мережі за рахунок: - точного визначення структури нейронної мережі за кількістю проміжних асоціативних шарів та за кількістю нейронів у цих шарах; 20 25 30 35 40 45 50 55 1 UA 96457 U 5 - прозорості отриманого рішення внаслідок визначення логічного призначенняі функції кожного нейрону в проміжних асоціативних шарах системи; - спрощення процедури навчання, тому що практично навчається лише другий шар нейронної мережі; - можливості самонавчання нейронної мережі, заснованому на розгляді множини лише вхідних навчальних векторів. Поставлена задача вирішується тим, що спосіб навчання багатошарової нейронної мережі з прямим розповсюдженням сигналів від початкового до кінцевого шару, яка призначена для визначення класів а навчальних об'єктів, що представлені навчальними вхідними векторами змінних X0 x1, x 2 ,..., x j ,..., x n , де α = 1, 2,…, К - порядковий номер класів навчальних об'єктів, j=1, 2,…, n - порядкові номери змінних xj навчальних об'єктів, за умови, що нейрони першого сенсорного шару в кількості n не мають активаційних функцій і їх використовують для розмноження та нормалізації змінних xj навчальних векторів, другий та третій шари з проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують як асоціативні шари, у яких кількість нейронів та ваги їх входів визначають у процесі навчання, четвертий вихідний шар із проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують для розділу об'єктів на класи. Згідно з корисною моделлю, в першому шарі додають (К+1)-ий насправді не існуючий "умовний клас об'єктів" з уведенням порядкових номерів усіх класів k=1, 2,…, К, К+1, де порядковий номер k = (К+1) належить до умовних об'єктів "умовного класу", з описаним нижче алгоритмом введення їх векторів змінних, які умовно "заповнюють" координатний простір, що не 10 15 20 заповнений змінними векторів навчальних об'єктів, кожну групу навчальних об'єктів X 0 класу α 25 розділяють у загальному випадку на m кластерів класу α (підгрупи об'єктів однакового класу α, у яких спостерігається найменша відстань між ними) і позначають вектори змінних навчальних , i об'єктів кластерів X 0 верхнім індексом "іα», де іα = 1, 2,…, mа - порядкові номери кластерів класу α, для кожного навчального об'єкта кожного кластера і α класу α на визначеній відстані знаходять сусідній навчальний об'єкт кластера іk класу k, помічають на векторі змінних об'єкта , i кластера іα номер класу k та кластер іk сусіднього об'єкта у вигляді X 0 30 , вилучають із кластерів іα навчальні вхідні вектори змінних , які на фіксованій відстані за всіма напрямками координат мають сусідами лише об'єкти власного класу і мають позначення , i , , i (тобто, якщо α = k та іα = іk), аналогічним чином помічають координати сусіднього об'єкта k, i іншого класу у вигляді вектора змінних об'єкта X 0 , i , k , i X0 k k , , i і об'єднують у пару сусідні вхідні вектори k , i , , i X0 k змінних різних класів ( , ), а якщо сусідній об'єкт іншого класу на заданій відстані відсутній, то у вектора змінних навчального об'єкту кластера і α помічають верхнім індексом , i , K 1, i вектор змінних умовного об'єкта у вигляді X 0 , і за його даними створюють на заданій відстані парний йому умовний об'єкт кластера іK+1 класу (К+1) з відповідним поміченим вхідним K 1, i , , i вектором змінних умовного об'єкта X 0 , для кластера іα класу α групують отримані пари K 1 , i , k , i k 40 , k, i k , i , k , i X0 k X0 35 K 1 k , i k , , i вхідних векторів змінних ( X 0 , X0 ) з однаковими значеннями сусіднього класу k та кластера сусіднього кластера іk і за координатами цих пар визначають поверхню, яка розділяє два сусідні кластери (іα та іk) різних класів у вигляді лінійної чи нелінійної вирішальної функції , i , k, ik , ,i u2 , i , k, i , y 2 k ,i X0 0 , , i , k, i , ƒ 2 k ,i та відповідну їй активаційну функцію u , i , k, ik , ,i 0... 1 2 1 2,...,N,i , , де ,i - порядковий номер поверхні N 45 вирішальної функції та відповідної активаційної функції кластеру і α класу α, ,i - загальна кількість вирішальних функції та відповідних активаційних функцій кластера іα класу α, знаки «±» вказують знаки розрахованих значень вирішальної функції, які є протилежними для об'єктів сусідніх класів α та k, і які вирішальна функція набуває при використанні координат відповідних навчальних об'єктів двох сусідніх класів за номерами α та k, повторюють вказану операцію для 2 UA 96457 U всіх границь між всіма кластерами, об'єднують та уточнюють отримані вирішальні функції u2 та відповідні активаційні функції y2 усіх класів, у другому шарі, який є шаром визначення границь між двома кластерами (іα та іk), для кожної окремої границі кластера іα з порядковим номером ,i 1 2,...,N,i , 5 вводять відповідний нейрон, кількість входів якого та вагові коефіцієнти , i , k, ik , ,i визначають згідно з вирішальною функцією u2 функцією виходу , i , k, i , y 2 k ,i X0 0 , із відповідною активаційною 0... 1 , шляхом повторення цієї операції визначають для другого m N,i N 10 шару кількість нейронів ,i , що припадає на кластер іα, кількість нейронів 1 , що припадає на весь клас α, у третій шар за умови, що в другому шарі або є більше ніж один нейрон границь для кластера іα, або є лише один нейрон границь із виходом "0", вводять один нейрон із ваговими коефіцієнтами входів «+1", який призначений для об'єднання всіх границь одного кластера іα і який виконує багатовхідну логічну граничну функцію AND3, що об'єднує границі одного кластера і видає на виході «+1", якщо всі вхідні змінні відповідають заданим значенням "0" чи «+1", та видає на виході "0" в іншому разі, і вводять на входи цього нейрона 0... 1 нейронів границь одного третього шару всі виходи активаційних функцій y 2 кластера іα другого шару, у результаті чого в третьому шарі визначають відповідну кількість кластерних нейронів класу α, у четвертий шар при умові, що існує більше ніж один вихід із попередніх шарів для виділення кластера класу α, вводять один нейрон із ваговими коефіцієнтами входів «+1", який призначений для об'єднання всіх кластерів і α у клас α і який виконує багатовхідну логічну граничну функцію OR4, що видає на виході «+1", якщо хоча б одна вхідна змінна дорівнює «+1", та видає на виході "0" в іншому разі, і вводять на входи цього нейрона четвертого шару всі виходи кластерів іα, у результаті чого визначають необхідність застосування одного нейрона класу α у четвертому шарі, а після аналогічного розгляду всіх класів визначають необхідність застосування четвертого шару для сукупності конкретних навчальних об'єктів. Передбачуваний спосіб ілюструється рисунком, на якому наведено структурну схему нейронної мережі. На креслені використано позначення: - S1 - перший сенсорний шар; - Y2 - другий асоціативний граничний шар; - АND3 - третій кластерний шар; - OR4 - четвертий вихідний реагуючий шар; - nS, m, Е, К - кількість нейронів у шарах S1, Y2, AND3, OR4, - X0[nS, 1] - вектор вхідних змінних x0j, де j=1, 2,…, ns - порядковий номер змінної (ознаки об'єктів) S1-шару; - X1[nS, 1] - вектор вихідних змінних x1j, де j=1, 2,…, ns - порядковий номер змінної (ознаки об'єктів) S1-шару; - Y2[m, 1], Y3[E, 1], Y4[K, 1] - вектори виходу шарів Y2, AND3 OR4. Розглянемо процес навчання цієї мережі за заявленим способом. Згідно з рисунком, розглядається багатошарова нейронна мережа з прямим розповсюдженням сигналів від початкового до кінцевого шару, яка складається з чотирьох шарів. У мережі використовуються нейрони з проміжними вирішальними функціями та активаційними функціями зі значеннями (0…+1) на їх виходах. Лише нейрони першого сенсорного шару не мають активаційних функцій і використовується для розмноження та нормалізації вхідних змінних при кількості нейронів, яка дорівнює кількості вхідних змінних. Другий та третій шари використовують як асоціативні шари, у яких кількість нейронів та ваги їх входів визначаються в процесі навчання. Четвертий вихідний шар призначений для розділу об'єктів на класи. Усі навчальні об'єкти розділені на класи з позначеннями порядкових номерів класів α = 1, 2,…, К, де К - кількість класів серед навчальних об'єктів. Навчальні об'єкти класу а , i , k, ik , ,i 15 20 25 30 35 40 45 використовують у вигляді векторів вхідних змінних X0 x1, x 2 ,..., x j ,..., x n , де j=1, 2,…, n порядковий номер змінної xj. Для сенсорного шару кількість нейронів дорівнює кількості вхідних змінних n. До К реально існуючих класів додають не існуючий у дійсності (К+1)-ий "умовний клас" з уведенням загальних порядкових номерів усіх класів k=1, 2,…, К, К+1, де клас k = (К+1) 50 3 UA 96457 U 5 відноситься до реально не існуючих умовних об'єктів, які "заповнюють" не заповнений реальними навчальними об'єктами простір змінних. Призначення об'єктів "умовного (К+1)-ого класу" полягає у визначенні чіткої границі в просторі вхідних змінних для груп реальних об'єктів визначеного класу. Порядок визначення навчальних об'єктів "умовного (К+1)-ого класу" приведений нижче. Кожну групу навчальних векторів змінних X 0 класу α розділяють у загальному випадку на m кластерів класу α (підгрупи об'єктів однакового класу α, у яких спостерігається найменша відстань між ними в просторі змінних), де іα = 1, 2,…, mα - порядкові номери кластерів класу α. Вектори змінних навчальних об'єктів кожного кластеру іα класу α позначають верхнім індексом , i 10 15 "іα» у вигляді X 0 . Далі з метою отримання аналітичних виразів границь для кожного кластера і α класу а виконують пошук сусідніх векторів інших класів k. Для цього для кожного вектора кластера іα на визначеній відстані знаходять сусідній навчальний об'єкт кластера і k класу k і помічають на векторі змінних об'єкта кластера іα номер класу k та кластер іk сусіднього об'єкта у вигляді X 0 , i , k , ik . , i , k , i k Якщо сусідні навчальні вектори змінних X 0 належать до векторів змінних власного класу α та власного кластеру (k = α та іk = іα), тобто якщо отримують позначення вектора змінних , i у вигляді X 0 , , i , то такий вектор змінних вилучають із кластера іα. В іншому разі помічають k, i також координати сусіднього об'єкта іншого класу у вигляді вектора змінних об'єкта X 0 20 об'єднують отримані два вектори змінних різних класів у пару сусідніх векторів змінних ( k , , i , i , k , i X0 k й , k , i , , i X0 k ). При цьому якщо сусідній об'єкт іншого класу на заданій відстані відсутній, то у вектора змінних навчального об'єкту кластера іα помічають верхнім індексом вектор змінних умовного , i , K 1, i об'єкта у вигляді X 0 , і за координатами відсутнього сусіда створюють на заданій відстані парний умовний вектор кластера іK+1 класу (К+1) із відповідним поміченим вхідним K 1, i , , i вектором змінних умовного об'єкта X 0 . Отриманий умовний вектор вводять у сукупність навчальних векторів змінних умовного кластера іK+1. K 1 K 1 25 , i , k , i k 30 k , i k , , i Для кластера іα класу α групують отримані пари вхідних векторів змінних ( X 0 , X0 )з однаковими значеннями сусіднього класу k та сусіднього кластера іk і за координатами цих пар визначають поверхню, яка розділяє два сусідні кластери різних класів (і α та іk) у вигляді лінійної чи нелінійної вирішальної функції: , i , k, ik , ,i u2 X0 0 , (1) та відповідну їй активаційну функцію: , i , k, ik , ,i y2 35 , i , k, ik , ,i ƒ2 u , i , k, ik , ,i 0... 1 2 , 1 2,...,N , ,i ,i де - порядковий номер поверхні вирішальної функції та відповідної активаційної функції кластера іα класу α, яка розділяє сусідні кластери іα та іk; N ,i 40 45 - загальна кількість вирішальних функції та відповідних активаційних функцій кластера іα класу α; знаки «±» вказують знаки розрахованих значень вирішальної функції, які є протилежними для об'єктів сусідніх класів α та k, і яких вирішальна функція набуває при використанні координат відповідних навчальних об'єктів двох сусідніх класів за номерами α та k. Визначення аналітичної формули (1) може бути виконане, наприклад, за методом найменших квадратів за відомими координатами отриманих пар векторів змінних сусідніх кластерів. Вказану операцію повторюють для всіх границь між всіма кластерами, об'єднують та уточнюють отримані вирішальні функції та відповідні активаційні функції всіх класів. У другому шарі, який є шаром визначення границь між двома кластерами (і α та іk) для кожної окремої границі кластера іα з порядковим номером 4 ,i 1 2,...,N,i , вводять відповідний нейрон, UA 96457 U кількість входів якого та вагові коефіцієнти визначають згідно з вирішальною функцією , i , k, ik , ,i u2 X0 0 , із відповідною активаційною функцією виходу нейрона , i , k, ik , ,i y2 Шляхом повторення цієї операції визначають для другого шару кількість нейронів 0... 1 . N ,i , що m N,i 5 10 припадає на кластер іα, кількість нейронів 1 , що припадає на всі кластери класу α (тобто на весь клас α). Таким же чином визначається кількість нейронів та їхні параметри для інших класів, у результаті чого визначається кількість нейронів та їхні параметри для всього другого шару. У третій шар за умови, що в другому шарі або є більше ніж один нейрон границь для кластера іα, або є лише один нейрон границь із виходом "0", вводять один нейрон з ваговими коефіцієнтами входів «+1", який призначений для об'єднання всіх границь одного кластера і α. Цей нейрон із ваговими коефіцієнтами входів «+1" виконує багатовхідну логічну граничну функцію AND3, що об'єднує границі одного кластера і видає на виході «+1", якщо всі вхідні змінні відповідають заданим значенням "0" чи «+1", та видає на виході "0" в іншому разі. На входи 0... 1 цього нейрона третього шару вводять усі виходи активаційних функцій y 2 нейронів границь одного кластеру іα другого шару, в результаті чого у третьому шарі визначають відповідну кількість кластерних нейронів класу α. Проміжна вирішальна функція кластерного нейрона іα класу α третього шару може бути визначеною через виходи всіх границь для кластера іα другого шару за формулою: , i , k, ik , ,i 15 , i u3 20 де N1 ,i 1 , i , k, ik , ,i y2 ,i ,i 1 N,i N1 N2 ,i N1 ,i N,i , i , k, i , y 2 k ,i ,i 1 N1 ,i , - загальна кількість границь кластера іα класу α; 1 N ,i - загальна кількість границь кластера і α класу α, для яких їхні вирішальні функції , i , k, ik , ,i виконують нерівності u2 N2 ,i X0 0 для векторів змінних кластера іα; - загальна кількість границь кластера і α класу α, для яких їхні вирішальні функції не X0 0 для векторів змінних кластера іα, виконують нерівності u2 а вихідна порогова функція активації кластерного нейрона іα класу α третього шару дорівнює: , i , k, ik , ,i 25 , i y3 30 35 У результаті в третьому шарі визначають відповідну кількість кластерних нейронів класу α. Але якщо деякий клас має у AND3-шарі лише один кластер, то вихід нейрона цього кластера в другому шарі використовується для отримання інформації про клас досліджуваного об'єкта без введення додаткового нейрона в третій шар AND3. У четвертий шар за умови, що існує більше ніж один вихід із попередніх шарів для виділення кластеру класу α, вводять один нейрон із ваговими коефіцієнтами входів «+1", який призначений для об'єднання всіх кластерів і α у клас α. Цей нейрон виконує багатовхідну логічну граничну функцію OR4, що видає на виході «+1", якщо хоча б одна вхідна змінна дорівнює «+1", та видає на виході "0" в іншому разі. На входи цього нейрона четвертого шару вводять усі виходи кластерів іα, якщо їх більше за один. Для четвертого шару використовують проміжну вирішальну функцію: u 4 40 1 u , i , k, ik 0,5, , 3 , i , k, i 0, u3 k 0,5. m , i y3 1 , а вихідна порогова функція активації нейрона класу α четвертого шару дорівнює: 1 u 0,5, , 4 y 4 , i 0, u 4 0,5. , i 5 UA 96457 U 5 10 15 20 25 30 35 У результаті визначають необхідність застосування одного нейрона класу α у четвертому шарі, а після аналогічного розгляду всіх класів визначають необхідність застосування четвертого шару для сукупності конкретних навчальних об'єктів. Якщо АND3-шар має лише один кластер класу k, то відповідних нейронів в OR4-шарі для цього класу не передбачається. Якщо всі кластери в АND3-шарі мають номери класів k, які не повторюються, то реагуючий OR4-шар не потрібний, бо його функції виконує AND3-шар. Тобто деякі кластерні нейрони AND3-шару для об'єктів класу k, які не мають аналогічних кластерів в AND3-шарі, виконують реагуючі функції OR4- шару. Розглянемо процес використання навченої за заявленим способом нейронної мережі. При введенні даних вектора змінних об'єкта невідомого класу в перший шар, відбувається нормалізація та розмноження вхідних змінних. У другому шарі надаються відомості про знаки, яких набувають вирішальні функції границь між кластерами. У третьому шарі визначається сукупність границь кластера, яка відповідає логічним умовам належності об'єкта до кластера цього класу. У четвертому шарі визначається клас об'єкта. Описана нейронна мережа охоплює, хоча й не повний, але достатньо великий обсяг практичних задач, які можуть ефективно розв'язуватись запропонованим способом. Використання запропонованого винаходу дозволяє: - оптимізувати структуру схеми завдяки точному визначенню кількості асоціативних шарів та кількості нейронів у них; - мати чіткий опис призначення кожного шару, кожного нейрона в шарі та спрямованості їхньої роботи; - спростити процедуру навчання за рахунок того, що навчаються нейрони лише другого Y2шару. Джерела інформації: 1. Widrow В. Adaptive switching circuits / В. Widrow, M.E.Jr Hoff // Western Conference Rec., IRE. - 1960. - № 4. - P. 94-104. 2. Руденко О.Г. Штучні нейронні мережі / О.Г. Руденко, C.В. Бодянський. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. 3. Галушкин А.И. Синтез многослойных систем распознавания образов / А.И. Галушкин. - М.: Энергия, 1974. 4. Werbos P.J. Beyond regression: New tools for prediction and analysis in behavioral sciences / P.J. Werbos. - Ph. D. thesis, Harvard University, Cambridge, MA, 1974. 5. Rumelhart D.E. Learning Internal Representation by Error Propagation / D.E. Rumelhart, G.E. Hinton, R.J. Williams // Parallel Distributed Processing. - V. 1. - P. 318-362. - Cambridge, MA, MIT Press, 1986. ФОРМУЛА КОРИСНОЇ МОДЕЛІ 40 45 50 55 Кластерний спосіб навчання нейронної мережі з прямим розповсюдженням сигналів від початкового до кінцевого шару, яка призначена для визначення класів α навчальних об'єктів, що представлені навчальними вхідними векторами змінних X0 x1, x2, ..., x j, ..., xn , де 1, 2,..., K - порядковий номер класів навчальних об'єктів, j 1, 2,..., n - порядкові номери змінних xj навчальних об'єктів, за умови, що нейрони першого сенсорного шару в кількості n не мають активаційних функцій і їх використовують для розмноження та нормалізації змінних xj навчальних векторів, другий та третій шари з проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують як асоціативні шари, у яких кількість нейронів та ваги їх входів визначають у процесі навчання, четвертий вихідний шар із проміжними вирішальними функціями та активаційними функціями нейронів зі значеннями (0…+1) на їх виходах використовують для розділу об'єктів на класи, який відрізняється тим, що в першому шарі додають (K+1)-ий насправді неіснуючий "умовний клас об'єктів" з уведенням порядкових номерів усіх класів k 1, 2,..., K , K 1 , де порядковий номер k K 1 належить до умовних об'єктів "умовного класу", з описаним нижче алгоритмом уведення їх векторів змінних, які умовно "заповнюють" координатний простір, що не заповнений змінними векторів навчальних об'єктів, кожну групу навчальних об'єктів X0 класу α розділяють у загальному випадку на m кластерів класу α (підгрупи об'єктів однакового класу α, у яких спостерігається найменша відстань між ними) і позначають вектори змінних навчальних об'єктів кластерів X0 , i верхнім індексом ″іα″, де i 1, 2,..., m - порядкові номери кластерів класу α, 6 UA 96457 U для кожного навчального об'єкта кожного кластера іα класу α на визначеній відстані знаходять сусідній навчальний об'єкт кластера іk класу k, помічають на векторі змінних об'єкта кластера іα номер класу k та кластер іk сусіднього об'єкта у вигляді X0 , i , k, ik , вилучають із кластерів іα навчальні вхідні вектори змінних X0 , i , k, ik , які на фіксованій відстані в усіх напрямах координат 5 мають сусідами лише об'єкти власного класу і мають позначення X0 , i , , i (тобто, якщо α=k та іα=іk), аналогічним чином помічають координати сусіднього об'єкта іншого класу у вигляді вектора змінних об'єкта Xk, ik , , i і об'єднують у пару сусідні вхідні вектори змінних різних класів 0 ( X0 , i , k, ik , Xk, ik , , i ), а якщо сусідній об'єкт іншого класу на заданій відстані відсутній, то у вектора 0 10 змінних навчального об'єкта кластера іα помічають верхнім індексом вектор змінних умовного об'єкта у вигляді X0 , i , K 1, iK 1 , і за його даними створюють на заданій відстані парний йому умовний об'єкт кластера іK+1 класу (K+1) з відповідним поміченим вхідним вектором змінних умовного об'єкта X0K 1, iK 1, , i , для кластера іα класу α групують отримані пари вхідних векторів змінних ( X0 , i , k, ik , Xk, ik , , i ) з однаковими значеннями сусіднього класу k та кластера сусіднього 0 кластера іk і за координатами цих пар визначають поверхню, яка розділяє два сусідні кластери 15 , i , k, ik , ,i (іα та іk) різних класів у вигляді лінійної чи нелінійної вирішальної функції u2 відповідну їй активаційну ,i 1, 2,..., N ,i функцію , i , k, ik , ,i y2 , i , k, ik , ,i ƒ2 X0 0 , та u , i , k, ik , ,i 0... 1 , 2 де - порядковий номер поверхні вирішальної функції та відповідної активаційної функції кластера іα класу α, N,i - загальна кількість вирішальних функції та 20 25 відповідних активаційних функцій кластера і α класу α, знаки ″±″ вказують знаки розрахованих значень вирішальної функції, які є протилежними для об'єктів сусідніх класів α та k, і яких вирішальна функція набуває при використанні координат відповідних навчальних об'єктів двох сусідніх класів за номерами α та k, повторюють вказану операцію для всіх границь між всіма кластерами, об'єднують та уточнюють отримані вирішальні функції u2 та відповідні активаційні функції у2 всіх класів, у другому шарі, який є шаром визначення границь між двома кластерами (іα та іk) для кожної окремої границі кластера іα з порядковим номером ,i 1, 2,..., N ,i вводять відповідний нейрон, кількість входів якого та вагові коефіцієнти визначають згідно з , i , k, ik , ,i вирішальною функцією u2 , i , k, ik , ,i y2 X0 0 , із відповідною активаційною функцією виходу 0... 1 , шляхом повторення цієї операції визначають для другого шару кількість m нейронів N,i , що припадає на кластер іα, кількість нейронів 30 35 , i , k, ik , ,i 45 ,i , що припадає на весь клас 1 α, у третій шар за умови, що в другому шарі або є більше ніж один нейрон границь для кластера іα, або є лише один нейрон границь із виходом "0", вводять один нейрон з ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх границь одного кластера іα і який виконує багатовхідну логічну граничну функцію AND3, що об'єднує границі одного кластера і видає на виході ″+1″, якщо всі вхідні змінні відповідають заданим значенням ″0″ чи ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона третього шару всі виходи активаційних функцій y2 40 N 0... 1 нейронів границь одного кластера іα другого шару, у результаті чого в третьому шарі визначають відповідну кількість кластерних нейронів класу α у четвертий шар за умови, що існує більше ніж один вихід із попередніх шарів для виділення кластеру класу α, вводять один нейрон із ваговими коефіцієнтами входів ″+1″, який призначений для об'єднання всіх кластерів іα у клас α і який виконує багатовхідну логічну граничну функцію OR4, що видає на виході ″+1″, якщо хоча б одна вхідна змінна дорівнює ″+1″, та видає на виході ″0″ в іншому разі, і вводять на входи цього нейрона четвертого шару всі виходи кластерів і α, у результаті чого визначають необхідність застосування одного нейрона класу α у четвертому шарі, а після аналогічного розгляду всіх класів визначають необхідність застосування четвертого шару для сукупності конкретних навчальних об'єктів. 7 UA 96457 U Комп’ютерна верстка І. Скворцова Державна служба інтелектуальної власності України, вул. Урицького, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут промислової власності”, вул. Глазунова, 1, м. Київ – 42, 01601 8

ДивитисяДодаткова інформація

МПК / Мітки

МПК: G06N 7/00

Мітки: спосіб, навчання, кластерний, нейронної, мережі

Код посилання

<a href="https://ua.patents.su/10-96457-klasternijj-sposib-navchannya-nejjronno-merezhi.html" target="_blank" rel="follow" title="База патентів України">Кластерний спосіб навчання нейронної мережі</a>

Попередній патент: Спосіб навчання нейронної мережі

Наступний патент: Фундамент під щоглу судна

Випадковий патент: Установка для кавітаційно-корозійних випробувань металів