Нейронна мережа “миколаїв”

Номер патенту: 104872

Опубліковано: 25.02.2016

Автори: Турти Марина Валентинівна, Кутковецький Валентин Якович

Формула / Реферат

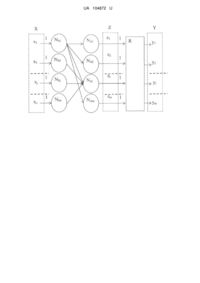

Нейронна мережа, яка призначена для асоціативного розпізнавання образів, що описуються векторами з елементами "±1", має призначений для розмноження вхідного сигналу X=(х1, х2,…, хj, …, хn) вхідний 1-й сенсорний шар з кількістю нейронів n, кожний з яких має один вхід з ваговим коефіцієнтом "1" та m виходів, кожний з яких з'єднаний з відповідним входом нейрона 2-го асоціативного шару, кожний нейрон 2-го асоціативного шару узагальній кількості m має n входів та один вихід, причому вагові коефіцієнти n входів кожного нейрона 2-го асоціативного шару дорівнюють відповідним елементам еталонного образу ХЕi=(xEi, x2Ei, …, xjEi, …, хnEi), де і=1, 2,…, m - порядковий номер еталону, а вихід кожного з m нейронів 2-го асоціативного шару призначений для отримання скалярного добутку двох векторів у вигляді zi={(X)T[1:n]·(XEi)[n:1]}, m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z1, z2,…, zi, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару, що має m виходів для виведення вихідного вектора Y=(у1, у2,…, уі, …, уm), кожний елемент уі якого призначений для виведення значення "0", якщо відповідне значення елемента zi вектора Z=(z1, z2,…, zi, …, zm) менше максимального значення елементів вектора Z та призначений для виведення значення "1", якщо значення елемента zi - вектора Z дорівнює максимальному значенню елементів вектора Z, яка відрізняється тим, що реагуючий шар має один нейрон, який складається з блока активаційної функції, що призначена для виконання операцій:

for i:=1 to m do у(і):=0;

ZM:=z(1); for i:=2 to m do if z(i) > ZM then ZM:=z(i);

for i:=1 to m do if z(i) = ZM then у(i):=1.

Текст

Реферат: UA 104872 U UA 104872 U 5 10 15 20 25 30 35 40 45 50 55 60 Корисна модель належить до штучних нейронних мереж (ШНМ), призначених для асоціативного розпізнавання образів, що описуються векторами з елементами "±1". Асоціативне розпізнавання образів застосовується в нейрокібернетиці і може бути використане в нейрокомп'ютерах та штучних нейронних мережах при розв'язанні задач логічної обробки даних. Відома одношарова ШНМ Хопфілда, яка призначена для асоціативного розпізнавання образу, що описується вектором X=(х1, х2,…, xj, …, хn) з елементами "±1", має призначений для з'єднання вхідного вектора шар з кількістю нейронів n з пороговою функцією активації, кожний з яких має вхід з ваговим коефіцієнтом "1", на який подається вхідний сигнал, та вихід, який з'єднаний із входами інших нейронів [1, 2, 3]. Недоліками ШНМ Хопфілда є мала кількість еталонних сигналів, які запам'ятовуються у вагах зворотних зв'язків нейронів, та необхідність виконання ряду циклічних розрахунків для Ei Еi Еі Ei Ei визначення на виході ШНМ найближчого еталонного сигналу X =(х , х2 , …, xj , …, хn ), де і=1, 2,…, m - порядковий номер еталону; m=0,1…0,15n. Найбільш близьким до заявленої нейронної мережі за сукупністю суттєвих ознак є вибрана за прототип відома нейронна мережа Хеммінга, яку запропонував Ліппман [3, 4]. Мережа Хеммінга призначена для асоціативного розпізнавання образів, що описуються векторами з елементами "±1", має призначений для розмноження вхідного сигналу X=(х1, х2,…, xj, …, хn) вхідний 1-й сенсорний шар з кількістю нейронів n, кожний з яких має один вхід з ваговим коефіцієнтом "1" та m виходів, кожний з яких з'єднаний з відповідним входом нейрона 2-го асоціативного шару, кожний нейрон 2-го асоціативного у загальній кількості m має n входів та один вихід, причому вагові коефіцієнти n входів кожного нейрона 2-го асоціативного шару Ei Ei Ei Ei Ei дорівнюють відповідним елементам еталонного образу X =(x , x2 , …, xj , …, xn ), де і=1, 2,…, m - порядковий номер еталону, а вихід кожного з m нейронів 2-го асоціативного шару T Ei призначений для отримання скалярного добутку двох векторів у вигляді zj={(X) [1:n]·(X )[n:1]}, m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z1, z2,…, zj, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару, що має m виходів для виведення вихідного вектора Y=(у1, у2,…, уі, …, уn), кожний елемент уі якого призначений для виведення значення "0", якщо відповідне значення елемента zi вектора Z=(z1, z2,…, zi, …, zm) менше максимального значення елементів вектора Z та призначений для виведення значення "1", якщо значення елемента zi вектора Z дорівнює максимальному значенню елементів вектора Z. Причини, які перешкоджають одержанню очікуваного технічного результату у прототипі (зменшення вартості через зменшення кількості нейронів вихідного реагуючого шару, зменшення часу отримання рішення через відсутність циклічних перерахунків виходів реагуючого шару) є прийнята архітектура реагуючого шару. Недоліками прийнятої за прототип ШНМ Хеммінга є: - збільшення витрат на обслуговування і налагодження ШНМ внаслідок збільшеної кількості нейронів у вихідному реагуючому шарі; - збільшення витрат часу внаслідок необхідності виконання циклічних перерахунків у реагуючому шарі для отримання номера асоціативно найближчого еталонного вектора. Технічним результатом пропонованої корисної моделі є зменшення витрат на обслуговування і налагодження ШНМ внаслідок зменшення кількості нейронів у вихідному реагуючому шарі та зменшення витрат часу внаслідок вилучення виконання циклічних перерахунків у реагуючому шарі для отримання номера асоціативно найближчого еталонного вектора. Загальні суттєві ознаки запропонованої ШНМ, які співпадають з суттєвими ознаками прототипу, полягають у тому, що нейронна мережа "МИКОЛАЇВ", яка призначена для асоціативного розпізнавання образів, що описуються векторами з елементами "±1", має призначений для розмноження вхідного сигналу X=(х 1, х2,…, xj, …, хn) вхідний 1-й сенсорний шар з кількістю нейронів n, кожний з яких має один вхід з ваговим коефіцієнтом "1" та m виходів, кожний з яких з'єднаний з відповідним входом нейрона 2-го асоціативного шару, кожний нейрон 2-го асоціативного шару у загальній кількості m має n входів та один вихід, причому вагові коефіцієнти n входів кожного нейрона 2-го асоціативного шару дорівнюють відповідним Ei Ei Ei Ei Ei елементам еталонного образу X =(x , x2 , …, xj , …, xn ), де і=1,2,…, m - порядковий номер еталону, а вихід кожного з m нейронів 2-го асоціативного шару призначений для отримання Т Ei скалярного добутку двох векторів у вигляді zi={(Х) [1:n]·(X )[n:1]}, m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z1, z2,…, zi, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару, що має m виходів для виведення вихідного вектора Y=(у1, у2, …, уі, …, уm), кожний елемент yi якого призначений для 1 UA 104872 U 5 10 15 20 25 30 35 40 45 50 55 виведення значення "0", якщо відповідне значення елемента zi вектора Z=(z1, z2,…, zi, …, zm) менше максимального значення елементів вектора Z та призначений для виведення значення "1", якщо значення елемента zi вектора Z дорівнює максимальному значенню елементів вектора Z. Суттєві ознаки запропонованої ШНМ, що є достатніми у всіх випадках і характеризують запропонований винахід на відміну від прототипу, полягають у тому, що реагуючий шар має один нейрон, який складається з блока активаційної функції, що призначена для виконання операцій: for i:=1 to m do y(i):= 0; ZM:=z(1); for i:=2 to m do if z(i) > ZM then ZM:=z(i); for i:=1 to m do if z(i)=ZM then y(i):=1; Передбачувана ШНМ ілюструється схемою, де наведена пропонована нейронна мережа "МИКОЛАЇВ". На рисунку використані наступні позначення: - X=(х1, х2,…, xj, …, хn) - вхідний вектор, який вводиться у 1-й сенсорний шар з n нейронів; - Z=(z1, z2,…, zi, …, zm), і=1, 2,…, m, - вектор виходу 2-го асоціативного шару, і-й елемент Т Еі Еi Еі Еі Ei Еi якого дорівнює zi={(Х) [1:n]·(Х )[n:1]}, де Х =(х , х2 , …, xj , …, хn ) - і-й вектор еталонних образів; - Y=(у1, у2,…, уі, …, уm) - вихідний вектор. - NS1, NS2,…, NSj, …, NSn - нейрони 1-го сенсорного шару кількістю n, кожний з яких має один вхід з ваговим коефіцієнтом "1" та m виходів. З метою спрощення рисунка на схемі показані не всі виходи нейронів сенсорного шару. У повному комплекті вони наведені лише для нейрона NS1. У дійсності кожний з нейронів сенсорного шару NS1, NS2,…, NSj, …, NSn має m виходів, з'єднаних з відповідними m входами нейронів 2-го асоціативного шару NA1, NA2,…, NAi, …, NAm. - NA1, NA2,…, NAi, …, NAm - нейрони 2-го асоціативного шару. Вагові коефіцієнти n входів кожного нейрона 2-го асоціативного шару дорівнюють відповідним елементам еталонного El Ei Ei Ei Ei образу X =(x , x2 , …, xj , …, xn ), де і=1, 2,…, m - порядковий номер еталону. Вихід кожного з m нейронів 2-го асоціативного шару призначений для отримання скалярного добутку двох T Fi векторів у вигляді zi={(X) [1:n]·(X )[n:1]}. m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z1, z2,…, zi, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару у вигляді нейрона R. З метою спрощення рисунка на схемі показані не всі входи нейронів 2-го асоціативного шару. У повному комплекті вони наведені лише для нейрона NAi. У дійсності кожний з нейронів 2-го асоціативного шару NA1, NA2,…, NAi, …, NAm має n входів, з'єднаних з відповідними n виходами нейронів 1-го сенсорного шару NS1, NS2,…, NSj, …, NSn. - R - нейрон реагуючого шару, який має m входів з ваговими коефіцієнтами "1" та m виходів, m виходів нейрона R реагуючого шару призначені для виведення значень елементів вихідного вектору Y=(у1, у2,…, уi, …, уm). Нейрон R складається з блока активаційної функції, що призначена для виконання операцій: for i:=1 to m do y(i):=0; ZM:=z(1); for i:=2 to m do if z(i) > ZM then ZM:=z(i); for i:=1 to m do if z(i)=ZM then y(i):=1. ШНМ "МИКОЛАЇВ" не потребує процесу навчання. Розглянемо загальний опис ШНМ "МИКОЛАЇВ" згідно з наведеною схемою. До входів нейронів з ваговим коефіцієнтом "1" N S1, NS2,…, NSj, …, NSn 1-го сенсорного шару ШНМ (див. схему) увімкнені елементи вхідного вектора X=(х 1, х2,…, xj, …, xn). m виходів кожного з нейронів NS1, NS2,…, NSj, …, NSn з'єднані з відповідним входом нейронів 2-го асоціативного шару NA1, NA2,…, NAi, …, NAm. Вагові коефіцієнти n входів кожного нейрона 2-го асоціативного шару дорівнюють Ei Ei Ei Ei bi відповідним елементам еталонного образу X =(x , x2 , …, xj , …, xn ). m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z 1, z2,…, zi, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару у вигляді нейрона R. Нейрон R реагуючого шару має m виходів для видачі вектора вихідного сигналу ШНМ Y=(y1, y2,…,уi, …,уm). Нейрон реагуючого шару R складається з блока активаційної функції, що призначена для виконання операцій: for i:=1 to m do y(i):=0; ZM:=z(1); for i:= 2 to m do if z(i) > ZM then ZM:=z(i); for i:=1 to m do if z(i)=ZM then y(i):=1. 2 UA 104872 U 5 10 15 20 25 30 35 40 Нейронна мережа працює наступним чином. При введенні у 1-й сенсорний шар вхідного вектора X=(х1, х2,…, xj, …, хn), для якого потрібно визначити номер найближчого еталону (з найбільшим значенням міри близькості) кожний і-й нейрон 2-го асоціативного шару має на Т Еі виході скалярний добуток двох векторів у вигляді zi={(Х) [1:n]·(Х )[n:1]}. Скалярний добуток двох векторів zi визначає міру близькості між двома векторами (наприклад, zi=-n для векторів, які не співпадають по всіх позиціях та zi=+n для векторів, які співпадають по всіх позиціях). Скалярний добуток двох векторів, хоча і визначає міру близькості між двома векторами, але разом з тим по числовому значенню відрізняється від близькості за Хеммінгом. Близькість за Хеммінгом між двома векторами є позитивним числом і дорівнює числу позицій з однаковими елементами векторів. Близькість між об'єктами визначається тим більшим позитивним числом, чим менша відстань між ними. Приклади близькості за Хеммінгом між двома векторами: d (11011; 11101)=3; d (3, 7, 1, 4; 5, 7, 1, 4)=3; d (нейрон; таксон)=2. Очевидно, що для застосування міри близькості за Хеммінгом, виходи нейронів 2-го асоціативного шару у вигляді скалярних добутків треба було б перерахувати. Але у дійсності використовуються не міра близькості за Хеммінгом, а скалярні добутки двох векторів, що не впливає на результати розрахунків. Тому надалі розглядаються виходи нейронів 2-го асоціативного шару у вигляді скалярних добутків. Отриманий вектор скалярних добутків Z=(z1, z2,…, zi, …, zm) з виходів m нейронів 2-го асоціативного шару через m входів з ваговими коефіцієнтами "1" поступає на нейрон R реагуючого шару, який складається з блока активаційної функції, що виконує операції: for i:=1 to m do y(i):=0; ZM:=z(l); for i:=2 to m do if z(i) > ZM then ZM:=z(i); for i:=1 to m do if z(i) = ZM then y(i):=1. У результаті на виходах нейрона R реагуючого шару утворюється вихідний вектор Y=(у 1, у2,…, уі, …, уm), у якого всі елементи дорівнюють нулю, за вилученням найближчого еталону, для якого елемент вектора Y дорівнює "1". Аналогічним чином нейронна мережа буде працювати при подачі інших вхідних векторів. Використання запропонованої нейронної мережі "МИКОЛАЇВ" дозволяє при відсутності процесу навчання зменшити витрати на обслуговування і налагодження ШНМ внаслідок зменшення кількості нейронів у реагуючому шарі та спрощення розрахунків. Джерела інформації: 1. Hopfield J.J. Neural Networks and Physical Systems with Emergent Collective Computational Abilities // Proceedings of the National Academy of Science. - 1982. - 79. - P. 2554-2558. 2. Hopfield J.J. Neurons with Graded Response Have Collective Computational Properties Like Those of Two-State Neurons // Proceedings of the National Academy of Science. - 1982. - 81. - P. 3088-3092. 3. Руденко О.Г., Бодянський С.В. Штучні нейронні мережі. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. 4. Lippman P.P. An Introduction to Computing with Neural Nets // IEEE ASSP Magazine. - 1987. № 4. - P. 4-22. ФОРМУЛА КОРИСНОЇ МОДЕЛІ 45 50 55 60 Нейронна мережа, яка призначена для асоціативного розпізнавання образів, що описуються векторами з елементами "±1", має призначений для розмноження вхідного сигналу X=(х 1, х2, …, хj, …, хn) вхідний 1-й сенсорний шар з кількістю нейронів n, кожний з яких має один вхід з ваговим коефіцієнтом "1" та m виходів, кожний з яких з'єднаний з відповідним входом нейрона 2-го асоціативного шару, кожний нейрон 2-го асоціативного шару у загальній кількості m має n входів та один вихід, причому вагові коефіцієнти n входів кожного нейрона 2-го асоціативного Еi Ei Ei Ei Ei шару дорівнюють відповідним елементам еталонного образу Х =(x , x2 , …, xj , …, хn ), де і=1, 2, …, m - порядковий номер еталону, а вихід кожного з m нейронів 2-го асоціативного шару T Ei призначений для отримання скалярного добутку двох векторів у вигляді zi={(X) [1:n]·(X )[n:1]}, m виходів нейронів 2-го асоціативного шару призначені для передачі сигналу у вигляді вектора Z=(z1, z2, …, zi, …, zm) і з'єднані з m входами з ваговими коефіцієнтами "1" реагуючого шару, що має m виходів для виведення вихідного вектора Y=(у1, у2, …, уі, …, уm), кожний елемент уі якого призначений для виведення значення "0", якщо відповідне значення елемента zi вектора Z=(z1, z2, …, zi, …, zm) менше максимального значення елементів вектора Z та призначений для виведення значення "1", якщо значення елемента zi - вектора Z дорівнює максимальному значенню елементів вектора Z, яка відрізняється тим, що реагуючий шар має один нейрон, який складається з блока активаційної функції, що призначена для виконання операцій: 3 UA 104872 U for i:= 1 to m do у(і):= 0; ZM:= z(1); for i:= 2 to m do if z(i)>ZM then ZM:= z(i); for i:= 1 to m do if z(i)=ZM then у(i):= 1. Комп’ютерна верстка Г. Паяльніков Державна служба інтелектуальної власності України, вул. Урицького, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут промислової власності”, вул. Глазунова, 1, м. Київ – 42, 01601 4

ДивитисяДодаткова інформація

МПК / Мітки

МПК: G06N 3/00

Мітки: миколаїв, нейронна, мережа

Код посилання

<a href="https://ua.patents.su/6-104872-nejjronna-merezha-mikolav.html" target="_blank" rel="follow" title="База патентів України">Нейронна мережа “миколаїв”</a>

Попередній патент: Нейронна мережа для стиснення інформації “код n:m:n”

Наступний патент: Нейрон “мах_2″

Випадковий патент: Антифрикційне мастило для металургійного обладнання