Нейронна мережа для стиснення інформації “код n:m:n”

Номер патенту: 104871

Опубліковано: 25.02.2016

Автори: Турти Марина Валентинівна, Кутковецький Валентин Якович

Формула / Реферат

Нейронна мережа, яка призначена для стиснення інформації передачі сигналу між вхідним сенсорним та вихідним шарами і для відображення на виході будь-якого з n вхідних векторів, кожний з яких складається з n рівних "0" елементів, з яких лише один елемент має значення "1", яке зміщується вздовж n елементів вхідних векторів від початку вектора до його кінця у залежності від порядкового номера n вхідного вектора, має вхідний сенсорний шар з ряду нейронів з одним входом з ваговим коефіцієнтом "1", з прямим розповсюдженням сигналів від вхідного сенсорного шару через прихований шар з m=log2n нейронами до вихідного шару з n нейронами, який призначений для видачі вихідного вектора, рівного вхідному вектору, причому нейрони вхідного сенсорного шару пов'язані своїми виходами з входами m нейронів прихованого шару, кожний з n нейронів вихідного шару має m входів, що зв'язані з виходами m нейронів прихованого шару, яка відрізняється тим, що вхідний шар складається з (n-1)=(2m-1) нейронів, нумерація яких від 1 до (n-1) у m-розрядній двоїстій формі при m=log2n відповідає положенню елемента "1" вхідних векторів, вихід кожного (n-1) нейрона сенсорного шару з'єднаний з входами з ваговими коефіцієнтами "1" m=log2n нейронів прихованого шару згідно з елементами "1" з нумерації в двоїстій формі нейронів вхідного сенсорного шару (без урахування зв'язків, відповідних нульовим елементам "0" цієї нумерації), m=log2n виходів нейронів прихованого шару подаються на m входів з ваговими коефіцієнтами "1" кожного з n нейронів типу "T_AND_0" вихідного шару, нумерація яких від 1 до n в двоїстій формі відповідає положенню елемента "1" у вхідних векторах, причому m входів кожного з нейронів "T_AND_0" розміщені і з'єднані з m=log2n виходами нейронів прихованого шару згідно з двоїстою нумерацією нейронів "T_AND_0" вихідного шару, за якою кількість входів Na (вхідних змінних хai від виходів m=log2n нейронів прихованого шару, які повинні мати призначені їм значення "+1" для отримання виходу у(u)=+1 даного нейрона "T_AND_0") та відповідна кількість входів (N - Na) (вхідних змінних xbi від виходів m=log2n нейронів прихованого шару, які повинні мати призначені значення "0" для отримання виходу у(u)=+1 даного нейрона "T_AND_0"), у сукупності для m входів кожного нейрона "T_AND_0" у m-розрядному двійковому вигляді складають номер j=1,2,…, n нейрона вихідного шару.

Текст

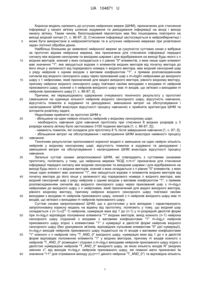

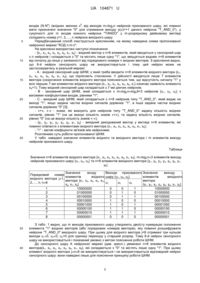

Реферат: UA 104871 U UA 104871 U 5 10 15 20 25 30 35 40 45 50 55 60 Корисна модель належить до штучних нейронних мереж (ШНМ), призначених для стиснення інформації у каналі зв'язку шляхом кодування та декодування інформації на вході і виході каналу зв'язку. Таким чином, багатошаровий персептрон має без пошкоджень повторити на виході вхідний сигнал [1, с. 86-87; 2]. Стиснення інформації застосовується в нейрокібернетиці і може бути використане в нейрокомп'ютерах та в штучних нейронних мережах при розв'язанні задач логічної обробки даних. Найбільш близьким до заявленої нейронної мережі за сукупністю суттєвих ознак є вибрана за прототип відома нейронна мережа, яка призначена для стиснення інформації передачі сигналу між вхідним сенсорним та вихідним шарами і для відображення на виході будь-якого з n вхідних векторів, кожний з яких складається з n рівних "0" елементів, з яких лише один елемент має значення "1", яке зміщується вздовж n елементів вхідних векторів від початку вектора до його кінця у залежності від порядкового номера n вхідного вектора, має вхідний сенсорний шар з ряду нейронів з одним входом з ваговим коефіцієнтом "1", з прямим розповсюдженням сигналів від вхідного сенсорного шару через прихований шар з m=log2n нейронами до вихідного шару з 1 нейронами, який призначений для видачі вихідного вектора, рівного вхідному вектору, причому нейрони вхідного сенсорного шару пов'язані своїми виходами з входами m нейронів прихованого шару, кожний з n нейронів вихідного шару має m входів, що зв'язані з виходами m нейронів прихованого шару [1, с. 86-87; 2]. Причини, які перешкоджають одержанню очікуваного технічного результату у прототипі (зменшення на одиницю кількості нейронів вхідного сенсорного шару, відсутність навчання, відсутність помилок в кодуванні та декодуванні, зменшення витрат на обслуговування і налагодження ШНМ внаслідок відсутності процесу навчання) є прийнята архітектура ШНМ та алгоритм розв'язку задачі. Недоліками прийнятої за прототип ШНМ є: - збільшена на один нейрон кількість нейронів у вхідному сенсорному шарі; - необхідність навчання (для навчання прототипу при стисненні 8 вхідних розрядів у 3 розряди каналу зв'язку було застосовано 3150 поданих векторів [1, с. 86-87; 2]); - наявність помилок, які складали для прототипу 8 % після завершення навчання [1, с. 87; 2]; - збільшення витрат на обслуговування і налагодження ШНМ внаслідок наявності процесу навчання. Технічним результатом пропонованої корисної моделі є зменшена на один нейрон кількість нейронів у вхідному сенсорному шарі, відсутність помилок в кодуванні та декодуванні і зменшення витрат на обслуговування і налагодження ШНМ внаслідок відсутності процесу навчання. Загальні суттєві ознаки запропонованої ШНМ, які співпадають з суттєвими ознаками прототипу, полягають у тому, що нейронна мережа "КОД n:m:n" призначена для стиснення інформації передачі сигналу між вхідним сенсорним та вихідним шарами і для відображення на виході будь-якого з n вхідних векторів, кожний з яких складається з n рівних "0" елементів, з яких лише один елемент має значення "1", яке зміщується вздовж n елементів вхідних векторів від початку вектора до його кінця у залежності від порядкового номера n вхідного вектора, має вхідний сенсорний шар з ряду нейронів з одним входом з ваговим коефіцієнтом "1", з прямим розповсюдженням сигналів від вхідного сенсорного шару через прихований шар з m=log2n нейронами до вихідного шару з n нейронами, який призначений для видачі вихідного вектора, рівного вхідному вектору, причому нейрони вхідного сенсорного шару пов'язані своїми виходами з входами m нейронів прихованого шару, кожний з n нейронів вихідного шару має m входів, що зв'язані з виходами m нейронів прихованого шару. Суттєві ознаки запропонованої ШНМ, що є достатніми у всіх випадках і характеризують запропоновану корисну модель на відміну від прототипу, полягають у тому, що вхідний шар m складається з (n-1)=(2 -1) нейронів, нумерація яких від 1 до (n-1) у m-розрядній двоїстій формі при m=log2n відповідає положенню елемента "1" вхідних векторів, вихід кожного (n-1) нейрона сенсорного шару з'єднаний з входами з ваговими коефіцієнтами "1" m=log2n нейронів прихованого шару згідно з елементами "1" з нумерації в двоїстій формі нейронів вхідного сенсорного шару (без урахування зв'язків, відповідних нульовим елементам "0" цієї нумерації), m=log2n виходів нейронів прихованого шару подаються на m входів з ваговими коефіцієнтами "1" кожного з n нейронів типу "T_AND_0" вихідного шару, нумерація яких від 1 до n в двоїстій формі відповідає положенню елемента "1" у вхідних векторах, причому m входів кожного з нейронів "T_AND_0" розміщені і з'єднані з m=log2n виходами нейронів прихованого шару згідно з α двоїстою нумерацією нейронів "T_AND_0" вихідного шару, за якою кількість входів N (вхідних α змінних x i від виходів m=log2n нейронів прихованого шару, які повинні мати призначені їм значення "+1" для отримання виходу у(u)=+1 даного нейрона "T_AND_0") та відповідна кількість 1 UA 104871 U α 5 10 15 20 25 30 β входів (N-N ) (вхідних змінних x i від виходів m=log2n нейронів прихованого шару, які повинні мати призначені значення "0" для отримання виходу у(u)=+1 даного нейрона "T_AND_0"), у сукупності для m входів кожного нейрона "TANDO" у m-розрядному двійковому вигляді складають номер j=1, 2,…, n нейрона вихідного шару. Передбачуваний спосіб ілюструється кресленням, на якому наведена схема пропонованої нейронної мережі "КОД n:m:n". На кресленні використані наступні позначення: - {х1, х2, х3, х4, х5, х6, х7, х8} - вхідний вектор з n=8 елементів, який вводиться у сенсорний шар з n нейронів і складається з "0" та містить лише одну "1", що зміщується вздовж n=8 елементів від початку до кінця у залежності від порядкового номера n вхідних векторів. З креслення видно, що 8-й нейрон сенсорного шару не використовується і тому цей нейрон може не застосовуватись в реальній мережі; - А - вхідний сенсорний шар ШНМ, у який треба вводити n=8 елементів вхідного вектора {х1, х2, х3, х4, х5, х6, х7, х8}, що підлягають стисненню. У дійсності вводиться лише 7 елементів вектора (скорочення елементів вхідного вектора пояснюється тим, що відсутність сигналу "1" у всіх перших 7-ми елементах вхідного вектора {х1, х2, х3, х4, х5, х6, х7} означає наявність елемента х8=1). Тому вхідний сенсорний шар складається з 7-ми діючих нейронів; - В - захований шар ШНМ, який складається з m=log2n=log28=3 нейронів {u1, u2, u3} з ваговими коефіцієнтами входів, рівними "1"; - С - вихідний шар ШНМ, який складається з n=8 нейронів типу "T_AND_0", який видає на виході "1", якщо задана частка вхідних сигналів дорівнює "1", а інша задана частка вхідних сигналів дорівнює "0" [3]; - «+», «-» - знаки, які вказують для нейронів типу "T_AND_0" задану кількість вхідних сигналів, рівних "1" (на це вказує кількість знаків «+»), та задану кількість вхідних сигналів, рівних "0" (на це вказує кількість знаків «-»); - {у1, у2, у3, у4, у5, у6, у7, у8} - вихідний декодований вектор у вигляді n=8 елементів, які повинні співпасти з елементами вхідного вектора {х 1, х2, х3, х4, х5, х6, х7, х8}; - "1" - вагові коефіцієнти зв'язків між нейронами. Розглянемо суть роботи пропонованої ШНМ. У табл. наведені значення елементів вхідного та вихідного вектора і m елементів виходу нейронів прихованого шару. Таблиця Значення n=8 елементів вхідного вектора {х1, х2, х3, х4, х5, х6, х7, х8}, m=log2n=3 елементів виходу нейронів прихованого шару {u1, u2, u3} та n=8 елементів вихідного вектора {у1, у2, у3, у4, у5, у6, у7, у8} Значення входу - Виходи прихованого Порядковий номер елементів вхідного шару {u1, u2, u3} вхідного вектора j=1, вектора {х1, х2, х3, х4, х5, 2,…, n; n=8 u1 u2 u3 х6, х7, х8} 1 10000000 0 0 1 2 01000000 0 1 0 3 00100000 0 1 1 4 00010000 1 0 0 5 00001000 1 0 1 6 00000100 1 1 0 7 00000010 1 1 1 8 00000001 0 0 0 35 40 Значення виходу елементів вихідного вектора {у1, у2, у3, у4, у5, у6, у7, у8} 10000000 01000000 00100000 00010000 00001000 00000100 00000010 00000001 З табл. 1 видно, що m виходів прихованого шару утворюють двоїсту нумерацію положення елемента "1" вхідних векторів (або порядкових номерів векторів), яку повинні розшифрувати нейрони "T_AND_0" вихідного шару. При цьому для вхідного вектора j=8 отримані три нульові виходи u1=0, u2=0, u3=0 для одиниці переходу у старший розряд. Тому 8-й нейрон сенсорного шару не використовується і показаний умовно з метою пояснення роботи ШНМ. До сенсорного шару А нейронної мережі (див. кресл.) увімкнені n=8 елементів вхідного вектора{х1, х2, х3, х4, х5, х6, х7, х8}, які складаються з "0" та містять лише одну "1". При цьому елемент вхідного вектора j=n=8 не використовується і не використовується відповідний нейрон сенсорного шару: вони наведені лише для пояснення принципу роботи ШНМ. 2 UA 104871 U 5 10 15 20 25 30 35 40 45 50 55 Всі вагові коефіцієнти входів нейронів ШНМ мають значення "1" і не змінюються. m Вхідний шар ШНМ згідно з малюнком складається з (n-1)=(2 -1) нейронів, нумерація яких від 1 до (n-1)=(8-1)=7 у m-розрядній двоїстій формі при m=log2n відповідає положенню елемента "1" вхідних векторів. Вихід кожного з (n-1) нейронів сенсорного шару з'єднаний з входами з ваговими коефіцієнтами "1" m=log2n нейронів прихованого шару згідно з елементами "1" з нумерації у m-розрядній двоїстій формі нейронів вхідного сенсорного шару (без урахування зв'язків, відповідних нульовим елементам "0" цієї нумерації). m=log2n виходів нейронів прихованого шару подаються на m входів з ваговими коефіцієнтами "1" кожного з п нейронів типу "T_AND_0" вихідного шару, нумерація яких від 1 до n в двоїстій формі відповідає положенню елемента "1" у вхідних векторах, причому m входів кожного з нейронів "TAND0" розміщені і з'єднані з m=log2n виходами нейронів прихованого шару α згідно з двоїстою нумерацією нейронів "T_AND_0" вихідного шару, за якою кількість входів N α (вхідних змінних x i від виходів m=log2n нейронів прихованого шару, які повинні мати призначені їм значення "+1" для отримання виходу у(u)=+1 даного нейрона "T_AND_0") та відповідна α β кількість входів (N-N ) (вхідних змінних х і від виходів m=log2n нейронів прихованого шару, які повинні мати призначені значення "0" для отримання виходу у(u)=+1 даного нейрона "T_AND_0"), у сукупності для m входів кожного нейрона "T_AND_0" у m-елементному двійковому вигляді складають номер j=1, 2,…, n нейрона вихідного шару. α β Тут N=m=log2n - загальна кількість вхідних змінних х і та х і кожного нейрона "T_AND_0". Припустимо, що до сенсорного шару А нейронної мережі (див. кресл.) увімкнений за табл. 1 вхідний вектор з порядковим номером j=1 у вигляді n=8 елементів {х1=1, х2=0, х3=0, х4=0, х5=0, х6=0, х7=0, х8=0}, які складаються з "0" та містять лише одну "1" (при цьому елемент вхідного вектора j=n=8 не використовується і наведений лише для пояснення роботи ШНМ). Для даного вхідного вектора номер елемента х 1=1 у m-розрядній двоїстій формі при m=log2n=log28=3 має вигляд "001". Тому вихід відповідного першого нейрона сенсорного шару з'єднується з входом нейрона u3 прихованого шару відповідно номера "001": два перших зв'язки з номера "001" зі значеннями "0" на схемі ШНМ не відображуються. У результаті на виходах нейронів прихованого шару {u1, u2, u3} утворюється сигнал "001", на який спрацьовує лише один нейрон вихідного шару "T_AND_0" і видає на виході у1=1. Усі інші виходи нейронів вихідного шару "T_AND_0" дорівнюють нулю: у2=0, у3=0, у4=0, у5=0, у6=0, у7=0, у8=0. Тобто на виході ШНМ ми отримуємо вектор {у1=1, у2=0, у3=0, у4=0, у5=0, у6=0, у7=0, у8=0}, який точно відповідає вхідному вектору {х1=1, х2=0, х3=0, х4=0, х5=0, х6=0, х7=0, х8=0}. Припустимо, що до сенсорного шару А нейронної мережі (див. кресл.) увімкнені n=8 елементів вхідного вектора {х1=0, х2=0, х3=1, х4=0, х5=0, х6=0, х7=0, х8=0} (елемент вхідного вектора j=n=8 не використовується і наведений лише для пояснення роботи ШНМ). Для даного вхідного вектора номер елемента х3=1 у m-розрядній двоїстій формі має вигляд "011". Тому вихід відповідного третього нейрона сенсорного шару з'єднується з входами нейронів u2 та u3 прихованого шару. Перший зв'язок з номера "011" зі значенням "0" на схемі ШНМ не відображуються. У результаті на виходах нейронів прихованого шару {u1, u2, u3} утворюється сигнал "011", на який спрацьовує нейрон вихідного шару "T_AND_0" і видає на виході у3=1. Усі інші виходи нейронів вихідного шару "T_AND_0" дорівнюють нулю. Тобто на виході ШНМ ми отримуємо вектор {у1=0, у2=0, у3=1, у4=0, у5=0, у6=0, у7=0, у8=0}, який точно відповідає вхідному вектору {х1=0, х2=0, х3=1, х4=0, х5=0, х6=0, х7=0, х8=0}. Припустимо, що до сенсорного шару А нейронної мережі (див. малюнок) увімкнені n=8 елементів вхідного вектора{х1=0, х2=0, х3=0, x4=0, x5=0, x6=0, x7=0, x8=1} (елемент вхідного вектора j=n=8 не використовується і наведений лише для пояснення роботи ШНМ). Для даного вхідного вектора номер елемента х8=1 у m-розрядній двоїстій формі має вигляд "1000" (одиниця переноситься у старший розряд). Для визначення з'єднань ми використовуємо лише три молодші розряди у вигляді "000". Тому вихід відповідного восьмого нейрона сенсорного шару не з'єднується з входами нейронів (u1, u2, u3) прихованого шару. Тобто восьмий нейрон сенсорного шару не використовується у роботі. У результаті на виходах нейронів прихованого шару {u1, u2, u3} утворюється сигнал "000", на який спрацьовує нейрон вихідного шару "T_AND_0" і видає на виході у8=1. Усі інші виходи нейронів вихідного шару "T_AND_0" дорівнюють нулю. Тобто на виході ШНМ ми отримуємо вектор (у1=0, у2=0, у3=0, у4=0, у5=0, у6=0, у7=0, у8=1}, який точно відповідає вхідному вектору {х1=0, х2=0, х3=0, х4=0, х5=0, х6=0, х7=0, х8=1}. Аналогічним чином нейронна мережа буде працювати при подачі інших вхідних векторів. 3 UA 104871 U 5 10 Використання запропонованої нейронної мережі "КОД n:m:n" дозволяє вилучити помилки кодування та декодування і зменшити витрати на обслуговування і налагодження ШНМ внаслідок відсутності процесу навчання. Використана інформація: 1. Руденко О.Г., Бодянський С.В. Штучні нейронні мережі. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. 2. Nauck D.В., Klawonn F., Kruse R. Neuronale Netze und Fuzzy-Systeme. - Braunschweig / Wiesbaden: Vieweg, 1996. 3. Кутковецький В.Я., Турти М.В. Нейрон "T_AND_0". Патент України на корисну модель № 97526, МПК G06N 3/00, 10.04.2015, Бюл. № 7. - 3 с. ФОРМУЛА КОРИСНОЇ МОДЕЛІ 15 20 25 30 35 40 Нейронна мережа, яка призначена для стиснення інформації передачі сигналу між вхідним сенсорним та вихідним шарами і для відображення на виході будь-якого з n вхідних векторів, кожний з яких складається з n рівних "0" елементів, з яких лише один елемент має значення "1", яке зміщується вздовж n елементів вхідних векторів від початку вектора до його кінця у залежності від порядкового номера n вхідного вектора, має вхідний сенсорний шар з ряду нейронів з одним входом з ваговим коефіцієнтом "1", з прямим розповсюдженням сигналів від вхідного сенсорного шару через прихований шар з m=log2n нейронами до вихідного шару з n нейронами, який призначений для видачі вихідного вектора, рівного вхідному вектору, причому нейрони вхідного сенсорного шару пов'язані своїми виходами з входами m нейронів прихованого шару, кожний з n нейронів вихідного шару має m входів, що зв'язані з виходами m m нейронів прихованого шару, яка відрізняється тим, що вхідний шар складається з (n-1)=(2 -1) нейронів, нумерація яких від 1 до (n-1) у m-розрядній двоїстій формі при m=log2n відповідає положенню елемента "1" вхідних векторів, вихід кожного (n-1) нейрона сенсорного шару з'єднаний з входами з ваговими коефіцієнтами "1" m=log2n нейронів прихованого шару згідно з елементами "1" з нумерації в двоїстій формі нейронів вхідного сенсорного шару (без урахування зв'язків, відповідних нульовим елементам "0" цієї нумерації), m=log2n виходів нейронів прихованого шару подаються на m входів з ваговими коефіцієнтами "1" кожного з n нейронів типу "T_AND_0" вихідного шару, нумерація яких від 1 до n в двоїстій формі відповідає положенню елемента "1" у вхідних векторах, причому m входів кожного з нейронів "T_AND_0" розміщені і з'єднані з m=log2n виходами нейронів прихованого шару згідно з двоїстою нумерацією нейронів "T_AND_0" вихідного шару, за якою кількість входів N (вхідних змінних хi від виходів m=log2n нейронів прихованого шару, які повинні мати призначені їм значення "+1" для отримання виходу у(u)=+1 даного нейрона "T_AND_0") та відповідна кількість входів (N - N) (вхідних змінних xi від виходів m=log2n нейронів прихованого шару, які повинні мати призначені значення "0" для отримання виходу у(u)=+1 даного нейрона "T_AND_0"), у сукупності для m входів кожного нейрона "T_AND_0" у m-розрядному двійковому вигляді складають номер j=1, 2, …, n нейрона вихідного шару. Комп’ютерна верстка І. Скворцова Державна служба інтелектуальної власності України, вул. Василя Липківського, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут інтелектуальної власності”, вул. Глазунова, 1, м. Київ – 42, 01601 4

ДивитисяДодаткова інформація

МПК / Мітки

МПК: G06N 3/00

Мітки: код, нейронна, інформації, стиснення, мережа, n:m:n

Код посилання

<a href="https://ua.patents.su/6-104871-nejjronna-merezha-dlya-stisnennya-informaci-kod-nmn.html" target="_blank" rel="follow" title="База патентів України">Нейронна мережа для стиснення інформації “код n:m:n”</a>

Попередній патент: Спосіб алмазного хонінгування отворів деталей тертя з високолегованих композитних матеріалів на основі нікелю з використанням ультразвуку

Наступний патент: Нейронна мережа “миколаїв”

Випадковий патент: Валідатор одноразових паперових квитків