Спосіб самонавчання класифікуючої нейронної мережі

Номер патенту: 108187

Опубліковано: 11.07.2016

Автори: Кутковецький Валентин Якович, Турти Марина Валентинівна

Формула / Реферат

1. Спосіб самонавчання класифікуючої нейронної мережі, який полягає у тому, що вхідний сенсорний шар нейронної мережі, кожний з ![]() нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу

нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу ![]() , де

, де ![]() - порядковий номер елемента вхідного сигналу

- порядковий номер елемента вхідного сигналу ![]() , передає нормалізований вхідний сигнал

, передає нормалізований вхідний сигнал ![]() на кластерний шар, що складається з

на кластерний шар, що складається з ![]() нейронів-центроїдів, які мають позначення

нейронів-центроїдів, які мають позначення ![]() , де

, де ![]() - порядковий номер нейрона-центроїда, кожний з яких має записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера

- порядковий номер нейрона-центроїда, кожний з яких має записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера ![]() і дозволяє оцінити відстань між вектором вхідного сигналу

і дозволяє оцінити відстань між вектором вхідного сигналу ![]() та вектором центроїда

та вектором центроїда ![]() , мінімум якої використовується для визначення переможця

, мінімум якої використовується для визначення переможця ![]() серед нейронів-центроїдів шару

серед нейронів-центроїдів шару ![]() , використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів

, використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів ![]() нейрона-переможця

нейрона-переможця ![]() шару

шару ![]() з урахуванням додаткових внутрішніх даних, який відрізняється тим, що блок навчання через

з урахуванням додаткових внутрішніх даних, який відрізняється тим, що блок навчання через ![]() входів із ваговими коефіцієнтами 1 отримує з вхідного сенсорного шару всі навчальні нормалізовані вектори вхідних сигналів

входів із ваговими коефіцієнтами 1 отримує з вхідного сенсорного шару всі навчальні нормалізовані вектори вхідних сигналів ![]() , де

, де ![]() - порядковий номер навчального вектора, визначає зовнішній радіус гіпершару

- порядковий номер навчального вектора, визначає зовнішній радіус гіпершару ![]() , всередині якого розміщуються всі отримані навчальні вектори, на основі зовнішньої експертної інформації встановлює три характеристики для системи навчання, а саме - порядкові номери та радіуси вкладених один в одний порожнистих гіпершарів, радіуси яких повинні бути меншими за зовнішній радіус гіпершару

, всередині якого розміщуються всі отримані навчальні вектори, на основі зовнішньої експертної інформації встановлює три характеристики для системи навчання, а саме - порядкові номери та радіуси вкладених один в одний порожнистих гіпершарів, радіуси яких повинні бути меншими за зовнішній радіус гіпершару ![]() , максимальне дозволене значення відстані між навчальними векторами, яке не повинне перевищуватись всередині будь-якого кластера, та максимальне значення відстані, яке не повинне перевищуватись між центроїдами двох кластерів, що об'єднують у складний кластер, для кожного навчального вектора

, максимальне дозволене значення відстані між навчальними векторами, яке не повинне перевищуватись всередині будь-якого кластера, та максимальне значення відстані, яке не повинне перевищуватись між центроїдами двох кластерів, що об'єднують у складний кластер, для кожного навчального вектора ![]() визначає двомірні координати кластера у вигляді порядкового номеру гіпершару та порядкового номеру тілесного кута, у межах яких розміщені кінцеві точки навчальних векторів, виділяє кластери, всередині яких відстані між навчальними векторами перевищують максимальні дозволені значення, виділяє квадранти системи координат, яка використовувалась для створення виділених кластерів, виконує операцію зменшення розмірів виділених кластерів, для чого переносить початки нових наступних за порядковими номерами систем координат у центри виділених квадрантів, в яких розміщені виділені кластери, для навчальних векторів

визначає двомірні координати кластера у вигляді порядкового номеру гіпершару та порядкового номеру тілесного кута, у межах яких розміщені кінцеві точки навчальних векторів, виділяє кластери, всередині яких відстані між навчальними векторами перевищують максимальні дозволені значення, виділяє квадранти системи координат, яка використовувалась для створення виділених кластерів, виконує операцію зменшення розмірів виділених кластерів, для чого переносить початки нових наступних за порядковими номерами систем координат у центри виділених квадрантів, в яких розміщені виділені кластери, для навчальних векторів ![]() кожного виділеного кластера в новій системі координат визначає двомірні координати зменшених кластерів, виділяє серед зменшених за розмірами кластерів ті з них, у яких всередині відстані між навчальними векторами перевищують максимальні дозволені значення, повторює операцію зменшення розмірів виділених кластерів до отримання дозволених відстаней між навчальними векторами в усіх отриманих кластерах, визначає кількість нейронів у шарі

кожного виділеного кластера в новій системі координат визначає двомірні координати зменшених кластерів, виділяє серед зменшених за розмірами кластерів ті з них, у яких всередині відстані між навчальними векторами перевищують максимальні дозволені значення, повторює операцію зменшення розмірів виділених кластерів до отримання дозволених відстаней між навчальними векторами в усіх отриманих кластерах, визначає кількість нейронів у шарі ![]() , яка дорівнює загальній кількості отриманих великих і малих кластерів, визначає вектори центроїдів всіх отриманих кластерів по координатах їх навчальних векторів, визначає відстані між всіма парами векторів-центроїдів отриманих кластерів і об'єднує пари кластерів у складний кластер, якщо відстань між їх векторами-центроїдами дорівнює або є меншою за максимальне дозволене значення для векторів-центроїдів, закріплює за отриманими кластерами їх центроїди, а за складними кластерами - сукупності центроїдів кластерів, що утворюють складний кластер, і завершує самонавчання тим, що при наявності складних кластерів утворює додатковий шар вихідних нейронів складних кластерів

, яка дорівнює загальній кількості отриманих великих і малих кластерів, визначає вектори центроїдів всіх отриманих кластерів по координатах їх навчальних векторів, визначає відстані між всіма парами векторів-центроїдів отриманих кластерів і об'єднує пари кластерів у складний кластер, якщо відстань між їх векторами-центроїдами дорівнює або є меншою за максимальне дозволене значення для векторів-центроїдів, закріплює за отриманими кластерами їх центроїди, а за складними кластерами - сукупності центроїдів кластерів, що утворюють складний кластер, і завершує самонавчання тим, що при наявності складних кластерів утворює додатковий шар вихідних нейронів складних кластерів ![]() , кожний нейрон якого має входи з ваговими коефіцієнтами 1, що з'єднані з виходами тих нейронів вихідного шару

, кожний нейрон якого має входи з ваговими коефіцієнтами 1, що з'єднані з виходами тих нейронів вихідного шару ![]() , які складають один складний кластер, і дає на виході сигнал при наявності на його входах хоча б одного сигналу.

, які складають один складний кластер, і дає на виході сигнал при наявності на його входах хоча б одного сигналу.

2. Спосіб самонавчання нейронної мережі за п. 1, який відрізняється іншим способом розділу виділених кластерів на менші кластери.

Текст

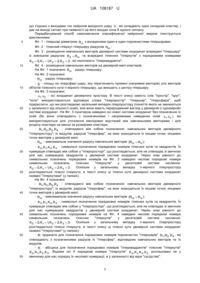

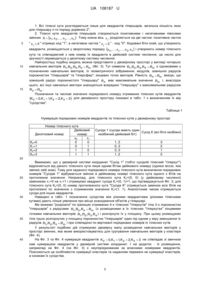

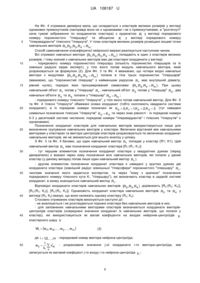

Реферат: UA 108187 U UA 108187 U Корисна модель належить до нейрокібернетики і може бути використана у нейрокомп'ютерах та штучних нейронних мережах для класифікації заданого на вході вектора вхідних даних X x1, x 2,, x j ,, xn . Відомий розроблений Т. Кохоненом спосіб самонавчання класифікуючої нейронної мережі векторного квантування (vector quantification, VQ), який призначений для класифікації заданого вектора вхідних даних X x1, x 2,, x j ,, xn за допомогою центроїдів кластерів і полягає у тому, що вхідний сенсорний шар нейронної мережі, кожний з n нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу X x1, x 2,, x j ,, xn , де j 12,,n - порядковий номер елемента вхідного сигналу X , , передає нормалізований вхідний сигнал X на кластерний шар, що складається з m нейронівцентроїдів, які мають позначення Y y1, y 2,, yi,, ym , де i 12,,m - порядковий номер , нейрона-центроїда, кожний з яких має записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера Wi w i1, w i2 ,, w ij,, w in і дозволяє оцінити відстань між 5 10 15 вектором вхідного сигналу X та вектором центроїда Wi , мінімум якої використовується для визначення переможця у; серед нейронів-центроїдів шару Y , використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів Wi w i1, w i2 ,, w ij,, w in нейрона-переможця yi шару Y з урахуванням додаткових внутрішніх даних [1-6]. Недоліками способу самонавчання класифікуючої нейронної мережі векторного квантування є зменшення точності класифікації через командний спосіб завдання кількості кластерів (нейронів в шарі Y ), яка може не відповідати їх дійсній кількості і може вести до помилок у класифікації, а також до зменшення функціональних можливостей через відсутність інформації стосовно реального розміщення, сусідства і зв'язків об'єктів класифікації у просторі змінних. Найбільш близьким до заявленого способу самонавчання класифікуючої нейронної мережі є вибраний за прототип спосіб самонавчання, який застосований в мережі Т. Кохонена, що зветься самоорганізувальною мапою (self-organizing feature map). Він використовує вхідний сенсорний шар, кожний з n нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу X x1, x 2,, x j ,, xn , де 20 25 30 j 12,,n - порядковий номер елемента вхідного сигналу X , передає нормалізований вхідний , сигнал X на кластерний шар, що складається з m нейронів-центроїдів, які мають позначення Y y1, y 2,, yi,, ym , де i 12,,m - порядковий номер нейрона-центроїда, кожний з яких має , записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера Wi w i1, w i2 ,, w ij,, w in і дозволяє оцінити відстань між вектором вхідного сигналу X та 35 45 50 55 вектором центроїда Wi , мінімум якої використовується для визначення переможця yi серед нейронів-центроїдів шару Y , використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів Wi w i1, w i2 ,, w ij,, w in нейрона-переможця yi шару Y з урахуванням архітектури вихідного 40 шару та додаткових внутрішніх даних [3, 5, 6]. Недоліками прийнятого за прототип способу самонавчання класифікуючої нейронної мережі по самоорганізувальній мапі Т. Кохонена є зменшення точності класифікації через командний спосіб завдання кількості кластерів та їх розміщення, яка може не відповідати дійсності і може вести до помилок у класифікації; зменшення функціональних можливостей через відсутність інформації стосовно реального розміщення, сусідства і зв'язків об'єктів класифікації у просторі змінних. Крім того, рандомізація ваг самоорганізувальної мапи Т. Кохонена може привести до проблем з визначенням кластерів та до ускладнення навчання [5, с. 195], і мапа Т. Кохонена "може формувати тільки класи, що являють собою опуклі області вхідного простору" [5, с. 196]. Причинами, які перешкоджають одержанню очікуваного технічного результату у прототипі (підвищення точності класифікації, збільшення функціональних можливостей), є прийнятий алгоритм роботи блока навчання та архітектура вихідного шару нейронної мережі. В основу пропонованого способу самонавчання нейронної мережі поставлена задача підвищення точності класифікації та збільшення її функціональних можливостей. Згідно з пропонованим способом проводиться по суті не навчання нейронної мережі, а групування всієї сукупності навчальних векторів по заздалегідь визначених кластерах, які упорядковано "географічно" розміщені в гіперсфері та у які попадають кінцеві точки навчальних векторів, бо обробляються лише їх координати. Спосіб прототипу має погіршені інтелектуальні можливості 1 UA 108187 U 5 10 через застосування командного методу призначення кількості кластерів, через їх взаємне розташування у вихідному шарі (у "лінійку", "прямокутник", "трикутник", "шестикутник" - з впливом такого розташування на навчання нейронів [6, с. 85]), через "відштовхування" "чужих" об'єктів від "своїх" кластерів-переможців, через поступове наближення до рішення [5, с. 194, рис. 11.15]; через відсутність порожніх кластерів [5, 6], які, хоча і не мають навчальних векторів, але поширюють уявлення про розподіл об'єктів у просторі ознак; через введення похибок в координати векторів центроїдів при урахуванні міри близькості між нейронами виходу по мапі заданої експертом архітектури розміщення вихідних нейронів. Загальні суттєві ознаки запропонованого способу самонавчання класифікуючої нейронної мережі, які співпадають із суттєвими ознаками прототипу, полягають у тому, що вхідний сенсорний шар нейронної мережі, кожний з n нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу X x1, x 2,, x j ,, xn , де j 12,,n - порядковий номер елемента вхідного сигналу X , , 15 передає нормалізований вхідний сигнал X на кластерний шар, що складається з m нейронівцентроїдів, які мають позначення Y y1, y 2,, yi,, ym , де i 12,,m - порядковий номер , нейрона-центроїда, кожний з яких має записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера Wi w i1, w i2 ,, w ij,, w in і дозволяє оцінити відстань між 20 25 вектором вхідного сигналу X та вектором центроїда Wi , мінімум якої використовується для визначення переможця yi серед нейронів-центроїдів шару Y , використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів Wi w i1, w i2 ,, w ij,, w in нейрона-переможця yi шару Y з урахуванням додаткових внутрішніх даних. Суттєві ознаки запропонованого способу самонавчання класифікуючої нейронної мережі, що є достатніми у всіх випадках і характеризують на відміну від прототипу, полягають у тому, що запропонований спосіб самонавчання класифікуючої нейронної мережі відрізняється тим, що блок навчання через n входів з ваговими коефіцієнтами 1 отримує з вхідного сенсорного шару всі навчальні нормалізовані вектори вхідних сигналів Xe x e1, x e2,, x ej ,, x en , де e 12,,E , 30 35 40 45 50 55 - порядковий номер навчального вектора, визначає зовнішній радіус гіпершару Rm , всередині якого розміщуються всі отримані навчальні вектори, на основі зовнішньої експертної інформації встановлює три характеристики для системи навчання, а саме - порядкові номери та радіуси вкладених один в один порожнистих гіпершарів, радіуси яких повинні бути меншими за зовнішній радіус гіпершару Rm , максимальне дозволене значення відстані між навчальними векторами, яке не повинне перевищуватись всередині будь-якого кластера, та максимальне значення відстані, яке не повинне перевищуватись між центроїдами двох кластерів, що об'єднують у складний кластер, для кожного навчального вектора Xe визначає двомірні координати кластера у вигляді порядкового номеру гіпершару та порядкового номеру тілесного кута, у межах яких розміщені кінцеві точки навчальних векторів, виділяє кластери, всередині яких відстані між навчальними векторами перевищують максимальні дозволені значення, виділяє квадранти системи координат, яка використовувалась для створення виділених кластерів, виконує операцію зменшення розмірів виділених кластерів, для чого переносить початки нових наступних за порядковими номерами систем координат у центри виділених квадрантів, в яких розміщені виділені кластери, для навчальних векторів Xe кожного виділеного кластера в новій системі координат визначає двомірні координати зменшених кластерів, виділяє серед зменшених за розмірами кластерів ті з них, у яких всередині відстані між навчальними векторами перевищують максимальні дозволені значення, повторює операцію зменшення розмірів виділених кластерів до отримання дозволених відстаней між навчальними векторами в усіх отриманих кластерах, визначає кількість нейронів у шарі Y , яка дорівнює загальній кількості отриманих великих і малих кластерів, визначає вектори центроїдів всіх отриманих кластерів по координатах їх навчальних векторів, визначає відстані між всіма парами векторівцентроїдів отриманих кластерів і об'єднує пари кластерів у складний кластер, якщо відстань між їх векторами-центроїдами дорівнює або є меншою за максимальне дозволене значення для векторів-центроїдів, закріплює за отриманими кластерами їх центроїди, а за складними кластерами - сукупності центроїдів кластерів, що утворюють складний кластер, і завершує самонавчання тим, що при наявності складних кластерів утворює додатковий шар вихідних нейронів складних кластерів Y , кожний нейрон якого має входи з ваговими коефіцієнтами 1, 2 UA 108187 U 5 10 15 20 25 30 35 40 45 50 55 що з'єднані з виходами тих нейронів вихідного шару Y , які складають один складний кластер, і дає на виході сигнал при наявності на його входах хоча б одного сигналу. Передбачуваний спосіб самонавчання класифікуючої нейронної мережі ілюструється кресленнями: Фіг. 1 - гіпершар діаметром Rm з вкладеними один в один порожнистими гіпершарами; Фіг. 2 - тілесний гіперкут гіпершару радіусом Rm ; Фіг. 3 - розміщення навчальних векторів двомірної системи координат всередині "гіпершару" із зовнішнім радіусом R4 Rm та всередині тілесних "гіперкутів" з порядковими номерами K 0 0,K1 1 K 2 2,K 3 3 , які охоплюють "гіперквадранти"; , Фіг. 4 - розміщення навчальних векторів на двомірній мапі кластерів. На Фіг. 1 позначено Rm - радіус гіпершару. На Фіг. 2 позначені: - Rm - радіус гіпершару; - S - площу на гіперсфері шару, яку перетинають промені (напрямки векторів) усіх векторів об'єктів тілесного кута n-мірного гіпершару, що виходять з центру гіпершару. На Фіг. 3 позначені: - x1, x2 - осі координат двомірного простору. В тексті опису замість слів "простір", "круг", "коло" використовуються відповідні слова "гіперпростір", "гіпершар", "гіперсфера", щоб підкреслити, що ми розглядаємо загальний випадок гіперпростору (поняття якого не змінюються у залежності від кількості осей), але вони мають перероджений вигляд у двомірній (і одномірній) системі координат. На Фіг. 3 пунктиром наведені осі нової системи координат без позначення їх осей (бо вони співпадають з позначеннями і напрямками наведених осей x1, x2 ), які використовуються для уточнення евклідових відстаней між навчальними векторами і для розділу кластера на менші за розмірами кластери; - R1,R2,R3,R4 - співпадаючі між собою позначення: навчальних векторів двомірного "гіперпростору"; їх модулів; радіусів "гіперсфер", на яких знаходяться їх кінцеві точки; кінцевих точок векторів у двомірній мапі; - Rm - максимальне значення радіусу навчальних векторів Rm R4 ; - K 0 ,K1,K 2,K 3 - символьні позначення порядкових номерів тілесних кутів та квадрантів. Їх нумерація співпадає між собою у "гіперпросторі", що розглядається, але не співпадає зі звичною для нас нумерацією квадрантів у двомірній системі координат. Через знак рівності до символьних позначень порядкових номерів на Фіг. 3 наведені числові порядкові номери символьних позначень тілесних "гіперкутів" у десятковій системі числення: K 0 0,K1 1 K 2 2,K 3 3 . Оскільки у загальному випадку n-мірного гіперпростору , розглядаються тілесні гіперкути, в тексті опису ці тілесні кути двомірної системи координат названі "гіперкутами" (у лапках). На Фіг. 4 позначені: - R1,R2,R3,R4 - співпадаючі між собою позначення: навчальних векторів двомірного "гіперпростору"; їх модулів; радіусів "гіперсфер", на яких знаходяться їх кінцеві точки; кінцевих точок векторів у двомірній мапі; - Rm - максимальне значення радіусу навчальних векторів Rm R4 ; - K 0 ,K1,K 2,K 3 - символьні позначення порядкових номерів тілесних кутів та квадрантів. Їх нумерація співпадає між собою у "гіперпросторі", що розглядається, але не співпадає зі звичною для нас нумерацією квадрантів у двомірній системі координат. Через знак рівності до символьних позначень порядкових номерів на Фіг. 4 наведені числові порядкові номери символьних позначень тілесних "гіперкутів" у десятковій системі числення: K 0 0,K1 1 K 2 2,K 3 3 . Оскільки у загальному випадку n-мірного гіперпростору , розглядаються тілесні гіперкути, в тексті опису ці тілесні кути двомірної системи координат названі "гіперкутами" (у лапках); - R ордината для позначення порядкових номерів порожнистих "гіпершарів" R1,R2,R4 , які співпадають з позначеннями радіусів їх "гіперсфер", відповідних навчальних векторів та їх модулів; - K - абсциса для позначення порядкових номерів "гіперквадрантів" тілесних "гіперкутів" K 0 ,K1,K 2,K 3 . Вздовж осі К порядкові номери "гіперкутів" K 0 ,K1,K 2,K 3 розташовані не у звичному для нас порядку їх числової нумерації, а у залежності від міри "сусідства". 3 UA 108187 U 5 10 Даний спосіб самонавчання належить до нейромереж прямого розповсюдження вхідного сигналу і може мати мінімум два шари нейронів, а максимум - три шари нейронів: - вхідний сенсорний шар X , призначений для отримання, розмноження і нормалізації вхідного сигналу у вигляді вектора з цифровими елементами (кількість нейронів дорівнює кількості ознак вхідного вектора); - вихідний кластерний шар Y , що складається з нейронів-центроїдів, на входах яких у вигляді вагових коефіцієнтів записані координати векторів центроїдів відповідних кластерів (кількість нейронів-центроїдів шару Y дорівнює кількості отриманих у процесі навчання кластерів); - вихідний шар складних кластерів Y , що складається з нейронів, які видають на виході сигнал, якщо сигнал виходу надає будь-який нейрон-центроїд кластерного шару Y , що входить у відповідний складний кластер (кількість нейронів шару Y дорівнює кількості отриманих у процесі навчання складних кластерів). Якщо у процесі навчання не виявлено складних 15 кластерів, то шар складних кластерів Y відсутній. Розглянемо деякі дані щодо характеристик класифікації, які використовуються у пропонованому способі самонавчання класифікуючої нейронної мережі. Початкові навчальні вхідні вектори нейронної мережі, які призначені для використання у способі самонавчання, звичайно мають числові змінні в абсолютних одиницях Xe x e1, x e2 ,, x ej ,, x en , де e 12,,E - порядковий номер навчального вектора; , 20 j 12,,n - порядковий номер елемента вхідного сигналу x ej ; x ej - j-та числова змінна е-го , навчального вектора з розміщенням центру координат в нульовій точці по всіх осях. У загальному випадку ці значення елементів вектора X e доцільно перерахувати у координати у відносних одиницях Xe x e1, x e2,, x ej ,, x en за формулою x ej x ej x max kj 1 1 , (1) 25 де x max - максимальне значення модуля координати деякого k-го навчального вектора kj 30 35 (для e k ) по j-й осі. Гіпершаром зветься геометричне тіло, всі точки поверхні якого знаходяться від центру на відстані, не більшої за радіус гіпершару Rm . Гіпершар можна розділити на кілька вкладених один в один порожнистих гіпершарів заданої експертом товщини (Фіг. 1). Тілесним кутом n-мірного гіпершару зветься частина його простору, яка є об'єднанням усіх векторів об'єктів, промені яких (напрямки векторів) виходять з центру гіпершару і перетинають деяку поверхню з площею S на гіперсфері шару (Фіг. 2). Тілесний кут з вершиною у центрі гіперсфери вимірюється в стерадіанах і дорівнює S / R2 - відношенню площі S (площа на гіперсфері гіпершару, на яку тілесний кут спирається) до квадрата радіуса сфери R . Модуль е-го навчального вектора розраховується у відносних одиницях за формулою Re 40 n x2 ej (2) j 1 і дорівнює радіусу n-мірного гіпершару (за тим же позначенням), всередині якого він знаходиться при розміщенні початку вектора Xe у центрі координат гіпершару, а кінця вектора Xe - на поверхні сфери гіпершару. Якщо позначити найбільший модуль R e деякого навчального вектора через Rm , то всі навчальні вектори Xe з власним напрямком спрямування знаходяться всередині n-мірного 45 гіпершару радіусом Rm Re . Для гіпершарів n-го порядку будемо дотримуватись наступних правил нумерації тілесних кутів у квадрантах: 4 UA 108187 U 1. Всі тілесні кути розглядаються лише для квадрантів гіпершарів, загальна кількість яких n для гіпершару n-го поряду дорівнює 2 . 2. Тілесні кути квадрантів гіпершарів створюються позитивними і негативними півосями змінних X x1, x 2,, x j ,, xn . Тому кожна вісь x j розділяється на дві частки: позитивна частка 5 10 15 " x j 0 " отримує код "1", а негативна частка " x j 0 " - код "0". Кодовані біти осей, що утворюють квадранти, розміщуються у зворотному порядку xn ,, x j ,, x 2 , x1 і утворюють номер тілесного кута та співпадаючий з ним номер їх квадранта в двійковій системі числення; це число для зручності переводиться у десяткову систему числення. Найпростішу подібну модель можна представити у двомірному просторі у вигляді чотирьох навчальних векторів R1,R2,R3,R4 Rm (Фіг. 3). Тут символи R1,R2,R3,R4 Rm є однаковими у позначеннях навчальних векторів, їх геометричного зображення, модулів, зовнішніх радіусів порожнистих "гіпершарів" та "гіперсфер"; кінцевих точок векторів. Рівність R4 Rm вказує, що зовнішній радіус порожнистого "гіпершару" R 4 має максимальне значення Rm і, внаслідок цього, всі інші навчальні вектори знаходяться всередині "гіпершару" з максимальним радіусом R4 Rm . Позначення та числові значення порядкового номеру отриманих тілесних кутів квадрантів K0 0,K1 1,K2 2,K3 3 для двомірного простору показані в табл. 1 з визначенням їх мір "сусідства". Таблиця 1 Нумерація порядкових номерів квадрантів та тілесних кутів у двомірному просторі Номер тілесного кута Двійковий номер Десятковий номер х2 x1 К0=0 0 0 К1=1 0 1 К2=2 1 0 К3=3 1 1 Сусіди 1 (сусіди мають один Сусід К (всі біти незбіжні) незбіжний двійковий біт) 1, 2 0, 3 3, 0 1, 2 3 2 1 0 20 25 30 35 40 Вважаємо, що у двомірній системі координат "Сусід 1" (тобто сусідній тілесний "гіперкут") відрізняється від даного тілесного кута лише одним бітом двійкового номеру (однією віссю, яка змінює свій знак). Тому для заданого порядкового номера тілесного кута визначення порядкових номерів "Сусідів 1" відбувається зміною в двійковому номері тілесного кута одного з бітів на протилежне значення. Наприклад, для тілесного кута К0=(0, 0) (у двійковому численні) замінюємо x1=0 на x1=1 і отримуємо квадрант сусіда К1=(0, 1)=1, що підтверджується Фіг. 3; для тілесного кута К0=(0, 0) номер протилежного кута "Сусіда К" отримується заміною всіх бітів на протилежні по значенню з отриманням значення К3=(1, 1). Аналогічним чином отримуються сусіди для інших квадрантів. Наведені в табл. 1 позначення сусідства між різними квадрантами (різними тілесними кутами) дають ліпше уявлення про місця знаходження об'єктів у гіпершарі. Ми можемо "розрізати" по границях отриманих 4-х тілесних "гіперкутів" тіла 3-х порожнистих "гіпершарів" з радіусами R1,R2,R4 Rm (з розміщеними в їх тілесних "гіперкутах" кінцевими точками навчальних векторів R1,R2 ,R3 ,R4 ) і розгорнути їх у площину. При цьому розміщуємо тіла трьох розгорнутих у площину порожнистих "гіпершарів" один під одним у міру зменшення їх радіусів R1,R2,R4 Rm і при співпадінні по вертикалі порядкових номерів їх тілесних кутів. У результаті подібних дій отримуємо двомірну мапу розміщення навчальних векторів у просторі змінних, яка може використовуватись для групування навчальних векторів у кластери (Фіг. 4). На Фіг. 3 та Фіг. 4 нумерація квадрантів K 0 0,K1 1 K 2 2,K 3 3 не співпадає зі звичною , нам нумерацією квадрантів у двомірній системі координат. І на додаток - їх розміщення, наприклад на Фіг. 4 (чи Фіг. 3) є неупорядкованим за власними номерами квадрантів. Пояснюється це особливістю нумерації кластерів та наданням переваги не нумерації кластерів, а ознакам їх сусідства. 5 UA 108187 U 5 10 15 20 25 30 35 40 45 На Фіг. 4 отримана двомірна мапа, що складається з кластерів великих розмірів у вигляді однакових прямокутників (насправді вони не є однаковими і не є прямокутниками, а "розтягнуті" наче гумові зображення по координатах кластера) з ординатою R у вигляді порядкового номеру порожнистого "гіпершару" та абсцисою K у вигляді порядкового номеру "гіперквадранта" тілесного "гіперкута". У тілах кластерів великих розмірів розміщені кінцеві точки навчальних векторів R1,R2,R3 ,R4 Rm . Спосіб самонавчання класифікуючої нейронної мережі реалізується наступним чином. Всі отримані навчальні вектори R1,R2,R3 ,R4 Rm попадають в один з кластерів великих розмірів, і тому кожний з навчальних векторів має дві кластерні координати у вигляді: - порядкового номеру порожнистого гіпершару (кількість порожнистих гіпершарів та їх зовнішні радіуси задає експерт), у тіло якого попав модуль навчального вектора, який розраховується за формулою (2). Для Фіг. 3 та Фіг. 4 вважаємо, що чотири вхідні навчальні вектори з модулями R1,R2,R3 ,R4 Rm попали в тіла трьох порожнистих "гіпершарів" (вважаємо, що "порожнистий гіпершар" з найменшим радіусом R1 має внутрішній діаметр, рівний нулю), порядок яких пронумерований символами При цьому навчальний об'єкт R1 попав у "гіпершар" R1 , навчальний об'єкт R 2 попав у "гіпершар" R 2 , два навчальні об'єкти R 3 та R 4 попали у "гіпершар" R4 Rm ; - порядкового номеру тілесного "гіперкута", у тіло якого попав навчальний вектор. Для Фіг. З та Фіг. 4 тілесні "гіперкути" обмежені осями координат (тобто охоплюють квадранти системи координат), а їх порядкові номери позначені як K 0 0,K1 1 K 2 2,K 3 3 (тут наведені , символьні позначення тілесних "гіперкутів" K 0 K 3 та через знак рівності - їх порядкові номери 0-3 у десятковій системі числення; порядкові номери "гіперквадрантів" і тілесних "гіперкутів" є однаковими). Позначення координат кластерів для навчальних векторів використовуються лише для визначення групування навчальних векторів у кластери. Величини відстаней між навчальними векторами у кластерах та вектори центроїдів кластерів розраховуються по величинах координат навчальних векторів, які не змінюються для всього аналізу у цілому. З Фіг. 3 та Фіг. 4 бачимо, що один навчальний вектор R1 попадає у кластер (R1; K1). Цей навчальний вектор R1 має позначення координат кластера [R1:(R1; K1)]: - тут першим елементом позначення координат кластера у квадратних дужках (перед двокрапкою) є вказані через кому позначення всіх навчальних векторів, які попали у даний кластер (у даному випадку попав лише один навчальний вектор R1 ); - другим елементом позначення координат кластера є наведені у круглих дужках дві координати кластера (зовнішній радіус зовнішньої "гіперсфери" порожнистого "гіпершару" R1 , числове значення якого задається експертом, та через "кому з крапкою" позначення порядкового номеру тілесного кута K1 "гіпершару"), які визначають кластер в заданій системі координат, в якому знаходиться навчальний вектор R1 . Відповідні координати кластерів навчальних векторів R2,R3 ,R4 дорівнюють [R2:(R2; K3)], [R3:(R4; K3)], [R4:(R4; K3)]. Однаковість координат кластера навчальних векторів R 3 та R 4 у вигляді (R4; К3) вказує, що вони належать одному кластеру (R4; K3). Стосовно отриманих кластерів виконуються наступні дії: - не аналізуються і не розглядаються порожні кластери без навчальних векторів в них; - для заповнених навчальними векторами кластерів визначаються координати векторівцентроїдів кластерів (осереднені значення координат їх навчальних векторів, що попали у кластер), які використовуються як вагові коефіцієнти на входах нейронів-центроїдів yi кластерного шару Y Wi w i1, w i2 ,, w ij,, w in 50 R1,R2,R4 Rm . (3) де i 12,,m - порядковий номер вектора нейрона-центроїда; , 1 w ij xiej - розраховане значення j-oї координати і-го вектора-центроїда, ki e записується як ваговий коефіцієнт j-гo входу і-го нейрона-центроїда yi ; 6 яке UA 108187 U ki - кількість навчальних векторів із загальної кількості E всіх навчальних векторів Xe x e1, x e2,, x ej ,, x en , де e 12,,E - порядковий номер навчального вектора, що попала , всередину і-го кластера; 5 xiej - елемент е-го навчального вектора, що попав у складі групи з ki векторів до і-го кластера; - розраховуються квадрати евклідових відстаней між всіма парами навчальних векторів з порядковими номерами e k та e (при k ), які попали у і-й кластер, Xik 10 xie k, j xie , j n 2 (4) j 1 які не повинні перевищувати квадрат заданого експертом максимального дозволеного значення відстані між всіма парами навчальних векторів всередині кластерів; визначаються квадрати відстаней між всіма парами векторів-центроїдів з порядковими номерами i та i (при ) Wi w i1, w i2 ,, w ij,, w in w 2 w i , j w i , j 2 , n (5) j 1 15 20 25 30 35 40 45 50 які не повинні перевищувати квадрат заданого експертом максимального дозволеного значення відстані між всіма парами центроїдів складних кластерів; - вирішальна перевага надається не нумерації кластерів, а мірам сусідства, у тому числі і особливим мірам сусідства, які у деяких випадках може розпізнати лише експерт. Ми розглядаємо автоматизовану систему. Остаточне рішення про об'єднання кластерів у складні кластери та у класи приймає експерт. Експерт може: - відмінити рішення ЕОМ; дати команду на розділ на частки будь-якого кластера; об'єднати між собою ті кластери, які належать до однакового класу, але розміщені у просторі змінних як завгодно далеко один від одного і навіть окремо; - керуватись важливістю мір сусідства не по кількості суміжних осей координат у просторі ознак, надавати вирішальну перевагу деяким окремим складовим по осях координат навчальних векторів, або їх сукупностям тощо. Об'єднання кластерів у складний кластер може також відбуватись автоматично по заданій експертом припустимій граничній дозволеній відстані між векторами центроїдів: якщо відстань між векторами центроїдів двох кластерів менша за задану експертом дозволену відстань, то ці два кластери об'єднуються у складний кластер. Складний кластер при збільшенні в ньому кількості об'єднаних кластерів у просторі змінних може набувати будь-якої форми: випуклої чи невипуклої фігури; "черв'яка", що охоплює своїм тілом весь простір змінних і вміщує центроїди з дуже великими відстанями між ними, що стосовно центроїдів віддалених кластерів перевищують задані експертом дозволені величини, але одночасно задовольняють вимогу експерта стосовно відстані до найближчого кластера, який входить у даний складний кластер. Відомо, що складний кластер у загальному випадку описується не одним вектором-центроїдом, а сукупністю векторів-центроїдів відповідних кластерів, що входять у складний кластер. Відповідно вважаємо, що центроїд кластера входить у складний кластер, якщо він має відстань до будь-якого з центроїдів складного кластера, меншу за дозволену експертом величину відстані між двома центроїдами. Припустимо, що по рішенню експерта навчальний вектор R1 утворює перший кластер, а навчальні вектори R1,R2,R4 у сукупності утворюють другий складний кластер. Якщо визначена експертом класифікація задовольняє вимогам по евклідовим відстаням між навчальними векторами всередині кластерів та між центроїдами отриманих кластерів, то виконують наступні дії: - кількість нейронів-центроїдів у шарі Y приймають рівною кількості заповнених навчальними векторами кластерів; - отримані координати центроїдів кластерів записують у шарі Y у вигляді вагових коефіцієнтів Wi w i1, w i2 ,, w ij,, w in входів відповідного нейрона-центроїда yi і-го кластера; 7 UA 108187 U - визначають загальну кількість отриманих складних кластерів і утворюють додатковий шар 5 10 15 20 25 30 35 вихідних нейронів для складних кластерів Y (у даному випадку ми отримали один складний кластер). Кожний вихідний нейрон шару складних кластерів Y підсумовує вихідні сигнали нейронів шару Y , що належать одному зі складних кластерів; кожний нейрон шару складних кластерів Y має один вихід та має кількість входів з ваговими коефіцієнтами 1, яка дорівнює кількості кластерів, що утворюють даний складний кластер і з'єднаний своїми входами з відповідними виходами нейронів шару Y . Після виконання вказаних дій навчання нейронної мережі є завершеним і нейронна мережа може використовуватись для класифікації вхідних векторів. Якщо евклідові відстані між навчальними векторами всередині кластера є більшими за дозволені експертом значення, то це означає незавершеність навчання у зв'язку з необхідністю розділити такий кластер на менші кластери. Подібний розділ великих кластерів на менші потрібно виконувати неодноразово до задоволення вимог експерта стосовно заборони перевищення дозволених значень евклідових відстаней між навчальними векторами всередині великих і малих кластерів. Слід ураховувати, що розрахунки кластерних координат спрямовані на визначення групування навчальних векторів, а розрахунки відстаней між навчальними векторами, розрахунки координат векторів центроїдів та відстаней між центроїдами виконуються по початкових значеннях координат навчальних векторів, які не змінюються протягом всього аналізу. Кластери можна зменшити збільшенням кількості вкладених порожнистих гіпершарів, чи розділом (за різними способами) на частки тілесних кутів. Але більш універсальним є метод перенесення початку координат, бо він зменшує одразу дві координати кластера: вздовж осі радіусу гіперсфери та вздовж осі тілесного кута. З цією метою помічаємо кластер, який потрібно розділити на менші кластери та помічаємо відповідний квадрант системи координат, де розміщується помічений кластер і який потрібно розділити на частки новою системою координат. На Фіг. 3 пунктиром наведені осі нової системи координат без позначення її осей (бо вони співпадають з позначеннями і напрямками наведених осей x1, x2 ), які використовуються для розділу поміченого кластера на менші за розмірами кластери з метою розділу навчальних векторів по менших кластерах і наступного уточнення евклідових відстаней між новоутвореними групами навчальних векторів менших кластерів. Нові координати навчальних векторів в новій декартовій системі координат мають значення xH x j xC , де xH - нові значення координат; x C - значення координат центру нової системи j j j j координат у старій системі координат (наприклад, для центру поміченого старого квадранта у відносних одиницях xC 0,5 , де знак «±» залежить від розміщення квадранта; в якості j "центру" поміченого кластера можна обрати координати кінцевої точки його центроїда xC wij і j 40 45 50 т.д.); x j - старі значення координат. По знаках числових значень координат помічених навчальних векторів у новій системі координат визначаються кластерні координати зменшених кластерів, в яких розміщені помічені навчальні вектори, і додаються до старих координат помічених навчальних векторів. Загальна кількість подібних вказаних уточнень старих координат кластера визначає кількість систем координат, використаних для одного навчального вектора, і надає можливість розрахувати, у скільки разів скорочений початковий об'єм "гіперквадранта". Для двомірної системи координат n 2 за одне введення нових координат кластера вказаний об'єм скорочується в 2n 22 4 рази. Зменшення об'ємів кластерів впливає лише на визначення групування навчальних векторів, але не на їх модулі. Аналіз відстаней з урахуванням наявності нових менших кластерів виконується по формулах (3)-(5) з використанням описаного вище алгоритму при незмінних початкових значеннях координат навчальних векторів, але з урахуванням наявності нових груп навчальних векторів. Ми розглянули принципи визначення координат кластера навчальних векторів у двомірному просторі, які цілком використовуються для розрахунків у n-мірному просторі будь-якої розмірності. 8 UA 108187 U 5 Потрібно помітити, що при збільшенні кількості осей координат ускладнюється наочність розміщення на двомірній мапі кластерів з урахуванням їх сусідства. Тому сусідство при великій розмірності n-мірного простору потрібно або розраховувати, або визначати по таблиці. Розглянемо спочатку визначення тілесних кутів у тримірному просторі. Нумерація квадрантів та тілесних кутів у тримірному просторі показана в табл. 2. Таблиця 2 Нумерація квадрантів та тілесних кутів у трьохмірному просторі Номер тілесного кута Десятковий Двійковий номер Сусіди 1 (мають Сусіди 2 (мають два один незбіжний біт) незбіжних біти) номер Ki x3 х2 x1 і 0 0 0 0 1, 2, 4 3, 5, 6 1 0 0 1 0, 3, 5 2, 4, 7 2 0 1 0 0, 3, 6 1, 4, 7 3 0 1 1 1, 2, 7 0, 5, 6 4 1 0 0 0, 5, 6 1, 2, 7 5 1 0 1 1, 4, 7 0, 3, 6 6 1 1 0 2, 4, 7 0, 3, 5 7 1 1 1 3, 5, 6 1, 2, 4 10 15 20 Сусід K (всі біти незбіжні) 7 6 5 4 3 2 1 0 Порядкові номери "Сусідів 1" в двійковій та десятковій системах числення тілесного кута К0=0, 0, 0=0 зі значенням двійкового номеру (х3=0, х2=0, x1=0) визначаємо наступним чином: 1. Замінюємо один біт x1=0 на протилежне значення і отримуємо номер "Сусіда 1" "K1=0, 0, 1=1"; 2. Замінюємо біт х2=0 на протилежне значення і отримуємо номер іншого "Сусіда 1" "К2=0, 1, 0=2"; 3. Замінюємо біт х3=0 на протилежне значення і отримуємо третій номер "Сусіда 1" "К 4=1, 0, 0=4". Для тілесного кута K0=0 можна отримати номери "Сусідів 2", у яких з тілесним кутом К 0=0 є незбіжними два біти (дві осі координат) двійкового номеру К0=0: 3, 5, 6. Аналогічним чином отримуємо номери "Сусідів 2" для інших тілесних кутів. Для тілесного кута K0=0 номер протилежного тілесного кута "Сусіда K" отримується заміною двійкового номеру "0, 0, 0" на протилежні значення "1, 1, 1". Аналогічним чином отримуємо номери "Сусіда K" для інших тілесних кутів. Maпy кластерів табл. 3 уявляємо розміщеною на шарі зі "склеєними боками": тоді кожний квадрант має три сусідні квадранти. Як приклад, для кластера (тілесного кута, квадранта) К0=0 номери кластерів "Сусідів 1" виділені сірим фоном. 25 Таблиця 3 Двомірна мапа кластерів з урахуванням взаємного розміщення кластерів (тілесних кутів та квадрантів) тримірного простору для осей (х1, х2, х3) з урахуванням "Сусідів 1" 4 0 30 35 5 1 7 3 6 2 У табл. 3 для двомірної мапи наведена лише великі за розмірами кластери двомірної мапи, на які розділений "гіпершар" тримірного простору для осей (x1, х2, х3). Тому у дійсності в комірки табл. 3 повинні записуватись кластери з групуванням по зміні радіусу їх "гіпершарів"; з групуванням по уточнених координатах нумерації гіперкутів, які отримуються при застосуванні нових систем координат; із вказівкою кількості навчальних векторів, які попали у дані кластери тощо (ця інформація в табл. 3 не наведена). Порядок визначення відстаней між навчальними векторами всередині кластерів, розрахунок координат векторів центроїдів та відстаней між ними, порядок зміни даних нейронної мережі описаний вище і не змінюється. Нумерація кластерів (тілесних кутів та квадрантів) у чотиримірному просторі наведена у табл. 4. 9 UA 108187 U Таблиця 4 Нумерація кластерів (тілесних кутів та квадрантів) у чотиримірному просторі. Номер тілесного кута Двійковий номер Десятковий номер Ki х4 х3 х2 x1 0 0 0 0 0 1 0 0 0 1 2 0 0 1 0 3 0 0 1 1 4 0 1 0 0 5 0 1 0 1 6 0 1 1 0 7 0 1 1 1 8 1 0 0 0 9 1 0 0 1 10 1 0 1 0 11 1 0 1 1 12 1 1 0 0 13 1 1 0 1 14 1 1 1 0 15 1 1 1 1 5 10 15 Сусіди 1 (мають один Сусід K (всі біти незбіжні) незбіжний біт) 1, 2, 4, 8 0, 3, 5, 9 0, 3, 6, 10 1, 2, 7, 11 0, 5, 6, 12 1, 4, 7, 13 2, 4, 7, 14 3, 5, 6, 15 0, 9, 10, 12 1, 5, 11, 13 2, 8, 11, 13 3, 9, 10, 15 4, 8, 13, 14 5, 9, 12, 15 6, 10, 12, 15 7, 11, 13, 14 15 14 13 12 11 10 9 8 7 6 5 4 3 2 2 1 У чотиримірному просторі маємо 2n 24 16 квадрантів (16 початкових кластерів на одному радіусі гіперсфери). Кожний кластер чотиримірного простору (кожний тілесний кут квадранта) має: 4-х "Сусідів 1", у яких один біт незбіжний; 3-х "Сусідів 2", у яких два біти незбіжні; 2-х "Сусідів 3", у яких три біти незбіжні; одного "Сусіда K", у якого всі чотири біти незбіжні. У табл. 4 для її скорочення перелічені лише "Сусіди 1". Наприклад, для кластера тілесного кута K0=(0, 0, 0, 0) номер "Сусіда 1" визначається зміною у двійковому номері одного з бітів на протилежний: замінюємо x1=0 на x1=1 й отримуємо номер квадранта сусіда K1=(0, 0, 0, 1)=1. Аналогічним чином отримуються сусіди для інших квадрантів. Для тілесного кута K0=(0, 0, 0, 0)=0 номер протилежного кута визначається заміною всіх бітів на протилежні K15 =(1, 1, 1, 1)=15. Для К0=(0, 0, 0, 0) при зміні двох бітів на протилежні отримуємо "Сусіда 2" у вигляді тілесного кута K10=(1, 0, 1, 0)=10; при зміні трьох бітів на протилежні отримуємо "Сусіда 1" у вигляді тілесного кута K7=(0, 1, 1, 1)=7. Для кластерів чотиримірного простору мала кластерів з нумерацією гіперкутів кластерів і з дотриманням сусідства по лінії "Сусідів 1" на поверхні гіперсфери наведена в табл. 5. Для тілесного кута K0=0 в табл. 5 сірим фоном виділені сусідні тілесні кути. Таблиця 5 Нумерація кластерів (квадрантів та тілесних кутів) на двомірній мапі кластерів у чотиримірному просторі з урахуванням "Сусідів 1" 8 0 4 12 9 1 5 13 11 3 7 15 10 2 6 14 20 25 Maпy кластерів табл. 5 уявляємо розміщеною на шарі зі "склеєними боками": тоді кожний квадрант має чотири сусідні квадранти. Як приклад, для кластера (тілесного кута, квадранта) К0=0 номери кластерів "Сусідів 1" виділені сірим фоном. У табл. 5 наведені лише великі за розмірами кластери двомірної мапи. У дійсності в кожну наведену комірку табл. 5 вписуються дані отриманих кластерів у вигляді їх кластерних адрес із групуванням кластерів по їх радіусах гіпершарів, по уточнених номерах гіперкутів, із вказівкою 10 UA 108187 U 5 кількості навчальних векторів, які попали в кластери, та наводиться інша інформація (ці перелічені дані в табл. 5 не показані). Порядок визначення відстаней між навчальними векторами всередині кластерів, розрахунок координат векторів центроїдів та відстаней між ними, порядок зміни даних нейронної мережі описаний вище і не змінюється. Нумерація кластерів (тілесних кутів та квадрантів) у п'ятимірному просторі наведена у табл. 6. Таблиця 6 Нумерація кластерів (тілесних кутів та квадрантів) у п'ятимірному просторі Номер тілесного кута Двійковий номер Десятковий номер Ki х5 х4 x3 х2 0 0 0 0 0 1 0 0 0 0 2 0 0 0 1 3 0 0 0 1 4 0 0 1 0 5 0 0 1 0 6 0 0 1 1 7 0 0 1 1 8 0 1 0 0 9 0 1 0 0 10 0 1 0 1 11 0 1 0 1 12 0 1 1 0 13 0 1 1 0 14 0 1 1 1 15 0 1 1 1 16 1 0 0 0 17 1 0 0 0 18 1 0 0 1 19 1 0 0 1 20 1 0 1 0 21 1 0 1 0 22 1 0 1 1 23 1 0 1 1 24 1 1 0 0 25 1 1 0 0 26 1 1 0 1 27 1 1 0 1 28 1 1 1 0 29 1 1 1 0 30 1 1 1 1 31 1 1 1 1 10 15 x1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 0 1 Сусіди 1 (мають один незбіжний біт) Сусід K (всі біти незбіжні) 1, 2, 4, 8, 16 0, 3, 5, 9, 17 0, 3, 6, 10, 18 1, 2, 7, 11, 19 0, 5, 6, 12, 20 1, 4, 7, 13, 21 2, 4, 7, 14, 22 3, 5, 6, 15, 23 0, 9, 10, 12, 24 1, 8, 11, 13, 25 2, 8, 11, 14, 26 3, 9, 10, 15, 27 4, 8, 13, 14, 28 5, 9, 12, 15, 29 6, 10, 12, 15, 30 7, 11, 13, 14, 31 0, 17, 18, 20, 24 1, 16, 19, 21, 25 2, 16, 19, 22, 26 3, 17, 18, 23, 27 4, 16, 21, 22, 28 5, 17, 20, 23, 29 6, 18,20, 23, 30 7, 19, 21, 22, 31 8, 16, 25, 26, 28 9, 17, 24, 27, 29 10, 18, 24, 27, 30 11, 19, 25, 26, 31 12, 20, 24, 29, 30 13, 21, 25, 28, 31 14, 22, 26, 28, 31 15, 23, 27, 29, 30 31 30 29 28 27 26 25 24 23 22 21 20 19 18 17 16 15 14 13 12 11 10 9 8 7 6 5 4 3 2 1 0 У п'ятимірному просторі маємо 2n 25 32 квадранти (32 початкових кластерів на одному радіусі гіперсфери). Кожний кластер у п'ятимірному просторі (кожний тілесний кут квадранта) має: 5-х "Сусідів 1", у яких один біт незбіжний; 4-х "Сусідів 2", у яких два біти незбіжні; 3-х "Сусідів 3", у яких три біти незбіжні; 2-х "Сусідів 2", у яких два біти незбіжні; одного "Сусіда К", у якого всі п'ять бітів незбіжні. У табл. 6 для її скорочення перелічені лише "Сусіди 1". Наприклад, для кластера тілесного кута K0=(0, 0, 0, 0, 0) номер "Сусіда 1" визначається зміною у двійковому номері одного з бітів на протилежний: замінюємо x1=0 на x1=1 і отримуємо номер квадранта сусіда K1=(0, 0, 0, 0, 1)=1. Аналогічним чином отримуються сусіди для інших квадрантів. Для тілесного кута K0=(0, 0, 0, 0, 0)=0 номер протилежного кута визначається заміною всіх бітів на протилежні K15=(1, 1, 1, 1, 1)=31. 11 UA 108187 U 5 Для K0=(0, 0, 0, 0, 0) при зміні двох бітів на протилежні отримуємо "Сусіда 2" у вигляді кластера тілесного кута K10=(0, 1, 0, 1, 0)=10; при зміні трьох бітів на протилежні отримуємо "Сусіда 3" у вигляді кластера тілесного кута K7=(0, 0, 1, 1, 1)=7. Двомірна мапа кластерів п'ятимірного простору показана як табл. 7 з розміщеними по порядку номерами кластерів (квадрантів, тілесних кутів), але без дотримання умов сусідства (сусідство для кожного кластера або розраховується, або встановлюється по табличних даних). Таблиця 7 Нумерація квадрантів та тілесних кутів на мапі кластерів для п'ятимірного простору 0 8 16 24 10 15 20 25 30 35 40 1 9 17 25 2 10 18 26 3 11 19 27 4 12 20 28 5 13 21 29 6 14 22 30 7 15 23 31 У табл. 7 сірим фоном помічені номери комірок 1, 16, 19, 21, 25, які є "Сусідами 1" для кластера 17. У табл. 7 наведені лише великі за розмірами кластери двомірної мапи. У дійсності в кожну наведену комірку табл. 7 вписуються дані отриманих кластерів у вигляді їх кластерних адрес з групуванням кластерів по їх радіусах гіпершарів; по уточнених номерах гіперкутів; з вказівкою кількості навчальних векторів, які попали в кластери, та наводиться інша інформація (ці перелічені дані в табл. 7 не показані). Порядок визначення відстаней між навчальними векторами всередині кластерів, розрахунок елементів векторів центроїдів та відстаней між ними, порядок зміни даних нейронної мережі описаний вище і не змінюється. Пропонований спосіб самонавчання класифікуючої нейронної мережі пристосований також до класифікації стохастичних навчальних векторів: для цього навчальні вектори вибірки визначеного класу А розподіляють за їх координатами по кластерах, для яких по отриманих розподілах навчальних векторів вибірки визначають функцію густини ймовірностей f A . Вважаємо, що для класу А відома апріорна ймовірність класу h A та ціна похибки класифікації c A . Тоді для вхідного вектора, який потрібно класифікувати і який попав у даний кластер, з двох класів А та В, по яких класифікується вхідний вектор, за Байєсовим класифікатором [5, с. 219; 6, с. 154] обирається клас А, якщо hAc A fA hBcBfB . Зазвичай вважається, що добутки c A fA та c B fB є однаковими. Спосіб самонавчання класифікуючої нейронної мережі збільшує точність класифікації через визначення реальної кількості кластерів, їх реального розміщення у просторі змінних та урахування сусідства навчальних векторів; спосіб надає можливість аналізувати стохастичні дані і отримати складні кластери будь-якої форми, які можуть охоплювати весь простір змінних. Джерела інформації: 1. Kohonen Т. Correlation Matrix Memories // IEEE Trans, on Computers. -1972. - Vol. 21. - P. 253-269. 2. Kohonen T. Associative Memory: A System Theoretic Approach. - Berlin: Springer, 1977. 3. Kohonen T. Self-Organizing Formation of Topologically Correct Feature Maps // Biological Cybernetics. - 1982. - Vol. 43. - P. 59-69. 4. Kohonen T. The Self-Organizing Map // Proc. of IEEE. - 1990. - Vol. 78. - № 9. - P. 1464-1480. 5. Руденко О.Г., Бодянський С.В. Штучні нейронні мережі. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. 6. Калан Р. Основные концепции нейронных сетей.: Пер. с англ. - М.: Издательский дом "Вильяме", 2003. - 288 с. 45 ФОРМУЛА КОРИСНОЇ МОДЕЛІ 50 1. Спосіб самонавчання класифікуючої нейронної мережі, який полягає у тому, що вхідний сенсорний шар нейронної мережі, кожний з n нейронів якого з одним входом з ваговим коефіцієнтом 1 та з одним виходом, нормалізує та розмножує елемент вектора вхідного сигналу X x1, x2, , x j, , xn , де j 1 2, , n - порядковий номер елемента вхідного сигналу X , , 12 UA 108187 U передає нормалізований вхідний сигнал X на кластерний шар, що складається з m нейронівцентроїдів, які мають позначення Y y1, y2, , yi, , ym , де i 1 2, , m - порядковий номер , нейрона-центроїда, кожний з яких має записаний на його входах у вигляді вагових коефіцієнтів вектор центроїда і-го кластера Wi wi1, wi2, , wij, , win і дозволяє оцінити відстань між 5 вектором вхідного сигналу X та вектором центроїда Wi , мінімум якої використовується для визначення переможця yi серед нейронів-центроїдів шару Y , використовує блок навчання, що за принципом "переможець отримує все" у процесі навчання уточнює значення вагових коефіцієнтів Wi wi1, wi2, , wij, , win нейрона-переможця yi шару Y з урахуванням 10 15 20 25 30 35 40 додаткових внутрішніх даних, який відрізняється тим, що блок навчання через n входів із ваговими коефіцієнтами 1 отримує з вхідного сенсорного шару всі навчальні нормалізовані вектори вхідних сигналів Xe xe1, xe2, , xej, , x en , де e 1 2, , E - порядковий номер , навчального вектора, визначає зовнішній радіус гіпершару Rm , всередині якого розміщуються всі отримані навчальні вектори, на основі зовнішньої експертної інформації встановлює три характеристики для системи навчання, а саме - порядкові номери та радіуси вкладених один в одний порожнистих гіпершарів, радіуси яких повинні бути меншими за зовнішній радіус гіпершару Rm , максимальне дозволене значення відстані між навчальними векторами, яке не повинне перевищуватись всередині будь-якого кластера, та максимальне значення відстані, яке не повинне перевищуватись між центроїдами двох кластерів, що об'єднують у складний кластер, для кожного навчального вектора X e визначає двомірні координати кластера у вигляді порядкового номеру гіпершару та порядкового номеру тілесного кута, у межах яких розміщені кінцеві точки навчальних векторів, виділяє кластери, всередині яких відстані між навчальними векторами перевищують максимальні дозволені значення, виділяє квадранти системи координат, яка використовувалась для створення виділених кластерів, виконує операцію зменшення розмірів виділених кластерів, для чого переносить початки нових наступних за порядковими номерами систем координат у центри виділених квадрантів, в яких розміщені виділені кластери, для навчальних векторів X e кожного виділеного кластера в новій системі координат визначає двомірні координати зменшених кластерів, виділяє серед зменшених за розмірами кластерів ті з них, у яких всередині відстані між навчальними векторами перевищують максимальні дозволені значення, повторює операцію зменшення розмірів виділених кластерів до отримання дозволених відстаней між навчальними векторами в усіх отриманих кластерах, визначає кількість нейронів у шарі Y , яка дорівнює загальній кількості отриманих великих і малих кластерів, визначає вектори центроїдів всіх отриманих кластерів по координатах їх навчальних векторів, визначає відстані між всіма парами векторів-центроїдів отриманих кластерів і об'єднує пари кластерів у складний кластер, якщо відстань між їх векторами-центроїдами дорівнює або є меншою за максимальне дозволене значення для векторів-центроїдів, закріплює за отриманими кластерами їх центроїди, а за складними кластерами - сукупності центроїдів кластерів, що утворюють складний кластер, і завершує самонавчання тим, що при наявності складних кластерів утворює додатковий шар вихідних нейронів складних кластерів Y , кожний нейрон якого має входи з ваговими коефіцієнтами 1, що з'єднані з виходами тих нейронів вихідного шару Y , які складають один складний кластер, і дає на виході сигнал при наявності на його входах хоча б одного сигналу. 2. Спосіб самонавчання нейронної мережі за п. 1, який відрізняється іншим способом розділу виділених кластерів на менші кластери. 13 UA 108187 U Комп’ютерна верстка А. Крижанівський Державна служба інтелектуальної власності України, вул. Василя Липківського, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут інтелектуальної власності”, вул. Глазунова, 1, м. Київ – 42, 01601 14

ДивитисяДодаткова інформація

МПК / Мітки

МПК: G06N 3/00

Мітки: спосіб, класифікуючої, мережі, нейронної, самонавчання

Код посилання

<a href="https://ua.patents.su/16-108187-sposib-samonavchannya-klasifikuyucho-nejjronno-merezhi.html" target="_blank" rel="follow" title="База патентів України">Спосіб самонавчання класифікуючої нейронної мережі</a>

Попередній патент: Спосіб лапароскопічної пластики гриж стравохідного отвору діафрагми з використанням поліпропіленового сітчастого трансплантата

Наступний патент: Спосіб оцінки ефективності проведеного лікування у пацієнтів з ішемічною хворобою серця та метаболічним синдромом, що перенесли стентування коронарних судин

Випадковий патент: Спосіб пластики передньої третини верхньої стрілової пазухи трансплантатом із підшкірної вени верхньої кінцівки