Нечітка нейронна мережа

Номер патенту: 97763

Опубліковано: 10.04.2015

Автори: Кутковецький Валентин Якович, Турти Марина Валентинівна

Формула / Реферат

Нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2, …, xj, …, xn), з нечіткими множинами, розміщеними вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюється у межах від "0" до "1" у діапазоні значень нечіткої множини, яка відрізняється тим, що як нечітка множина враховується її частка під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності, перший шар нейронної мережі має на кожний нечіткий фрагмент осі xj один нейрон XPj, aj, де j=1, 2,…, n- порядковий номер осі, aj=1, 2,…, Aj - порядковий номер нечіткого фрагмента вздовж j-οϊ осі (з позначенням нейронів по їх вихідних сигналах), який складається лише з активаційної функції і має один вхід з увімкненою до нього відповідною змінною xj та один вихід, призначений для видачі величини активаційної функції XPj,aj у вигляді прямокутного сигналу зі значеннями "1" у межах нечіткого фрагмента осі xj та "0" у іншому разі, другий шар складається з Μ нейронів Bma1, a2,…, an з порядковими номерами m=1, 2,…, М, де Μ - загальна кількість інформаційних модулів нейронної мережі, кожний з яких складається з гіпероб'єму, обмеженого по усіх осях xj відповідними значеннями нечітких фрагментів з порядковими номерами a1, a2,…, an, має n входів з ваговими коефіцієнтами "1", до яких увімкнені відповідні виходи нейрона першого шару XPj,aj, нечіткі фрагменти яких утворюють для одного нейрона Bma1, a2,…,an у сукупності один відповідний інформаційний модуль, має вихід, призначений для видачі значення Bma1, a2,…, an=1, якщо на всі його входи подані величини XPj,aj=1, і видачі на виході значення Bma1, a2,…, an=0 у іншому випадку, третій шар складається з Μ нейронів Fma1, a2,…, an без активаційної функції, кожний з яких має керуючий вхід з ваговим коефіцієнтом "1", на який увімкнений вихід відповідного нейрона другого шару Bma1, a2,…, an, має нульовий вхід з ваговим коефіцієнтом "w0m", до якого увімкнена постійна вхідна величина х0=1, має n координатних входів з ваговими коефіцієнтами wjm, до яких увімкнені відповідні значення змінних xj входів нейронної мережі, і має вихід, призначений для видачі значення вихідної функції m-го інформаційного модуля Fma1, a2,…, an=Υ(x1, x2, …, xj, …, xn) при зміні xj лише у межах об'єму координат інформаційного модуля та Fma1, a2,…, an=0 у іншому випадку, четвертий шар складається з одного нейрона без активаційної функції з Μ входами при рівних "1" вагових коефіцієнтах, до яких увімкнені виходи нейронів третього шару Fma1, a2,…, an, і з виходом, призначеним для видачі підсумку виходів всіх нейронів інформаційних модулів третього шару.

Текст

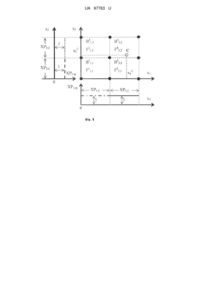

Реферат: UA 97763 U UA 97763 U 5 10 15 20 25 30 35 40 45 50 55 Корисна модель належить до обчислювальної техніки і може використовуватися для створення експертних систем та підсистем прийняття рішень у складі складних автоматичних систем управління та систем штучного інтелекту, у тому числі - для управління технологічними процесами в машинобудуванні, в авіаційній техніці, на транспорті, тощо. Відома нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2,…, xj, …, xn), з нечіткими множинами, розміщеними вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. При цьому для отримання вихідного результату Υ(x1, x2,…, xj, …, xn) у лінгвістичній або числовій формі використовуються наступні блоки: фаззифікатор, який перетворює числові значення кожної нечіткої множини у лінгвістичні нечіткі множини з використанням функцій належності у вигляді трикутних, гаусівських та інших залежностей; машини нечіткого логічного висновку, які реалізують системи нечіткого висновку; дефаззифікатор, який ставить у відповідність лінгвістичному нечіткому значенню деяке чітке цифрове значення вихідного параметра. Трансформація нечіткої множини у точкове рішення виконується за багатьма способами. Традиційно система нечіткого висновку вміщує: множину нечітких правил висновку; базу описів функції належності; механізм висновку, який створюється на базі правил висновку. Питання фаззифікації та дефаззифікації розглянуті в роботі [1]. Одним із засобів їх реалізації можуть бути нейронні мережі [1, рис. 2.1]. Недоліком такого пристрою є складність аналізу, збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу. Відома нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2,…, xj, …, xn), з нечіткими множинами, розміщеними вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. Перевагою даної мережі, яка використовує основні блоки попереднього пристрою (фаззифікатор, машину висновку, дефаззифікатор), є модульний принцип виконання роботи з використанням у нейронній мережі уніфікованих модулів двох базових типів: алгоритмічного, з виконанням програми, та функціонального, з таблицею комутації і таблицею шлюзування, які є результатом навчання [2; 3; 4; 5]. Недоліком даного пристрою є складність аналізу, збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу, оскільки виконується ускладнений розрахунок, який вміщує процеси фаззифікації та дефаззифікації. Найбільш близькою до заявленої нечіткої нейронної мережі за сукупністю суттєвих ознак є обрана за прототип відома нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2,…, xj, …, xn), з нечіткими множинами, розміщеними вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. При цьому для отримання вихідного результату Υ(x1, x2,…, xj, …, xn) У лінгвістичній або числовій формі використовуються фаззифікатор, машини нечіткого логічного висновку, дефаззифікатор [6]. Недоліком прийнятого за прототип пристрою є складність аналізу, збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу, у зв'язку із тим, що виконується ускладнений розрахунок, який вміщує процеси фаззифікації та дефаззифікації. Причини, які перешкоджають одержанню очікуваного технічного результату у прототипі (спрощення аналізу та зменшення часу розв'язання проблеми), є складність методу обробки даних, який ґрунтується на роботі [7]. В основу пропонованої корисної моделі поставлена задача зменшення вартості обладнання за рахунок обмеження об'єму виконуваних операцій на основі робіт [8; 9] та спрощення операції навчання нейронної мережі. Пропонована мережа має лише один шар нейронів, вагові коефіцієнти входів яких потрібно навчати, у той час як у відомих багатошарових мережах потрібно навчати нейрони всіх шарів, за винятком вхідного сенсорного шару, який традиційно використовується для розмноження та нормалізації вхідних сигналів. Загальні суттєві ознаки запропонованої нечіткої нейронної мережі, які співпадають із суттєвими ознаками прототипу, полягають у тому, що нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2,…, xj, …, xn), із нечіткими множинами, розміщеними вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. 1 UA 97763 U 5 10 15 20 25 30 35 40 45 50 55 Суттєві ознаки нейронної нечіткої системи, що є достатніми у всіх випадках і характеризують запропоновану корисну модель на відміну від прототипу, полягають у тому, що замість нечіткої множини ураховується лише її частка під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності, перший шар нейронної мережі має на кожний нечіткий фрагмент осі xj один нейрон XPj, j, де j=1, 2,…, n - порядковий номер осі, j=1, 2,…, Aj - порядковий номер нечіткого фрагмента вздовж j-οϊ осі (з позначенням нейронів по їх вихідних сигналам), який складається лише з активаційної функції і має один вхід з увімкненою до нього відповідною змінною xj та один вихід, призначений для видачі величини активаційної функції XPj, j У вигляді прямокутного сигналу зі значеннями "1" у межах нечіткого фрагмента осі xj та "0" у іншому разі, другий шар складається з Μ нейронів m B 1, 2,…, n з порядковими номерами m=1, 2,…, М, де Μ - загальна кількість інформаційних модулів нейронної мережі, кожний з яких складається з гіпероб'єму, обмеженого по усіх осях xj відповідними значеннями нечітких фрагментів із порядковими номерами 1, 2,…, n, має n входів із ваговими коефіцієнтами "1", до яких увімкнені відповідні виходи нейрона першого шару m XPj, j, нечіткі фрагменти яких утворюють для одного нейрона B 1, 2,…, n у сукупності один m відповідний інформаційний модуль, має вихід, призначений для видачі значення B 1, 2,…, n=1, m якщо на всі його входи подані величини XPj, j=1, і видачі на виході значення B 1, 2,…, n=0 у m іншому випадку, третій шар складається з Μ нейронів F 1, 2,…, n без активаційної функції, кожний з яких має керуючий вхід з ваговим коефіцієнтом "1", на який увімкнений вихід m m відповідного нейрона другого шару B 1, 2,…, n, має нульовий вхід з ваговим коефіцієнтом "w0 ", до якого увімкнена постійна вхідна величина х 0=1, має n координатних входів з ваговими m коефіцієнтами wj , до яких увімкнені відповідні значення змінних xj входів нейронної мережі, і m має вихід, призначений для видачі значення вихідної функції m-го інформаційного модуля F 1, 2,…, n=Υ(x1, x2,…, xj, …, xn) при зміні xj лише у межах об'єму координат інформаційного модуля m та F 1, 2,…, n=0 у іншому випадку, четвертий шар складається з одного нейрона без активаційної функції з Μ входами при рівних "1" вагових коефіцієнтах, до яких увімкнені виходи m нейронів третього шару F 1, 2,…, n, і з виходом, призначеним для видачі підсумку виходів всіх нейронів інформаційних модулів третього шару. Пропонований пристрій ілюструється кресленнями, на яких наведено: Фіг. 1 - Зв'язок основних сигналів нейронної мережі з двома вхідними координатами х 1 та х2; Фіг. 2 - Пропонована схема нечіткої нейронної мережі прямого розповсюдження сигналів при двох вхідних змінних х1 та х2. На Фіг. 1 замість нечіткої множини, кожна з яких має лінгвістичну назву і функцію належності, що монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини, ураховується лише її частка під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності. На Фіг. 1 застосовано позначення: - х1 та х2 - числові нечіткі вхідні змінні об'єкта або процесу, для якого нейронна мережа формує у процесі навчання функціональну залежність виходу Υ від входів х1 та х2; - ΧΡ1,1 та ХР1,2 - сигнал зі значенням "1" вздовж осі х 1 на ділянці власного нечіткого фрагмента та значенням "0" при іншій величині змінної х 1 (на Фіг. 2 цим двом сигналам відповідають два нейрони 1-го шару з аналогічним позначенням, які мають на вході значення х1 та сигнали ΧΡ1,1, ХР1,2 на виході); - ΧΡ2,1 та ХР2,2 - сигнал зі значенням "1" вздовж осі х 2 на ділянці власного нечіткого фрагмента та значенням "0" при іншій величині змінної х 2 (на Фіг. 2 цим двом сигналам відповідають два нейрони 1-го шару з аналогічним позначенням, які мають на вході значення х 2 та сигнали ΧΡ2,1 ХР2,2 на виході); 1 2 3 4 - В 1,1, В 2,1, В 1,2, В 2,2 - сигнал інформаційного модуля (для двомірної системи координат х 1 та х2 інформаційний модуль - це площина, яка обмежена по осях координат відповідними нечіткими фрагментами), який приймає значення "1", лише коли вхідні координати х 1 та х2 входять у m-ий інформаційний модуль та дорівнює "0" у іншому випадку (на Фіг. 2 цим чотирьом сигналам відповідають чотири нейрони 2-го шару з аналогічним позначенням, які мають на 1 2 3 4 вході сигнали XPj, j та сигнали В 1,1, В 2,1, В 1,2, В 2,2 на виході); 1 2 3 4 - F 1,1, F 2,1, F 1,2, F 2,2 - сигнал інформаційного модуля, який приймає значення виходу Υ нечіткої нейронної мережі, лише коли вхідні координати х 1 та х2 входять у m-ий інформаційний модуль, і має значення "0" у іншому разі (на Фіг. 2 цим чотирьом сигналам відповідають чотири 1 2 3 нейрони 3-го шару з аналогічним позначенням, які мають на входах сигнали В 1,1, В 2,1, В 1,2, 4 1 2 3 4 В 2,2, постійну величину х 0=1 та вхідні змінні (х1 та х2) і видають сигнали F 1,1, F 2,1, F 1,2, F 2,2 на 2 UA 97763 U m 5 10 15 20 25 30 35 40 45 50 55 60 m 1 2 3 4 виході, а вагові коефіцієнти w0 та wj призначені для навчання нейронів F 1,1, F 2,1, F 1,2, F 2,2 інформаційного модуля нейронної мережі); - дев'ять чорних точок на Фіг. 1 звуться "опорними точками" і мають визначені експертом через лінгвістичні змінні з рівними "1" функції призначення числові значення вхідних змінних (х 1, х2) та виходу Y. Значення (х1, х2, Y) "опорних точок" використовуються для навчання нейронної мережі. Для уточнення розрахунків при навчанні кількість "опорних точок" може бути збільшена введенням додаткових рівномірно розміщених навчальних точок за інформацією експерта, або використанням даних експлуатації. Для спрощення схеми на Фіг. 2 всі нейрони помічені позначенням їх сигналів виходів. На Фіг. 2 помічено: - цифрами "1" на входах нейронів - числове значення вагових коефіцієнтів для входів нейронів, які не змінюються у процесі навчання нейронної мережі; 1 1 1 2 2 2 3 3 3 4 4 4 - w 0, w 1, w 2, w 0, w 1, w 2, w 0, w 1, w 2, w 0, w 1, w 2 - вагові коефіцієнти для входів нейронів 1 2 3 4 F 1,1, F 2,1, F 1,2, F 2,2, які змінюються у процесі навчання нейронної мережі; - ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2 - нейрони, які мають аналогічні позначення сигналів виходу, не навчаються та не мають вагових коефіцієнтів на входах, оскільки складаються з активаційних функцій. Кожний нейрон контролює власний нечіткий фрагмент у межах зростання відповідної функції належності від "0" до "1" і видає сигнал виходу "1", якщо точка з координатами х 1, х2 знаходиться у межах відповідного нечіткого фрагменту і "0" у іншому разі; 1 2 3 4 - В 1,1, В 2,1, В 1,2, В 2,2 - нейрони 2-го шару, які мають аналогічні позначення сигналів виходу та не навчаються. Кожний нейрон має два входи з ваговими коефіцієнтами "1", до яких увімкнені сигнали виходів нейронів 2-го шару нейронної мережі ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2, 2, контролює власний інформаційний модуль і видає сигнал виходу "1", якщо точка з координатами х1, х2 знаходиться у межах відповідних нечітких фрагментів, які обмежують інформаційний модуль; 1 2 3 4 - F 1,1, F 2,1, F 1,2, F 2,2 - нейрони 3-го шару, які мають аналогічні позначення сигналів виходу 1 1 1 2 2 2 3 та навчаються за допомогою зміни вагових коефіцієнтів входів w 0, w 1, w 2, w 0, w 1, w 2, w 0, 3 3 4 4 4 w 1, w 2, w 0, w 1, w 2. Кожний нейрон контролює власний інформаційний модуль і видає сигнал 1 2 3 4 виходу F 1,1, F 2,1, F 1,2, F 2,2, який приймає значення виходу Υ нечіткої нейронної мережі, лише коли точка з координатами х1 та х2 входить у m-ий інформаційний модуль і має значення "0" у іншому випадку; - Υ - нейрон 4-го шару, який не навчається, має кількість входів М, рівну кількості інформаційних модулів з ваговими коефіцієнтами "1" входів, до яких увімкнені виходи нейронів 1 2 3 4 1 2 3-го шару F 1,1, F 2,1, F 1,2, F 2,2, має сигнал виходу Y, рівний підсумку виходів нейронів F 1,1, F 2,1, 3 4 F 1,2, F 2,2. Дана нейронна мережа відноситься до нейронних мереж прямого розповсюдження вхідного сигналу. Розглянемо алгоритм роботи запропонованого пристрою згідно з Фіг. 1. Вздовж осей х 1 та х2 Фіг. 1 сигнали ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2 набувають значення "1" на довжині нечіткого фрагмента, коли вхідна координата об'єкта х1 або х2 попадає на відповідний нечіткий фрагмент. Довжини нечітких фрагментів помічені на Фіг. 1 відрізками ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2.· Разом із тим відрізки нечітких фрагментів розділяють площину вхідних змінних х 1 та х2 на чотири інформаційних модуля (розділ площини х 1 та х2 наведений пунктирними лініями, поміченими на перехрестях чорними точками). 1 2 3 4 Середини інформаційних модулів помічені позначками сигналів (В 1,1, В 2,1, В 1,2, В 2,2) та 1 2 3 4 (F 1,1, F 2,1, F 1,2, F 2,2). 1 2 3 4 Сигнали (В 1,1, В 2,1, В 1,2, В 2,2) дорівнюють "1", якщо вхідна точка змінних (х 1, х2) попала у простір відповідного інформаційного модуля, та дорівнюють "0" у іншому випадку. Ця логічна функція виконується нейроном з аналогічною позначкою і забороняє або дозволяє отримати 1 2 3 4 вихідні сигнали (F 1,1, F 2,1, F 1,2, F 2,2). 1 2 3 4 Сигнали (F 1,1, F 2,1, F 1,2, F 2,2) приймають значення виходу Υ нечіткої нейронної мережі, лише коли точка з координатами х1 та х2 входить у m-ий інформаційний модуль та мають значення або "0" у іншому випадку. C C Таким чином, якщо координати вхідного об'єкта відображуються точкою С(х 1 , х2 ) згідно з Фіг. 1, то відповідні сигнали нечітких фрагментів ХР1,2 та ХР2,2 набувають значення "1", що 4 призводить до того, сигнал В 2,2=1. Це є дозволом на отримання вихідної функції нейронної 4 мережі F 2,2, тобто тієї частки розв'язку Υ=F(X), яка стосується лише даного інформаційного 1 2 3 4 модуля. Далі потрібно ці частки рішень (F 1,1, F 2,1, F 1,2, F 2,2) об'єднати за допомогою нейронів. Звичайно при розгляді нечітких систем експерт видає лінгвістичні значення вхідних координат та виходів при функції належності, рівній "1", які припадають на чорні точки Фіг. 1. 3 UA 97763 U 5 10 15 20 Але з Фіг. 1 ми бачимо, що для отримання аналітичної формули виходу Υ=F(X) для інформаційного модуля за методом найменших квадратів можна використати довільну кількість 4 довільно розміщених точок. Тому уточнення функції виходу F 2,2 може відбуватись з використанням додаткових рівномірно розміщених точок, визначених експертом, або при використанні даних експлуатації. Запропонована нечітка нейронна мережа виконує розрахунки лише з використанням числових значень. Але однозначний лінгвістичний еквівалент числових значень вхідних змінних х1 та х2 та виходу Υ може бути наданий за відомими лінгвістичними позначеннями нечітких фрагментів з відповідним значенням функції належності. На Фіг. 2 відображена запропонована схема нечіткої нейронної мережі прямого розповсюдження сигналів при двох вхідних змінних х 1 та х2. Нейрони позначені по сигналах на їх виходах. На входи нейронів 1-го шару нейронної мережі ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2, 2 Фіг. 2 надходять вхідні координати х1 та х2, у результаті чого на виходах лише двох із них з'являються сигнали "1", а на інших двох маємо значення виходів "0". 1 2 3 4 Сигнали ΧΡ1,1, ХР1,2, ΧΡ2,1 ХР2,2, 2 надходять на входи нейронів В 1,1, В 2,1, В 1,2, В 2,2, які для двох власних входів виконують логічну булеву функцію AND. Сигнал виходу одного з цих нейронів набуває значення "1", а у інших нейронів вихідний сигнал дорівнює "0". Сигнал "1" 1 2 3 4 одного з нейронів 2-го шару В 1,1, В 2,1, В 1,2, В 2,2 дає дозвіл на увімкнення одного відповідного 1 2 3 4 нейрона 3-го шару F 1,1, F 2,1, F 1,2, F 2,2 без активаційної функції, вихідне значення якого визначається за формулою: n m F1, 2,... n Bm1, 2,... n w m x j , j j0 де x 0 1, а добуток w 0 x 0 дорівнює постійній складовій аналітичного виразу m-го інформаційного модуля. Один нейрон 4-го шару Υ без активаційної функції, з рівними "1" ваговими коефіцієнтами 1 2 3 4 входів, підсумовує вихідні сигнали всіх нейронів 3-го шару F 1,1, F 2,1, F 1,2, F 2,2 за формулою m 25 M m Y FX F1, 2,... n . m 1 30 35 40 45 50 C C Таким чином, якщо координати вхідного об'єкта відображуються точкою С(х1 , х2 ) згідно з Фіг. 1, то відповідні сигнали нечітких фрагментів ХР1,2 та ХР2,2 Фіг. 2 набувають значення "1", що 4 призводить до того, що сигнал В 2,2=1. Це є дозволом на отримання вихідної функції нейронної 4 мережі F 2,2, тобто частки розв'язку Υ=F(X), яка стосується лише даного інформаційного модуля. 1 2 3 4 Ці частки рішень (F 1,1, F 2,1, F 1,2, F 2,2) об'єднуються за допомогою нейрона 4-го шару Y, на виході якого отримують вихідне значення сигналу Υ для всієї нечіткої нейронної мережі. Дана нейронна мережа має лише один шар нейронів для навчання. Тому процес навчання може бути спрощено за рахунок використання лише "дельта-правила" Відроу-Хоффа (WidrowHoff), згідно із яким на початку навчання ваговим коефіцієнтам нейронів надаються малі випадкові значення, наприклад, із діапазону [-0,3; …; +0,3] з випадковим призначенням знаків «+» та «-», а розрахунки вагових коефіцієнтів виконуються за формулою: НОВЕ СТАРЕ НОВЕ wj =w j+η(у1Е-у1)·хj=w j+ηδ·хj, СТАРЕ НОВЕ де δ=(у1Е-у1); wj ; wj - старе та нове значення вагових коефіцієнтів; η=0…1 коефіцієнт навчання (звичайно приймається рівним 0,05….0,25); у1Е, у1 - еталонне та реальне (розраховане) значення виходу. У процесі навчання на вхід нейрона подається одна навчальна еталонна пара (входів та виходу) за іншою, в результаті чого вагові коефіцієнти нейронів коригуються до тих пір, доки для усіх еталонів похибка у розпізнаванні об'єктів не стане меншою деякого прийнятого значення [10; 11]. До даної мережі можна застосувати матричний аналіз інформаційних модулів в однозначній нечіткій системі [8], який не вимагає навчання мережі. Згідно з цим методом для отримання вихідної функції, наприклад, для четвертого модуля у вигляді 4 4 4× 4× F 2,2=А0 +А1 1+А2 2, 4 4 4 де А0 , А1 , А2 - постійні коефіцієнти, потрібно, наприклад, за методом найменших квадратів лише один раз розв'язати матричне 4 4 4 рівняння (це не вважається навчанням) для визначення постійних коефіцієнтів А 0 , А1 , А2 A 4 X 4 T X4 1 4 X4TF2,2 , (1) 4 UA 97763 U 4 4 4 4 F24,2 x1 _ min , x 2 _ min 1 x1 _ min x 2 _ min 4 A 0 4 4 _ min 4 _ T 4 4 F x , x2 1 x1 _ min x 2 _ T 4 4 4 4 4 ; ; A 4 A 1 ; X4 ; F2,2 2,2 1 F2,2 X A 4 4_T 4 4_T 4 _ min F2,2 x1 , x 2 _ min 1 x1 x2 4 A 2 4 4_T 4_T 4_T 4 x2 _ T 1 x1 F2,2 x1 , x 2 4 _ min і x1 - мінімальне значення змінної x 1 у межах нечіткого фрагмента, при якому величина функції належності дорівнює "0"; 4 x1 _ T - максимальне значення змінної x 1 у межах нечіткого фрагмента, при якому величина 5 функції належності дорівнює "1"; 4 x 2 _ min - мінімальне значення змінної x 2 у межах нечіткого фрагмента, при якому величина функції належності дорівнює "0"; 4 x 2 _ T - максимальне значення змінної x 2 у межах нечіткого фрагмента, при якому величина функції належності дорівнює "1"; 10 X 4T - транспонована матриця X4; X 15 20 25 30 35 40 45 1 - зворотна матриця X 4 T X 4 . Використання запропонованої корисної моделі дозволяє розв'язувати складні задачі управління, навчати та перенавчати систему у процесі її роботи при зміні функцій системи шляхом введення у матричне рівняння (1) нових навчальних точок. Вона надає можливість зменшити витрати на обладнання, експлуатацію, налагодження системи за рахунок спрощення схеми нейронної мережі. У запропонованому пристрої не виконується операція дефаззифікації, не використовується база правил, навчанню підлягає лише один шар багатошарової нейронної мережі, з'являється можливість взагалі не використовувати задані експертом функції належності. У сукупності це спрощує нейронну мережу, зменшує вартість обладнання та експлуатації. Джерела інформації: 1. Штовба С.Д. Введение в теорию нечетких множеств и нечеткую логику /С.Д. Штовба [Електроний ресурс]. - Режим доступу: http://matlab.exponenta.ru/fazzylogic/bookl/index.php. 2. Шептунов С.А. Интеллектуальная система управления на базе нечеткой логики //Международный научный интернет журнал "Конструкторско-технологическая информатика" /С.А. Шептунов, И.С. Кабак, Н.В. Суханова. - МГТУ "Станкин", Москва, РФ. [Електроний ресурс]. Режим доступу: http://joumal.ikti.ru/index.php/online-magazine/number-1. 3. Кабак И.С, Суханова Н.В. Доменная нейронная сеть. Патент на полезную модель № 72084 от 03.12.2007. 4. Кабак И.С., Суханова Н.В. Нейронная сеть. Патент на полезную модель № 66 831 опубл. 27.09.2007, Бюл. № 27. 5. Кабак И.С., Суханова Н.В Модульная вычислительная система. Патент на ПМ № 75247 (2008.07.27). 6. Ладанюк А.П., Шумигай Д.Α., Смітюх Я.В. Кроніковський Д.О. Система автоматичного управління температурним режимом похилої дифузійної установки. Патент UA № 86636, МПК G05 13/04. Опубліковано 10.01.2014. 7. Заде Л. Понятие лингвистической переменной и его применение к понятию приближенных решений /Л. Заде. - М.: Мир, 1976. - 165 с. 8. Турти М.В. Теорія однозначних нечітких систем та нейронні мережі: Монографія. Частина 1 /Μ.В. Турти. - Миколаїв: Вид-во Європейський університет, Миколаївська філія, 2007. - 140 с. 9. Турти М.В. Теорія однозначних нечітких систем та нейронні мережі: Монографія. Частина 2 /М.В. Турти. - Миколаїв: Вид-во Європейський університет, Миколаївська філія, 2007. - 114 с. 10. Widrow В., Hoff Μ. Ε. Jr. Adaptive switching circuits // Western Conference Rec, IRE. - 1960. № 4. - P. 94-104. 11. Руденко О.Г. Штучні нейронні мережі /О.Г. Руденко, С.В. Бодянський. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. 4T X4 ФОРМУЛА КОРИСНОЇ МОДЕЛІ 50 Нечітка нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання деякої функціональної залежності Υ(x1, x2, …, xj, …, xn), з нечіткими множинами, розміщеними 5 UA 97763 U 5 10 15 20 25 вздовж осей входу xj та виходу Y, кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюється у межах від "0" до "1" у діапазоні значень нечіткої множини, яка відрізняється тим, що як нечітка множина враховується її частка під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності, перший шар нейронної мережі має на кожний нечіткий фрагмент осі xj один нейрон XPj, j, де j=1, 2,…, n- порядковий номер осі, j=1, 2,…, Aj - порядковий номер нечіткого фрагмента вздовж j-οϊ осі (з позначенням нейронів по їх вихідних сигналах), який складається лише з активаційної функції і має один вхід з увімкненою до нього відповідною змінною xj та один вихід, призначений для видачі величини активаційної функції XPj,j у вигляді прямокутного сигналу зі значеннями "1" у межах нечіткого фрагмента осі xj та "0" у іншому разі, m другий шар складається з Μ нейронів B 1, 2,…, n з порядковими номерами m=1, 2,…, М, де Μ загальна кількість інформаційних модулів нейронної мережі, кожний з яких складається з гіпероб'єму, обмеженого по усіх осях xj відповідними значеннями нечітких фрагментів з порядковими номерами 1, 2,…, n, має n входів з ваговими коефіцієнтами "1", до яких увімкнені відповідні виходи нейрона першого шару XPj,j, нечіткі фрагменти яких утворюють для m одного нейрона B 1, 2,…,n у сукупності один відповідний інформаційний модуль, має вихід, m призначений для видачі значення B 1, 2,…, n=1, якщо на всі його входи подані величини m XPj,j=1, і видачі на виході значення B 1, 2,…, n=0 у іншому випадку, третій шар складається з Μ m нейронів F 1, 2,…, n без активаційної функції, кожний з яких має керуючий вхід з ваговим m коефіцієнтом "1", на який увімкнений вихід відповідного нейрона другого шару B 1, 2,…, n, має m нульовий вхід з ваговим коефіцієнтом "w0 ", до якого увімкнена постійна вхідна величина х0=1, m має n координатних входів з ваговими коефіцієнтами wj , до яких увімкнені відповідні значення змінних xj входів нейронної мережі, і має вихід, призначений для видачі значення вихідної m функції m-го інформаційного модуля F 1, 2,…, n=Υ(x1, x2, …, xj, …, xn) при зміні xj лише у межах m об'єму координат інформаційного модуля та F 1, 2,…, n=0 у іншому випадку, четвертий шар складається з одного нейрона без активаційної функції з Μ входами при рівних "1" вагових m коефіцієнтах, до яких увімкнені виходи нейронів третього шару F 1, 2,…, n, і з виходом, призначеним для видачі підсумку виходів всіх нейронів інформаційних модулів третього шару. UA 97763 U Комп’ютерна верстка Г. Паяльніков Державна служба інтелектуальної власності України, вул. Урицького, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут промислової власності”, вул. Глазунова, 1, м. Київ – 42, 01601 7

ДивитисяДодаткова інформація

МПК / Мітки

Мітки: мережа, нейронна, нечітка

Код посилання

<a href="https://ua.patents.su/9-97763-nechitka-nejjronna-merezha.html" target="_blank" rel="follow" title="База патентів України">Нечітка нейронна мережа</a>

Попередній патент: Залізнична цистерна

Наступний патент: Спосіб одержання оптично активних (r)- та (s)-діетил-1-аміно-3-оксо-1-(трифлуорометил)бутилфосфонатів

Випадковий патент: Газовий пальник