Пристрій багатонаправленої нейромережевої пам`яті

Формула / Реферат

Пристрій багатонаправленої нейромережевої пам'яті, що складається з сенсорного шару нейронів, який відрізняється тим, що в нього введено N модулів на основі дискретних нейронних мереж адаптивної резонансної теорії і проміжний шар нейронів, елементи якого зв'язані парами двонаправлених зважених зв'язків з відповідними їм елементами розпізнавальних шарів N однотипних паралельно працюючих модулів, кожний з яких являє собою дискретну нейронну мережу АРТ-1У, які містять у собі шари інтерфейсних елементів, нейрони яких пов'язані з відповідними їм елементами сенсорних шарів парами бінарних двонаправлених зв'язків, розпізнавальні шари елементів, нейрони яких пов'язані з кожним з елементів у відповідних їм інтерфейсних шарах парами двонаправлених зважених зв'язків з безперервними ваговими коефіцієнтами, вирішуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, і керуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, а також з відповідними керуючими нейронами, які в свою чергу зв'язані з усіма нейронами в проміжному шарі елементів нейронної мережі.

Текст

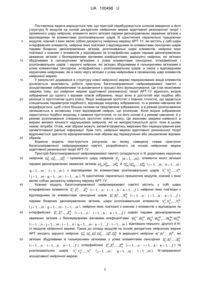

Реферат: UA 100498 U UA 100498 U 5 10 15 20 25 30 35 40 45 50 55 60 Корисна модель належить до обчислювальної техніки, зокрема до області побудови автоматизованих систем керування, а саме до напрямку побудови систем діагностики й керування складними технічними об'єктами. Винахід може бути використаний при побудові системи керування або діагностики такого складного технічного об'єкта як дизель-поїзд з тяговими асинхронними електроприводами. Відомий пристрій для розпізнавання образів, який містить блок зважування, блок впорядкування навчальних сигналів і блок формування цілочисельних ваг, входи якого з'єднані з відповідними виходами блока впорядкування навчальних сигналів, а виходи з'єднані з керуючими входами блока зважування, який відрізняється тим, що в нього введено вхідний блок і блок класифікації, причому входи вхідного блока є інформаційними входами пристрою, а його виходи з'єднані з входами блока впорядкування навчальних сигналів та блока зважування, виходи якого з'єднані з входами блока класифікації, вхід скиду і вхід адреси якого з'єднані з відповідними входами пристрою, виходи результатів блока класифікації з'єднані з другими входами блока формування цілочисельних ваг, його виходи класифікації є відповідними виходами пристрою, а вихід ознаки є виходом сигналу "Кінець" пристрою [1]. Недоліком відомого пристрою розпізнавання образів є обмеження, яке накладається на порядок пред'явлення навчальних сигналів. Відомий пристрій для розпізнавання образів, який містить блок зважування, блок впорядкування навчальних сигналів і блок формування цілочисельних ваг, входи якого з'єднані з відповідними виходами блока впорядкування навчальних сигналів, а виходи з'єднані з керуючими входами блока зважування, який відрізняється тим, що в нього введено вхідний блок і блок класифікації, причому входи вхідного блока є інформаційними входами пристрою, а його виходи з'єднані з входами блока впорядкування навчальних сигналів та блока зважування, виходи якого з'єднані з входами блока класифікації, вхід скиду, перший і другий адресні входи, вхід дозволу та вхід задання порогу якого з'єднані з відповідними входами пристрою, перша група виходів блока класифікації з'єднана з другими входами блока формування цілочисельних ваг, друга група виходів блока класифікації є інформаційними виходами пристрою, перший вихід є його виходом підсумкового сигналу, а другий вихід - виходом сигналу "Кінець" пристрою [2]. При порівнянні з першим аналогом пристрій розпізнавання образів не накладає обмеження на порядок пред'явлення вхідних навчальних сигналів. Однак розглянутий пристрій розпізнавання й класифікації образів накладає обмеження на форму вхідних навчальних сигналів та у нього відсутня можливість донавчатися в процесі свого функціонування. Найбільш близьким до заявленого пристрою є пристрій розпізнавання й класифікації образів, що складається з сенсорного шару нейронів (блока порогових елементів) та шару інтерфейсних елементів, нейрони якого пов'язані з відповідними їм елементами сенсорного шару вхідними бінарними односпрямованими зв'язками, шару розпізнавальних елементів, нейрони якого пов'язані з кожним з елементів у інтерфейсному шарі парами двонаправлених зважених зв'язків з безперервними ваговими коефіцієнтами, вирішального нейрона, який пов'язаний збудливими вхідними зв'язками з усіма елементами сенсорного і інтерфейсного шарів й гальмівними зв'язками з усіма елементами розпізнавального і загального розпізнавального шарів нейронів, двох керуючих нейронів, перший з яких пов'язаний вхідними збудливими зв'язками з усіма елементами сенсорного шару нейронів, вихідними збудливими зв'язками з усіма елементами інтерфейсного шару й гальмівними вхідними зв'язками з усіма елементами розпізнавального і загального розпізнавального шарів нейронів, другий з яких пов'язаний вхідними збудливими зв'язками з усіма елементами сенсорного шару й збудливими вихідними зв'язками з усіма елементами розпізнавального й загального розпізнавального шарів нейронів, а також загального розпізнавального шару нейронів, елементи якого пов'язані двонаправленими зваженими зв'язками з відповідними елементами інтерфейсного шару нейронів [3]. При порівнянні з відомими аналогами пристрій-аналог не накладає обмежень на порядок пред'явлення і форму навчальних зображень (сигналів) та може донавчатися в процесі свого функціонування без втрат запам'ятованої раніше інформації. Однак розглянутий пристрій розпізнавання й класифікації образів не в змозі здійснити зберігання та відновлення зі своєї пам'яті множини асоціативних зображень. Таким чином, недоліком найближчого аналога є те, що він не в змозі здійснити зберігання та відновлення зі своєї пам'яті множини асоціативних зображень. В основу корисної моделі поставлено задачу розробки пристрою багатонаправленої нейромережевої пам'яті, що має можливість донавчання в процесі свого функціонування та зберігати й відновлювати зі своєї пам'яті множини асоціативних зображень. 1 UA 100498 U 5 10 15 20 25 30 35 Поставлена задача вирішується тим, що пристрій перебудовується шляхом введення в його структуру N модулів на основі дискретних нейронних мереж адаптивної резонансної теорії і проміжного шару нейронів, елементи якого зв'язані парами двонаправлених зважених зв'язків з відповідними їм елементами розпізнавальних шарів N однотипних паралельно працюючих модулів, кожний з яких являє собою дискретну нейронну мережу АРТ-1У, які містять у собі шари інтерфейсних елементів, нейрони яких пов'язані з відповідними їм елементами сенсорних шарів парами бінарних двонаправлених зв'язків, розпізнавальні шари елементів, нейрони яких пов'язані з кожним з елементів у відповідних їм інтерфейсних шарах парами двонаправлених зважених зв'язків з безперервними ваговими коефіцієнтами, вирішуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, і керуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, а також з відповідними керуючими нейронами, які в свою чергу зв'язані з усіма нейронами в проміжному шарі елементів нейронної мережі. У результаті додавання в структуру нової нейронної мережі перерахованих вище елементів досягається можливість роботи пристрою багатонаправленої нейромережевої пам'яті з асоціативними зображеннями та донавчання в процесі його функціонування. Це стає можливим завдяки тому, що нейронні мережі адаптивної резонансної теорії АРТ-1У відносять вхідне зображення до одного з відомих класів зображень, якщо воно в достатній мірі подібно або резонує із прототипом цього класу. Якщо знайдений прототип з певною точністю, що задається спеціальним параметром подібності, відповідає вхідному зображенню, то в режимі навчання він модифікується, щоб стати більше схожим на пред'явлене зображення, а в режимі розпізнавання залишається в активному стані відповідний нейрон, що розпізнає. Коли вхідне зображення недостатньо подібно жодному з наявних прототипів, то на його основі й у режимі навчання, й у режимі розпізнавання створюється прототип нового класу. Це можливо завдяки наявності в мережі великої кількості надлишкових нейронів, які не використовуються доти, поки в цьому немає потреби. Отже, нові образи можуть запам'ятовуватись мережею без перекручування вже запам'ятованої раніше інформації. Крім того, нейронні мережі адаптивної резонансної теорії відрізняються здатністю відокремлювати нові образи від перекручених або зашумлених відомих образів. Корисна модель ілюструється рисунком, на якому наведена схема пристрою багатонаправленої нейромережевої пам'яті, розробленого на основі нейронних мереж адаптивної резонансної теорії АРТ-1У. Пристрій багатонаправленої нейромережевої пам'яті складається із N додаткових керуючих 2 нейронів G1 , G3 ,...,GN і проміжного шару нейронів Pd d 1 m , елементи якого зв'язані ,..., 3 3 парами двонаправлених зважених зв'язків H1 ,H2 ,...,HN й Q1 , Q2 ,...,QN ( j 1 m ; d 1 m ; ,..., ,..., jd gd td dj dg dt 2 ,..., g 1 m ; t 1 m ), з відповідними їм елементами розпізнавальних шарів Yj1, Yg ,...,YtN ,..., 40 ( j 1 m ; g 1 m ; t 1,...,m ), N однотипних паралельно працюючих модулів, кожний з яких ,..., ,..., являє собою дискретну нейронну мережу АРТ-1У. Кожний модуль багатонаправленої нейромережевої пам'яті містить у собі шари інтерфейсних елементів Z1, Zl2 ,...,ZN ( i 1 n ; l 1 k ; e 1,...,ƒ ), нейрони яких пов'язані з ,..., ,..., i e відповідними їм елементами сенсорних шарів S1, Sl2 ,...,SN ( i 1 n ; l 1 k ; e 1,...,ƒ ), ,..., ,..., i e парами бінарних двонаправлених зв'язків, шари розпізнавальних елементів 2 Yj1, Yg ,...,YtN ( j 1 m ; g 1 m ; t 1,...,m ), нейрони яких пов'язані з кожним з елементів у відповідних їм ,..., ,..., 45 інтерфейсних Z1, Zl2 ,...,ZN ( i 1,...,n ; l 1,...,k ; e 1,...,ƒ ) шарах парами двонаправлених i e 11 21 12 22 1N 2 зважених зв'язків з безперервними ваговими коефіцієнтами Wij , Wji , Wlg , Wgl ,...,Wet , WteN ( i 1 n ; j 1 m ; l 1 k ; g 1 m ; e 1,...,ƒ ; t 1,...,m ), відповідно першого, другого й N,..., ,..., ,..., ,..., го модулів нейронної мережі. Також до складу модулів на основі дискретних нейронних мереж 2 N APT входять керуючі нейрони G1, G1 , G1 , G2 ,...,G1 , GN й вирішуючі нейрони R1,R2 ,...,RN , які 1 2 2 2 50 зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних S1, Sl2 ,...,SN i e ( i 1 n ; l 1 k ; e 1,...,ƒ ), інтерфейсних Z1, Zl2 ,...,ZN ( i 1 n ; l 1 k ; e 1,...,ƒ ) та ,..., ,..., ,..., ,..., i e 2 Yj1, Yg ,...,Yt3 асоціативної нейронної мережі. розпізнавальних шарів ( j 1 m; ,..., 2 g 1 m; ,..., t 1 m ), ,..., N-направленої UA 100498 U 5 10 15 20 25 Y-нейрони використовуються в режимі навчання та в режимі розпізнавання, для запам'ятовування нової інформації. Перша стадія навчання мережі АРТ-1У може виконуватися так само, як і в звичайних мережах АРТ-1. Вчитель на цій стадії тільки фіксує номери нейронів, які розпізнають сигнали, що належать до кожного із заданого числа N запам'ятованих образів. На другій стадії навчання вчитель на основі множин ваг зв'язків між Y- і Z-шарами нейронів, що належать до кожного із заданих образів, формує матриці ваг зв'язків між X- і Z-шарами елементів. Однак такий підхід може вимагати надмірного збільшення кількості елементів в Yшарі, оскільки необхідно зберігати інформацію про всі вхідні зображення всіх класів. Тому були розроблені алгоритми послідовного навчання мережі заданому числу образів і послідовному формуванню ваг зв'язків між X- і Z-шарами нейронів. Х-нейрони функціонують лише в режимі розпізнавання, при цьому вони виконують тільки розпізнавання, а нову інформацію засвоює шар Y-нейронів. Нова інформація передається в Хшар за допомогою вчителя в спеціальних режимах донавчання Х-шару нейронів. Пристрій багатонаправленої нейромережевої пам'яті функціонує відповідно до двох алгоритмів: навчання й розпізнавання. В алгоритмах прийняті наступні позначення: m - максимальне число асоціативних зображень; n - число бінарних компонентів у вхідному векторі першого модуля; k - число бінарних компонентів у вхідному векторі другого модуля; ƒ - число бінарних компонентів у вхідному векторі третього модуля; L - константа, що перевершує одиницю, що рекомендується значення: L = 2; р1, р2, ..., pN - параметри подібності між вхідним вектором і вектором, що зберігається у вагах зв'язків нейрона, що переміг, відповідно першого, другого й N-ого модуля мережі; діапазон припустимих значень параметрів: 0 < р1, р2, ..., pN < 1; q - число груп з N асоціативних зображень, що запам'ятовуються; 11 12 1N Wij , Wlj ,...,Wet ( i 1,...,n ; j 1 m ; l 1,...,k ; e 1,...,ƒ ; t 1,...,m ) - ваги зв'язків від ,..., елементів інтерфейсного шару до елементів розпізнавального шару, відповідно першого, другого й N-oгo модуля; діапазон припустимих початкових значень: 1 1 1 11 12 1N ; початкове значення, що 0 Wij , 0 Wlj ,...,0 Wet L 1 n L 1 k L 1 ƒ 30 11 рекомендується, при навчанні: Wij 1 1 1 ; 12 1N , Wlj ,...,Wet 1 n 1 k 1 ƒ 21 22 2 Wji , Wjl ,..., WteN ( j 1 m ; i 1 n ; l 1 k ; t 1,...,m ; e 1,...,ƒ ) - ваги зв'язків від ,..., ,..., ,..., елементів шару, що розпізнає, до елементів інтерфейсного шару відповідно першого, другого й третього модуля; початкове значення, що рекомендується, при навчанні: 21 22 2 Wji Wjl ... WteN 1 ( j 1 m ; i 1 n ; l 1 k ; t 1,...,m ; e 1,...,ƒ ); ,..., ,..., ,..., 35 ,..., ,..., ,..., Uвих.Y1 , Uвих.Y 2 ,...,Uвих.YN ( j 1 m ; g 1 m ; t 1 m ) - вихідні сигнали розпізнавальних j g t елементів, відповідно першого, другого й N-oгo модулів нейронної мережі; U ,...,n ; l 1 k ; e 1,...,ƒ ) - вихідні сигнали елементів S-шару ,..., N (i 1 1, U 2 й U вих.Si вих.Se вих.Sl відповідно першого, другого й N-ого модулів нейронної мережі; Uвх.Z1 , Uвх.Z2 , й Uвх.ZN ( i 1,...,n ; l 1,...,k ; e 1,...,ƒ ) - вхідні сигнали елементів i 40 e l інтерфейсного шару відповідно першого, другого й N-oгo модулів нейронної мережі; Uвих.Z1 , Uвих.Z2 й Uвих.ZN ( i 1,...,n ; l 1,...,k ; e 1,...,ƒ ) - вихідні сигнали елементів i e l інтерфейсного шару відповідно першого, другого й N-oгo модулів нейронної мережі; 2 3 S1, S1 , S1 , S1 , S2 , S3 ,..., S1 , S2 , S3 - N груп асоціативних зображень, які запам'ятовуються 1 2 2 2 q q q модулями нейронної мережі; 45 2 2 2 S1 S11,...,S1 , Sr Sr1,...,Srk ,...,SN SN ,...,SN , , r 1,...,q бінарні вхідні вектора r-ї групи r r rn r r1 rk асоціативних зображень відповідно для першого, другого й N-ого модулів нейронної мережі; X - норма вектора X; ,..., Pt t 1 m - нейрони проміжного шару, які зв'язують два модулі асоціативної нейронної мережі; 3 UA 100498 U H1 ,H2 ,...,HN ( j 1 m ; d 1 m ; g 1 m ; t 1,...,m ) - ваги зв'язку від елементів ,..., ,..., ,..., jd gd td розпізнавального шару, до елементів проміжного шару відповідно першого, другого й N-ого модулів нейронної мережі; Q1 , Q2 ,...,QN ( d 1 m ; j 1 m ; g 1 m ; t 1,...,m ) ваги зв'язку від елементів ,..., ,..., ,..., dj dg dt 5 10 проміжного шару до елементів розпізнавального шару, відповідно першого, другого й N-oгo модулів нейронної мережі. Алгоритм навчання пристрою багатонаправленої нейромережевої пам'яті припускає виконання наступних кроків: Крок 1. Ініціюються параметри L, р1, р2, ..., pN і ваги зв'язків 11 12 1N 21 22 2 Wij , Wlj ,...,Wet , Wji , Wjl ,..., WteN ( i 1,...,n ; j 1,...,m ; l 1,...,k ; e 1,...,ƒ ; t 1,...,m ). Крок 2. Задаються нульові вихідні сигнали всіх розпізнавальних елементів, N модулів нейронної мережі: ,..., Uвих.Y1 0 ; Uвих. Y 2 0 ;... Uвих.YN 0 ; j 1 m . j 15 S1 r j j Крок S11,...,S1 r rn 3. 2 , Sr Для 2 2 Sr1,...,Srk ,...,SN r Крок 4. Вхідними векторами кожної SN ,...,SN , , r1 rk 1 2 Sr , Sr ,...,SN r групи вхідних зображень r 1 q виконуються кроки 4-13. ,..., визначаються вихідні сигнали елементів S1, Sl2 ,...,SN вхідних шарів N модулів: i e 2 Uвих.S1 S1 ; Uвих.S2 Srl ;...Uвих.SN SN , r 1,...,q ; ri re ri 20 rl re ,..., i 1 n; l 1 k ; e 1 ƒ . ,..., ,..., 5. Обчислюються норми векторів вихідних сигналів нейронів вхідного шару трьох модулів: n k Uвих.S1 Uвих.S1 ; Uвих.S2 Uвих.S2 ; i i1 Uвих.SN 25 l l1 …………………………. ƒ Uвих.SN . e e 1 Крок 6. Формуються вхідні й вихідні сигнали елементів інтерфейсних шарів першого, другого й N-ого модулів нейронної мережі: Uвх.Z1 Uвих.S1 ; Uвх.Z2 Uвих.S2 ,...Uвх.ZN Uвих.SN ; i i l l e e ,..., i 1 n; l 1 k ; e 1 ƒ . ,..., ,..., Uвих.Z1 Uвх.Z1 ; Uвих.Z2 Uвх.Z2 ,...Uвих.ZN Uвх.ZN ; i 30 i l l e e ,..., i 1 n; l 1 k ; e 1 ƒ . ,..., ,..., Крок 7. Для кожного незагальмованого розпізнавального Y-нейрона першого, другого й Nого модулів нейронної мережі, розраховуються його вихідні сигнали: n 11 ,..., Uвих. Y1 Wij Uвих.Z1 , якщо Uвих.Y1 1 , j 1 m ; j i1 k i j 12 Uвих. Y 2 Wlj Uвих.Z2 , якщо Uвих.Y 2 1 , j 1,...,m ; j j1 l j …………………………………………………… 35 Uвих. YN j 40 ƒ 1 WejNUвих.ZN , якщо Uвих.YjN 1, j 1,...,m . e e 1 Крок 8. Поки не знайдені нейрони-переможці всіх модулів, вагові вектори яких відповідно до 2 заданих значень параметрів подібності р1, р2,…, pN відповідають вхідним векторам S1, Sr ,...,SN , r r виконуються кроки 9-12 (для N, N-1, N-2, ... або одного з модулів). 1 2 N Крок 9. В Y-шарах N модулів визначаються нейрони YJ1, YJ2 ,...,YJN , що задовольняють умові: , j 1 m. ,..., U 1 U 1, U 2 U 2 ,..., U N U N вих. YJ1 вих. Yj вих. YJ 2 вих. Yj вих. YJN вих. Yj Якщо таких елементів декілька, то вибирається елемент з найменшим індексом. Якщо Uвих. Y1 1 або (й) Uвих.Y 2 1 , ... , або (й) Uвих.YN 1, то всі елементи одного з модулів J1 J2 JN 4 UA 100498 U (обох модулів, всіх N модулів) загальмовані й одне (обидва, всі) вхідні зображення не можуть бути запам'ятовані. Крок 10. Розраховуються вихідні сигнали елементів інтерфейсного шару Z1 i 1,...,n , i Zl2 l 1,...,k , ..., й ZN e 1,...,ƒ відповідно першого, другого й N-ого модулів нейронної мережі: e 21 Uвих.Z1 Uвих.S1 WJ1,i , i 1,...,n ; 5 i i 22 Uвих.Z2 Uвих.S2 WJ2,i , l 1,...,k ; l l ……………………………….. 2N U ,...,ƒ . N U N WJN,i , e 1 вих.Ze 10 вих.Se Крок 11. В усіх N модулях обчислюються норми векторів вихідних сигналів нейронів інтерфейсного шару: n Uвих.Z1 Uвих.Z1 ; i i1 k Uвих.Z2 Uвих.Z2 ; l l1 ……………………. Uвих.ZN 15 e 1 Крок 12. Перевіряється по параметрах подібності р1, р2, ..., рN правильність вибору нейронів1 2 N переможців YJ1, YJ2 ,...,YJN відповідно першого, другого й N-ого модулів нейронної мережі. Якщо p 20 ƒ Uвих.ZN . e Uвих.Z1 Uвих.S1 p1 , то умова не виконується, елемент 1 YJ1 загальмовується: Uвих. Y1 1 ; J1 здійснюється перехід до кроку 8 алгоритму. Якщо, наприклад для першого з модулів р ≥ р1, то 1 умова, що підтверджує правильність вибору нейрона-переможця YJ1 першого модуля виконується й здійснюється перехід до наступного кроку алгоритму. При цьому нейронупереможцю присвоюється одиничне значення вихідного сигналу U 1 1 , а всі інші нейрони, вих. YJ1 розпізнавального шару першого модуля, переводяться в неактивний стан: U ,..., 0, j 1 m, вих. Y1 j j J1 . Аналогічним чином проводиться перевірка правильного вибору нейрона-переможця 2 N YJ2 ,...,YJN , другого та N-oгo модуля нейронної мережі. 25 1 2 N Крок 13. Адаптуються ваги зв'язків елементів YJ1, YJ2 ,...,YJN : 11 WiJ LUвих.Z1 i L 1 Uвих.Z1 12 ; WlJ i LUвих.Z2 1N ;... WeJ l L 1 Uвих.Z2 l LUвих.ZN e L 1 Uвих.ZN , e ,..., i 1 n; l 1 k ; e 1 ƒ ; ,..., ,..., 21 22 2N WJi Uвих.Z1 ; WJl Uвих.Z2 ;...WJe Uвих.ZN , i 30 l e i 1 n ; l 1 k ; e 1,...,ƒ . ,..., ,..., Крок 14. Перевіряється умова закінчення навчання всіх модулів мережі, якщо вони не виконуються, то триває навчання одного, двох або всіх модулів мережі, у іншому випадку здійснюється перехід на наступний крок алгоритму з метою визначення ваг зв'язків нейронів Ршару. 2 Крок 15. Для кожної групи вхідних зображень S1, Sr ,...,SN , r 1 q виконуються кроки 16,..., r r 17. 2 Крок 16. Вхідними зображеннями S1, Sr ,...,SN , що подаються відповідно на входи першого, r r другого й третього модулів нейронної мережі, визначаються нейрони-переможці 1 2 N YJ1r , YJ2r ,...,YJNr , відповідно першого, другого й N-oгo модулів мережі. 35 40 1 2 N Крок 17. Визначаються ваги зв'язків між нейронами-переможцями YJ1r , YJ2r ,...,YJNr та елементами Р-шару: 5 UA 100498 U H11r , J1r Q11r , J1r 1 ; H11r , j Q11r , j 0 , j 1 m , j J1r . ,..., J J J J ,..., H21r , J2r Q22r , J1r 1 ; H21r , k Q22r , j 0 , k , j 1 m , k J2r , j J1r . J J J J ………………………………………………………………………………. ,..., HN1r , J3r QN , J1r 1; HN1r , k QN , j 0 , k , j 1 m , k JNr , j J1r . J JNr J JNr 5 10 Крок 18. Кінець. Розроблений пристрій в процесі розпізнавання й класифікації образів може функціонувати в двох режимах: розпізнавання образів з вчителем та алгоритм розпізнавання без вчителя. Алгоритм розпізнавання образів без вчителя при визначенні асоціативних зображень передбачає виконання наступних кроків: 11 12 1N Крок 1. Ініціюються параметри L, р1, р2, ..., pN та ваги зв'язків Wij ,, Wlj ,..., Wet , 21 22 2 Wji , Wjl ,...,WteN ( i 1 n ; j 1 m ; l 1 k ; e 1,...,ƒ ; t 1,...,m ), H1 ,H2 ,...,HN ( j 1 m ; ,..., ,..., ,..., ,..., jd gd td ,..., ,..., d 1 m ; g 1 m ; t 1 m ), Q1 , Q2 ,...,QN ( d 1 m ; j 1 m ; g 1 m ; t 1 m ). ,..., ,..., ,..., ,..., ,..., dj dg dt Крок 2. На вхід одного з модулів мережі подається вхідне зображення. Допустимо, що вхідне зображення S1 подається на вхід першого модуля мережі. Тоді аналогічним чином, як і в r 15 1 алгоритмі навчання, визначається нейрон-переможець YJ1r першого модуля нейронної мережі. 2 N Крок 3. Визначаються нейрони-переможці YJ2r ,...,YJNr другого й N-oгo модулів нейронної мережі. Вони виділяються не у результаті змагання між розпізнавальними елементами другого й N-oгo модулів, а одиничним сигналом елемента PJ1r , який у свою чергу, в активний стан 20 1 переводиться нейроном-переможцем YJ1r : , j 1 m , j J2r ; U 1, U ,..., 2 2 0 вих. YJ 2 r вих. Yj …………………………………………. Uвих.YN 1 , Uвих.YN 0 , j 1,...,m , j JNr . JNr j 2 N При цьому вихідному сигналу нейронів-переможців YJ2r ,...,YJNr відповідно другого та N-oгo модуля штучної нейронної мережі присвоюється одиничне значення U 1,..., U 1, 2 N вих. YJ 2 r 25 вих. YJNr а всі інші нейрони переводяться в неактивний стан: U ,..., 0 , j 1 m , j J2 , ..., Uвих.YN 0 , вих. Y 2 j j j 1 m , j JNr . ,..., Крок 4. Розраховуються вихідні сигнали елементів інтерфейсного 2 N Zl l 1,...,k ,..., Ze e 1 ƒ відповідно другого та N-oгo модулів нейронної мережі: ,..., шару 2 Uвих.Z2 WJ2r ,l , l 1,...,k ; l ………………………….. 2N U ,...,ƒ . N WJNr,e , e 1 30 вих.Zl Крок Sl2 5. Формуються l 1,...,k вхідні й вихідні сигнали елементів вхідного відповідно другого та N-oгo модуля нейронної мережі: e 1,...,ƒ ,...,k , U ,...,k ; 2 , l 1 2 U 2 , l 1 Uвх.S2 Uвих.Z l вих.Sl l e 35 шару ,..., SN e e вх.Sl ……………………………………………………….. Uвх.SN Uвих.ZN , e 1,...,ƒ , Uвих.SN Uвх.SN , e 1,...,ƒ . e e 2 2 2 3 3 3 Отримані на виході другого й N-oгo модуля зображення Sr Sr1,...,Srk ,...,Sr Sr1,...,Srk 40 є асоціацією зображенню S1 S11,...,S1 r 1 q , що подається на елементи вхідного шару ,..., r r rn першого модуля нейронної мережі. Крок 6. Кінець. Алгоритм розпізнавання й класифікації образів з вчителем передбачає виконання кроків, аналогічно до алгоритму розпізнавання образів без вчителя, але відрізняється тим, що в ньому функціонують ще і Х-нейрони, які виконують тільки розпізнавання, нова інформація передається в Х-шар за допомогою вчителя в спеціальних режимах донавчання Х-шару нейронів. 6 UA 100498 U 5 Таким чином, розроблений пристрій багатонаправленої нейромережевої пам'яті має можливістю донавчання в процесі свого функціонування та зберігати й відновлювати зі своєї пам'яті множини асоціативних зображень. Джерела інформації: 1. Патент України на корисну модель № 38497, кл. G06K 9/00, 2006. 2. Патент України на винахід № 92682, кл. G06K 9/00, 2009. 3. Патент України на корисну модель № 68375, кл. G06K 9/00, 2012. ФОРМУЛА КОРИСНОЇ МОДЕЛІ 10 15 20 25 Пристрій багатонаправленої нейромережевої пам'яті, що складається з сенсорного шару нейронів, який відрізняється тим, що в нього введено N модулів на основі дискретних нейронних мереж адаптивної резонансної теорії і проміжний шар нейронів, елементи якого зв'язані парами двонаправлених зважених зв'язків з відповідними їм елементами розпізнавальних шарів N однотипних паралельно працюючих модулів, кожний з яких являє собою дискретну нейронну мережу АРТ-1У, які містять у собі шари інтерфейсних елементів, нейрони яких пов'язані з відповідними їм елементами сенсорних шарів парами бінарних двонаправлених зв'язків, розпізнавальні шари елементів, нейрони яких пов'язані з кожним з елементів у відповідних їм інтерфейсних шарах парами двонаправлених зважених зв'язків з безперервними ваговими коефіцієнтами, вирішуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, і керуючі нейрони, які зв'язані збудливими й гальмуючими зв'язками з усіма елементами сенсорних, інтерфейсних і розпізнавальних шарів, а також з відповідними керуючими нейронами, які в свою чергу зв'язані з усіма нейронами в проміжному шарі елементів нейронної мережі. 7 UA 100498 U Комп’ютерна верстка А. Крулевський Державна служба інтелектуальної власності України, вул. Василя Липківського, 45, м. Київ, МСП, 03680, Україна ДП “Український інститут інтелектуальної власності”, вул. Глазунова, 1, м. Київ – 42, 01601 8

ДивитисяДодаткова інформація

Автори англійськоюZakovorotnyy Oleksandr Yuriiovych

Автори російськоюЗаковоротный Александр Юрьевич

МПК / Мітки

МПК: G06F 15/18, G06K 9/00

Мітки: багатонаправленої, пристрій, нейромережевої, пам'яті

Код посилання

<a href="https://ua.patents.su/10-100498-pristrijj-bagatonapravleno-nejjromerezhevo-pamyati.html" target="_blank" rel="follow" title="База патентів України">Пристрій багатонаправленої нейромережевої пам`яті</a>

Попередній патент: Спосіб лікування хворих на оніхомікоз при ураженні більш трьох нігтьових пластинок або ураженні кожної нігтьової пластинки більш ніж 50%

Наступний патент: Установка швидкісного нагрівання вугілля газоподібним теплоносієм

Випадковий патент: Композиція "енергетичний мікс" для функціональних продуктів спортивного харчування