Нейронна мережа

Номер патенту: 115590

Опубліковано: 25.04.2017

Автори: Кутковецький Валентин Якович, Турти Марина Валентинівна

Формула / Реферат

1. Нейронна мережа з прямим розповсюдженням сигналів, що призначена для моделювання на основі теорії однозначних нечітких систем функціональної залежності ![]() , де

, де ![]() - вхідний вектор,

- вхідний вектор, ![]()

![]() - порядковий номер змінної

- порядковий номер змінної ![]() вхідного вектора

вхідного вектора ![]() , яка має нечіткі множини, розміщені вздовж осей змінних

, яка має нечіткі множини, розміщені вздовж осей змінних ![]() та виходу

та виходу ![]() , кожна з нечітких множин має лінгвістичну назву її терму і функцію належності, яка монотонно змінюється у межах "0…1" у діапазоні значень нечіткої множини з урахуванням замість всієї нечіткої множини лише її частки під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності у напрямку збільшення числових значень

, кожна з нечітких множин має лінгвістичну назву її терму і функцію належності, яка монотонно змінюється у межах "0…1" у діапазоні значень нечіткої множини з урахуванням замість всієї нечіткої множини лише її частки під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності у напрямку збільшення числових значень ![]() та виходу

та виходу ![]() , з 1-м шаром, призначеним для нормалізації та розмноження змінних вхідного вектора

, з 1-м шаром, призначеним для нормалізації та розмноження змінних вхідного вектора ![]() ,

, ![]()

![]() , який складається з

, який складається з ![]() нейронів, кожний з яких має один вхід з ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора

нейронів, кожний з яких має один вхід з ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора ![]() , яка відрізняється тим, що кожний нейрон 1-го шару має два виходи, перший з яких з'єднаний з першим входом відповідного нейрона 2-го шару, а другий вихід з'єднаний з відповідним входом, який належить до першої групи входів нейрона 3-го шару, 2-й шар складається з п нейронів з порядковими номерами

, яка відрізняється тим, що кожний нейрон 1-го шару має два виходи, перший з яких з'єднаний з першим входом відповідного нейрона 2-го шару, а другий вихід з'єднаний з відповідним входом, який належить до першої групи входів нейрона 3-го шару, 2-й шар складається з п нейронів з порядковими номерами ![]()

![]() , кожний з яких призначений для виведення порядкового номеру

, кожний з яких призначений для виведення порядкового номеру ![]() відрізку, у якому знаходиться відповідна координата

відрізку, у якому знаходиться відповідна координата ![]() вхідного вектора

вхідного вектора ![]() , і має три входи з ваговим коефіцієнтом 1, з яких перший вхід має увімкнений до нього відповідний вихід

, і має три входи з ваговим коефіцієнтом 1, з яких перший вхід має увімкнений до нього відповідний вихід ![]() 1-го шару нейронів, другий вхід має увімкнене до нього відповідне найменше значення змінної

1-го шару нейронів, другий вхід має увімкнене до нього відповідне найменше значення змінної ![]() , з якого починається розділ на рівні частки

, з якого починається розділ на рівні частки ![]() кожної осі

кожної осі ![]() , третій вхід має увімкнене до нього відповідне значення довжини відрізку

, третій вхід має увімкнене до нього відповідне значення довжини відрізку ![]() , на які поділяються відповідні осі

, на які поділяються відповідні осі ![]() , та вихід, призначений для виведення значення порядкового номера

, та вихід, призначений для виведення значення порядкового номера ![]() відрізку

відрізку ![]() , у якому знаходиться координата кінця вхідного вектора

, у якому знаходиться координата кінця вхідного вектора ![]() по осі

по осі ![]() і який дорівнює одному з порядкових номерів

і який дорівнює одному з порядкових номерів ![]() розміщених відрізків

розміщених відрізків ![]() вздовж осі

вздовж осі ![]() у бік зростання значень осі

у бік зростання значень осі ![]() , за виразом

, за виразом

![]() ,

,

де ![]() - функція усічення числа реального типу

- функція усічення числа реального типу ![]() до цілочислового значення у бік зменшення

до цілочислового значення у бік зменшення ![]() шляхом вилучення його дробової частини;

шляхом вилучення його дробової частини; ![]() - загальна кількість відрізків

- загальна кількість відрізків ![]() по осі

по осі ![]() , причому вектор порядкових номерів відрізків

, причому вектор порядкових номерів відрізків ![]() , як сукупний вихід 2-го шару для всіх осей

, як сукупний вихід 2-го шару для всіх осей ![]() , є адресою, що визначає інформаційний модуль (ділянку простору змінних

, є адресою, що визначає інформаційний модуль (ділянку простору змінних ![]() ), у якому знаходиться кінець вхідного вектора

), у якому знаходиться кінець вхідного вектора ![]() і який обмежений відрізками з порядковими номерами

і який обмежений відрізками з порядковими номерами ![]() , 3-й шар складається з одного нейрона, який має першу групу n входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід

, 3-й шар складається з одного нейрона, який має першу групу n входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід ![]() з 1-го шару нейронів, має блок пам'яті, який складається з векторів (із загальною кількістю таких векторів

з 1-го шару нейронів, має блок пам'яті, який складається з векторів (із загальною кількістю таких векторів ![]() ), елементами яких є постійні коефіцієнти

), елементами яких є постійні коефіцієнти ![]() вихідної функції

вихідної функції ![]() В-го інформаційного модуля, і які мають вигляд

В-го інформаційного модуля, і які мають вигляд

![]() ,

,

де ![]() - адреса інформаційного модуля, яка в просторі змінних

- адреса інформаційного модуля, яка в просторі змінних ![]() є незмінною для всіх постійних коефіцієнтів

є незмінною для всіх постійних коефіцієнтів ![]() вихідної функції

вихідної функції ![]() інформаційного модуля з адресою

інформаційного модуля з адресою ![]() і визначена через порядкові номери відрізків змінних

і визначена через порядкові номери відрізків змінних ![]() , у які попала відповідна змінна вхідного вектора

, у які попала відповідна змінна вхідного вектора ![]() ;

; ![]() - порядкові номери змінних

- порядкові номери змінних ![]() вхідного вектора

вхідного вектора ![]() ;

; ![]() - загальна кількість змінних вхідного вектора

- загальна кількість змінних вхідного вектора ![]() ;

; ![]() - порядкові номери постійних коефіцієнтів

- порядкові номери постійних коефіцієнтів ![]() вихідної функції

вихідної функції

![]() інформаційного модуля з адресою В;

інформаційного модуля з адресою В; ![]() - штучно введена змінна;

- штучно введена змінна; ![]() - змінні вхідного вектора

- змінні вхідного вектора ![]() ;

; ![]() - порядковий номер відрізків

- порядковий номер відрізків ![]() на осі

на осі ![]() - порядковий номер відрізків

- порядковий номер відрізків ![]() на осі

на осі ![]() - порядковий номер відрізків

- порядковий номер відрізків ![]() на осі

на осі ![]() ;

; ![]() - загальна кількість відрізків

- загальна кількість відрізків ![]() на відповідних осях

на відповідних осях ![]() , блок пам'яті має

, блок пам'яті має ![]() входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи

входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи ![]() 2-го шару, та має

2-го шару, та має ![]() виходів, кожний з яких призначений для виведення одного відповідного елемента вектора

виходів, кожний з яких призначений для виведення одного відповідного елемента вектора ![]() і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості

і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості ![]() нейрону 3-го шару, який призначений для отримання на виході функції

нейрону 3-го шару, який призначений для отримання на виході функції ![]() відповідного

відповідного ![]() -го інформаційного модуля, що є виходом всієї нейронної мережі..

-го інформаційного модуля, що є виходом всієї нейронної мережі..

2. Нейронна мережа за п. 1, що призначена для аналізу у випадку, коли відрізки ![]() вздовж осі

вздовж осі ![]() є неоднаковими, яка відрізняється тим, що у 2-му шарі нейронів кожний j-й нейрон

є неоднаковими, яка відрізняється тим, що у 2-му шарі нейронів кожний j-й нейрон ![]() , має один вхід з ваговим коефіцієнтом 1, до якого увімкнений відповідний вихід

, має один вхід з ваговим коефіцієнтом 1, до якого увімкнений відповідний вихід ![]() нейрону 1-го шару, має блок пам'яті у вигляді вектора

нейрону 1-го шару, має блок пам'яті у вигляді вектора ![]() для початкових значень координат відрізків

для початкових значень координат відрізків ![]() на осі

на осі ![]() та вектора

та вектора ![]() для кінцевих значень координат відрізків

для кінцевих значень координат відрізків ![]() на осі

на осі ![]() , розміщених вздовж осі

, розміщених вздовж осі ![]() за порядковим номером

за порядковим номером ![]() , де

, де ![]() - загальна кількість різних за числовим значенням відрізків

- загальна кількість різних за числовим значенням відрізків ![]() на осі

на осі ![]() , та має один вихід, призначений для виведення значення порядкового номеру відрізку

, та має один вихід, призначений для виведення значення порядкового номеру відрізку ![]() , у якому знаходиться координата кінця вхідного вектора

, у якому знаходиться координата кінця вхідного вектора ![]() по осі

по осі ![]() , згідно з даними активаційної функції

, згідно з даними активаційної функції

![]()

![]() .

.

3. Нейронна мережа за п. 1 та п. 2, що призначена для аналізу, коли одна частка осей ![]() розділена на незмінні відрізки, а інша частка осей

розділена на незмінні відрізки, а інша частка осей ![]() розділена на змінні відрізки.

розділена на змінні відрізки.

4. Нейронна мережа за пп. 1-3, що призначена для аналізу у випадку, коли для чітких систем з чіткою функціональною залежністю ![]() використані поняття теорії однозначних нечітких систем.

використані поняття теорії однозначних нечітких систем.

5. Нейронна мережа за пп. 1-4, що призначена для аналізу у випадку, коли одна частка даних (змінні ![]() та вихід

та вихід ![]() ) є нечіткими, а інша частка даних є чіткими.

) є нечіткими, а інша частка даних є чіткими.

Текст

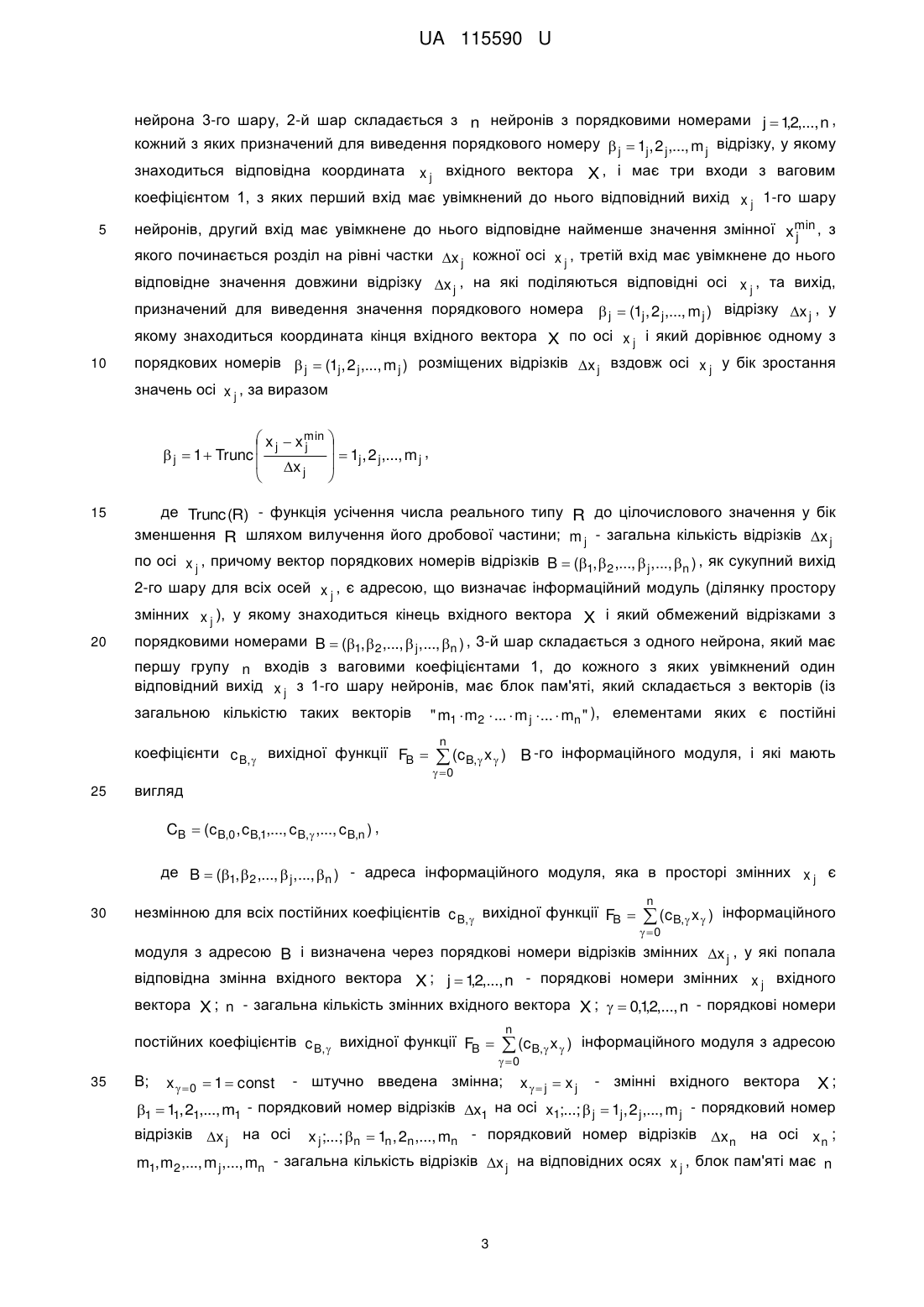

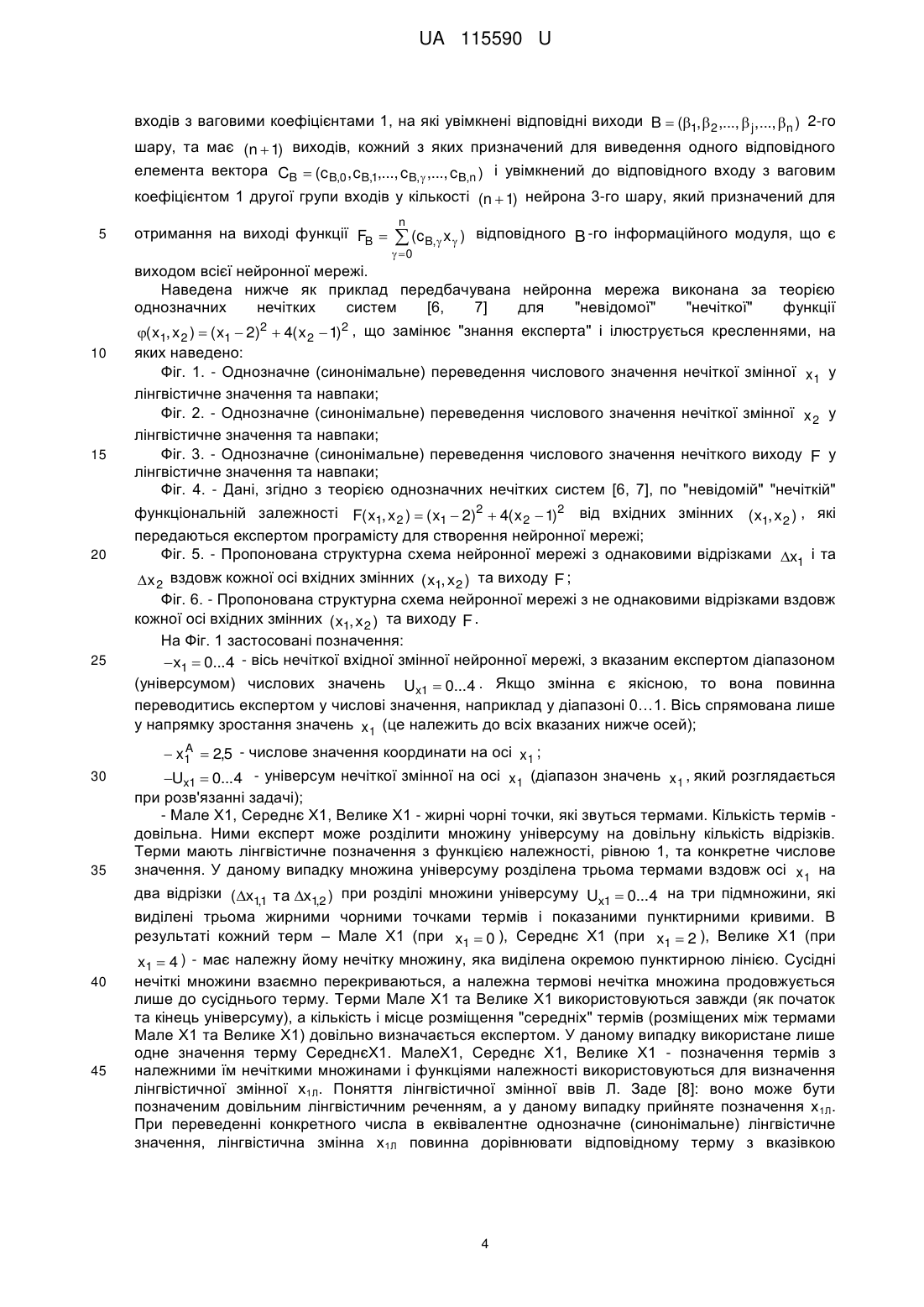

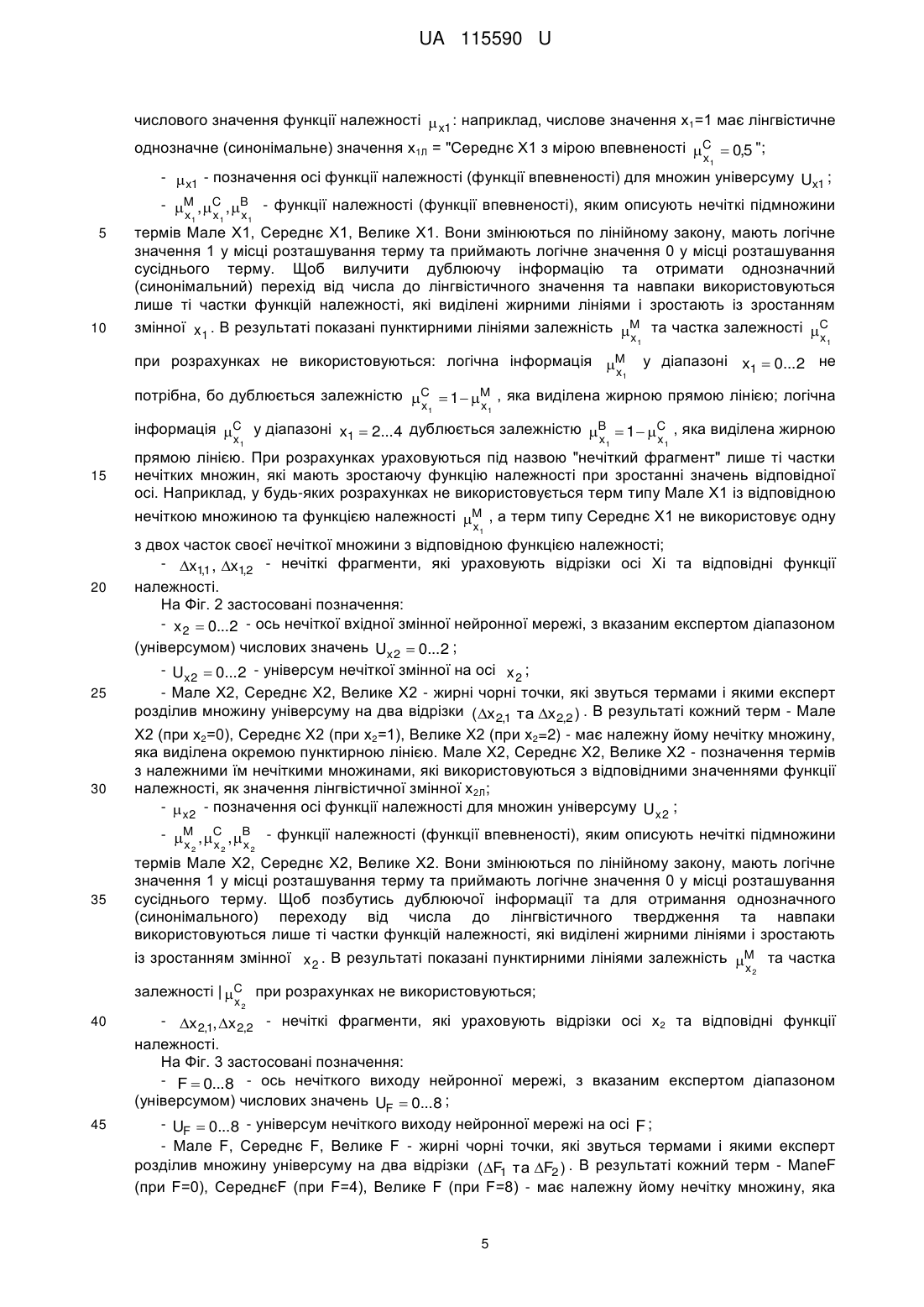

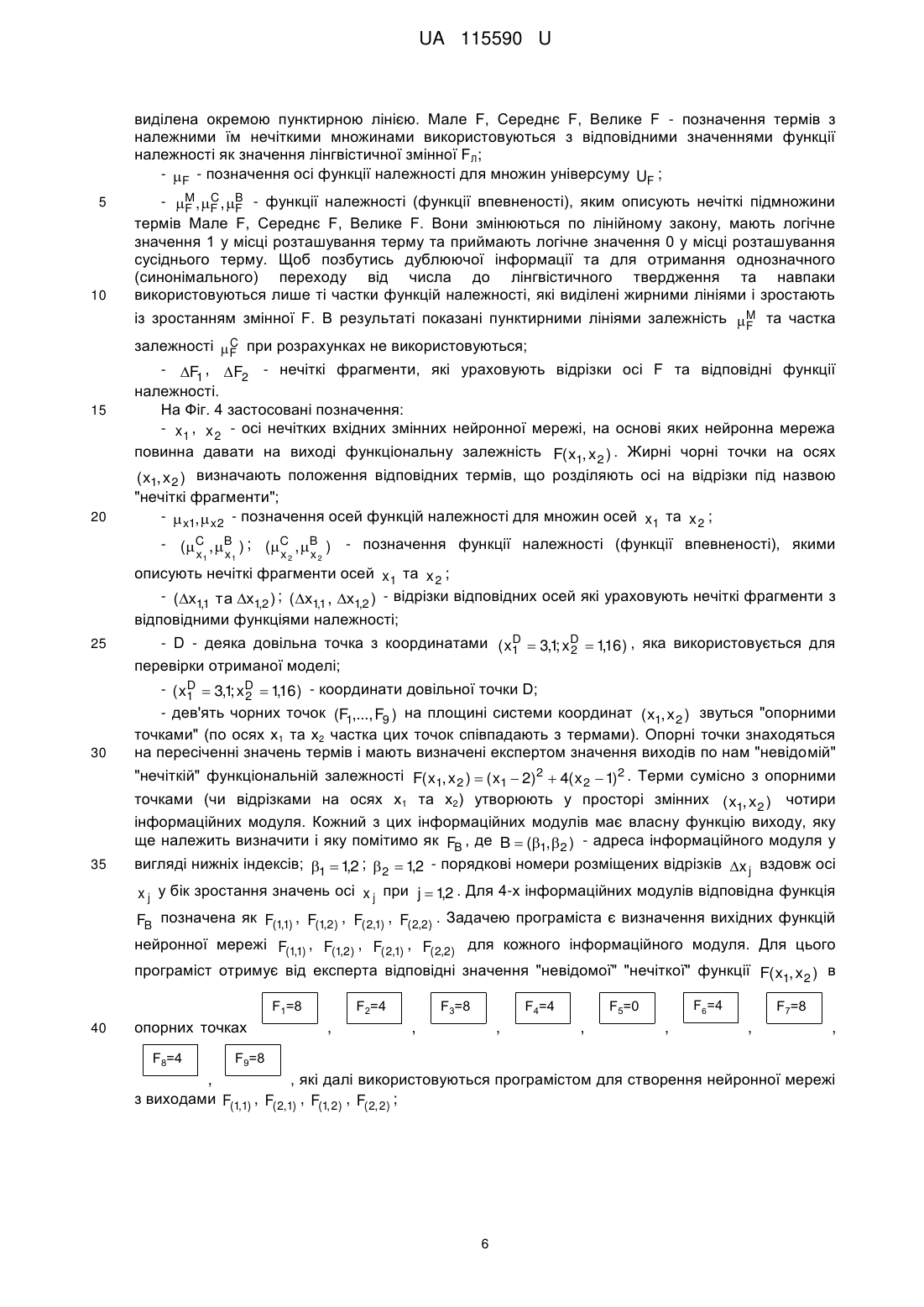

Реферат: UA 115590 U x x min j j 1 , 2 ,..., m , j 1 Trunc j j j x j де Trunc (R) - функція усічення числа реального типу R до цілочислового значення у бік зменшення R шляхом вилучення його дробової частини; m j - загальна кількість відрізків x j по осі x j , причому вектор порядкових номерів відрізків B (1, 2 ,..., j ,..., n ) , як сукупний вихід 2-го шару для всіх осей x j , є адресою, що визначає інформаційний модуль (ділянку простору змінних x j ), у якому знаходиться кінець вхідного вектора X і який обмежений відрізками з порядковими номерами B (1, 2 ,..., j ,..., n ) , 3-й шар складається з одного нейрона, який має першу групу п входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід x j з 1-го шару нейронів, має блок пам'яті, який складається з векторів (із загальною кількістю таких векторів " m1 m 2 ... m j ... mn " ), елементами яких є постійні коефіцієнти c B, вихідної функції FB n (c B, x ) В-го інформаційного модуля, і які мають 0 вигляд CB (c B,0 , c B,1,..., c B, ,..., c B,n ) , де B (1, 2 ,..., j ,..., n ) - адреса інформаційного модуля, яка в просторі змінних x j є незмінною для всіх постійних коефіцієнтів c B, вихідної функції FB n (c B, x ) інформаційного 0 модуля з адресою B і визначена через порядкові номери відрізків змінних x j , у які попала відповідна змінна вхідного вектора X ; j 12,..., n - порядкові номери змінних x j вхідного , вектора X ; n - загальна кількість змінних вхідного вектора X ; 0,12,..., n - порядкові номери , постійних коефіцієнтів c B, вихідної функції FB n (c B, x ) 0 інформаційного модуля з адресою В; x 0 1 const - штучно введена змінна; x j x j - змінні вхідного вектора X ; 1 11, 21,..., m1 - порядковий номер відрізків x1 на осі x1;...; j 1j , 2 j ,..., m j - порядковий номер відрізків x j на осі x j ;...; n 1n , 2n ,..., mn - порядковий номер відрізків x n на осі x n ; m1,m2 ,..., m j ,..., mn - загальна кількість відрізків x j на відповідних осях x j , блок пам'яті має n входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи B (1, 2 ,..., j ,..., n ) 2-го шару, та має (n 1) виходів, кожний з яких призначений для виведення одного відповідного елемента вектора CB (c B,0 , c B,1,..., c B, ,..., c B,n ) і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості (n 1) нейрону 3-го шару, який призначений для отримання на виході функції FB нейронної мережі.. n (c B, x ) 0 відповідного B -го інформаційного модуля, що є виходом всієї UA 115590 U 5 Корисна модель належить до обчислювальної техніки і може використовуватись для створення експертних систем та підсистем прийняття рішень у складних автоматичних системах управління та системах штучного інтелекту, у тому числі - для управління технологічними процесами в машинобудуванні, авіаційній техніці, на транспорті, тощо. Відома нейронна мережа з прямим розповсюдженням сигналів, що призначена для моделювання функціональної залежності F( X) , де X ( x1, x 2 ,..., x j , ..., x n ) - вхідний вектор, j 12,..., n - порядковий номер змінної x j вхідного вектора X , яка має нечіткі множини, , 10 15 20 25 розміщені вздовж осей входів x j та виходу F( x1, x 2 ,..., x j ,..., x n ) , кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. При цьому для отримання вихідного результату F( x1, x 2 ,..., x j ,..., x n ) у лінгвістичній або числовій формі використовуються наступні блоки: фазифікатор, який перетворює числові значення кожної нечіткої множини у лінгвістичні нечіткі множини з використанням функцій належності у вигляді трикутних, гаусівських та інших залежностей; машини нечіткого логічного висновку, які реалізують системи нечіткого висновку; дефазифікатор, який ставить у відповідність лінгвістичному нечіткому значенню деяке чітке цифрове значення вихідного параметра. Трансформація нечіткої множини у точкове рішення виконується за багатьма способами, які видають не однакові результати. Традиційно система нечіткого висновку вміщує: множину нечітких правил висновку; базу описів функції належності; механізм висновку, який створюється на базі правил висновку. Питання фазифікації та дефазифікації розглянуті в роботі [1]. Одним зі засобів їх реалізації можуть бути нейронні мережі [1, рис. 2.1]. Недоліком такого пристрою є складність аналізу, збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу. Відома нейронна мережа з прямим розповсюдженням сигналів, що призначена для моделювання функціональної залежності F( X) , де X ( x1, x 2 ,..., x j , ..., x n ) - вхідний вектор, j 12,..., n - порядковий номер змінної x j вхідного вектора X , яка має нечіткі множини, , 30 35 40 45 50 розміщені вздовж осей входів x j та виходу F( x1, x 2 ,..., x j ,..., x n ) , кожна з яких має лінгвістичну назву і функцію належності, яка монотонно змінюються у межах від "0" до "1" у діапазоні значень нечіткої множини. Перевагою даної мережі, яка використовує основні блоки попереднього пристрою (фазифікатор, машину висновку, дефазифікатор), є модульний принцип виконання роботи з використанням у нейронній мережі уніфікованих модулів двох базових типів: алгоритмічного з виконанням програми та функціонального з таблицею комутації і таблицею шлюзування, які є результатом навчання [2, 3, 4]. Недоліком даного пристрою є складність аналізу, збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу, тому що виконується ускладнений розрахунок, який вміщує процеси фазифікації та дефазифікації. Найбільш близькою до заявленої нейронної мережі за сукупністю суттєвих ознак є вибрана за прототип відома нейронна мережа з прямим розповсюдженням сигналів, призначена для моделювання на основі теорії однозначних нечітких систем функціональної залежності F( X) , де X ( x1, x 2 ,..., x j , ..., x n ) - вхідний вектор, j 12,..., n - порядковий номер змінної x j вхідного , вектора X , яка має нечіткі множини, розміщені вздовж осей змінних x j та виходу F( X) , кожна з нечітких множин має лінгвістичну назву її терму і функцію належності, яка монотонно змінюється у межах "0…1" у діапазоні значень нечіткої множини з урахуванням замість всієї нечіткої множини лише її частки під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності у напрямку збільшення числових значень x j та виходу F( X) , з 1-м шаром, призначеним для нормалізації та розмноження змінних вхідного вектора X ( x1, x 2 ,..., x j , ..., x n ) , j 12,..., n , який складається з n , нейронів, кожний з яких має один вхід з ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора X , яка відрізняється тим, що кожний нейрон 1-го шару. При цьому для отримання вихідного результату F( x1, x 2 ,..., x j ,..., x n ) перший шар нейронної мережі має на кожний нечіткий фрагмент осі x j один нейрон XPj,j , де j 12,..., n - порядковий , номер осі, j 1 2,..., Aj - порядковий номер нечіткого фрагмента вздовж j-ої осі (з позначенням , нейронів по їх вихідним сигналам), який складається лише з активаційної функції і має один вхід 1 UA 115590 U з увімкненою до нього відповідною змінною x j та один вихід, призначений для видачі величини активаційної функції XPj,j у вигляді прямокутного сигналу зі значеннями "1" у межах нечіткого 5 фрагмента осі x j та "0" у іншому разі, другий шар складається з M нейронів B m1, 2,...,n з порядковими номерами m 1 2,..., M, , де M - загальна кількість інформаційних модулів , нейронної мережі, кожний з яких складається з гіпероб'єму, обмеженого по усіх осях x j відповідними значеннями нечітких фрагментів з порядковими номерами 1 1 n , має n , ,..., входів з ваговими коефіцієнтами "1", до яких увімкнені відповідні виходи нейрона першого шару XPj,j , нечіткі фрагменти яких утворюють для одного нейрона B m1, 2,...,n у сукупності один відповідний інформаційний модуль, має вихід, призначений для видачі значення Bm1, 2,...,n 1 , 10 якщо на всі його входи подані величини XPj,j 1 , і видачі на виході значення Bm1, 2,...,n 0 у m іншому разі, третій шар складається з M нейронів F1, 2,...,n без активаційної функції, кожний з яких має керуючий вхід з ваговим коефіцієнтом "1", на який увімкнений вихід відповідного нейрона другого шару B m1, 2,...,n , має нульовий вхід з ваговим коефіцієнтом " w m " , до якого 0 увімкнена постійна вхідна величина x 0 1, має n координатних входів з ваговими 15 коефіцієнтами wm , до яких увімкнені відповідні значення змінних x j входів нейронної мережі і j має вихід, призначений для видачі значення вихідної функції m -го інформаційного модуля m F1,2,...,n Y(x1, x 2,..., x j,..., xn ) при зміні x j лише у межах об'єму координат інформаційного 20 25 30 35 m модуля та F1, 2,...,n 0 у іншому разі, четвертий шар складається з одного нейрона без активаційної функції з M входами при рівних "1" вагових коефіцієнтах, до яких увімкнені виходи m нейронів третього шару F1, 2,...,n , і з виходом, призначеним для видачі підсумку виходів всіх нейронів інформаційних модулів третього шару [5]. Недоліком прийнятого за прототип пристрою є збільшення вартості обладнання та збільшення часу, необхідного для отримання результату аналізу, тому що використовується збільшена кількість нейронів і визначаються функції виходу, які не повинні розраховуватись, бо їх вихід не використовується. Причинами, які перешкоджають одержанню очікуваного технічного результату у прототипі (зменшення вартості обладнання, спрощення аналізу та зменшення часу розв'язання проблеми), є прийнята архітектура нейронної мережі. В основу поставлена задача зменшення вартості обладнання за рахунок спрощення архітектури нейронної мережі, зменшення часу отримання виходу нейронної мережі та спрощення операцій за рахунок вилучення розрахунків, які не передбачається використовувати. Загальні суттєві ознаки пропонованої нейронної мережі, які співпадають із суттєвими ознаками прототипу, полягають у тому, що нейронна мережа з прямим розповсюдженням сигналів призначена для моделювання на основі теорії однозначних нечітких систем функціональної залежності F( X) , де X ( x1, x 2 ,..., x j , ..., x n ) - вхідний вектор, j 12,..., n , порядковий номер змінної x j вхідного вектора X , яка має нечіткі множини, розміщені вздовж 40 45 осей змінних x j та виходу F( X) , кожна з нечітких множин має лінгвістичну назву її терму і функцію належності, яка монотонно змінюється у межах "0…1" у діапазоні значень нечіткої множини з урахуванням замість всієї нечіткої множини лише її частки під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності у напрямку збільшення числових значень x j та виходу F( X) , з 1м шаром, призначеним для нормалізації та розмноження змінних вхідного вектора X ( x1, x 2 ,..., x j , ..., x n ) , j 12,..., n , який складається з n нейронів, кожний з яких має один вхід з , ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора X . Суттєві ознаки нейронної нечіткої системи, що є достатніми у всіх випадках і характеризують запропоновану корисну модель на відміну від прототипу, полягають у тому, що кожний нейрон 1-го шару має два виходи, перший з яких з'єднаний з першим входом відповідного нейрона 2-го шару, а другий вихід з'єднаний з відповідним входом, який належить до першої групи входів 2 UA 115590 U нейрона 3-го шару, 2-й шар складається з n нейронів з порядковими номерами j 12,..., n , , кожний з яких призначений для виведення порядкового номеру j 1j , 2 j ,..., m j відрізку, у якому знаходиться відповідна координата x j вхідного вектора X , і має три входи з ваговим коефіцієнтом 1, з яких перший вхід має увімкнений до нього відповідний вихід x j 1-го шару 5 нейронів, другий вхід має увімкнене до нього відповідне найменше значення змінної xmin , з j якого починається розділ на рівні частки x j кожної осі x j , третій вхід має увімкнене до нього відповідне значення довжини відрізку x j , на які поділяються відповідні осі x j , та вихід, призначений для виведення значення порядкового номера j (1j , 2 j ,..., m j ) відрізку x j , у якому знаходиться координата кінця вхідного вектора X по осі x j і який дорівнює одному з 10 порядкових номерів j (1j , 2 j ,..., m j ) розміщених відрізків x j вздовж осі x j у бік зростання значень осі x j , за виразом x x min j j 1 , 2 ,..., m , j 1 Trunc j j j x j 15 де Trunc (R) - функція усічення числа реального типу R до цілочислового значення у бік зменшення R шляхом вилучення його дробової частини; m j - загальна кількість відрізків x j по осі x j , причому вектор порядкових номерів відрізків B (1, 2 ,..., j ,..., n ) , як сукупний вихід 2-го шару для всіх осей x j , є адресою, що визначає інформаційний модуль (ділянку простору змінних x j ), у якому знаходиться кінець вхідного вектора X і який обмежений відрізками з 20 порядковими номерами B (1, 2 ,..., j ,..., n ) , 3-й шар складається з одного нейрона, який має першу групу n входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід x j з 1-го шару нейронів, має блок пам'яті, який складається з векторів (із загальною кількістю таких векторів коефіцієнти c B, вихідної функції FB 25 " m1 m2 ... m j ... mn " ), елементами яких є постійні n (c B, x ) B -го інформаційного модуля, і які мають 0 вигляд CB (c B,0 , c B,1,..., c B, ,..., c B,n ) , де B (1, 2 ,..., j ,..., n ) - адреса інформаційного модуля, яка в просторі змінних x j є 30 незмінною для всіх постійних коефіцієнтів c B, вихідної функції FB n (c B, x ) інформаційного 0 модуля з адресою B і визначена через порядкові номери відрізків змінних x j , у які попала відповідна змінна вхідного вектора X ; j 12,..., n - порядкові номери змінних x j вхідного , вектора X ; n - загальна кількість змінних вхідного вектора X ; 0,12,..., n - порядкові номери , постійних коефіцієнтів c B, вихідної функції FB 35 В; x 0 1 const n (c B, x ) інформаційного модуля з адресою 0 - штучно введена змінна; xj x j - змінні вхідного вектора X; 1 11, 21,..., m1 - порядковий номер відрізків x1 на осі x1;...; j 1j , 2 j ,..., m j - порядковий номер відрізків x j на осі x j ;...; n 1n , 2n ,..., mn - порядковий номер відрізків x n на осі x n ; m1, m2 ,..., m j ,..., mn - загальна кількість відрізків x j на відповідних осях x j , блок пам'яті має n 3 UA 115590 U входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи B (1, 2 ,..., j ,..., n ) 2-го шару, та має (n 1) виходів, кожний з яких призначений для виведення одного відповідного елемента вектора CB (cB,0 , cB,1,..., cB, ,..., cB,n ) і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості (n 1) нейрона 3-го шару, який призначений для 5 отримання на виході функції FB n (c B, x ) відповідного B -го інформаційного модуля, що є 0 виходом всієї нейронної мережі. Наведена нижче як приклад передбачувана нейронна мережа виконана за теорією однозначних нечітких систем [6, 7] для "невідомої" "нечіткої" функції 10 15 20 25 30 35 ( x1, x 2 ) ( x1 2)2 4( x 2 1)2 , що замінює "знання експерта" і ілюструється кресленнями, на яких наведено: Фіг. 1. - Однозначне (синонімальне) переведення числового значення нечіткої змінної x1 у лінгвістичне значення та навпаки; Фіг. 2. - Однозначне (синонімальне) переведення числового значення нечіткої змінної x 2 у лінгвістичне значення та навпаки; Фіг. 3. - Однозначне (синонімальне) переведення числового значення нечіткого виходу F у лінгвістичне значення та навпаки; Фіг. 4. - Дані, згідно з теорією однозначних нечітких систем [6, 7], по "невідомій" "нечіткій" функціональній залежності F( x1, x 2 ) ( x1 2)2 4( x 2 1)2 від вхідних змінних ( x1, x 2 ) , які передаються експертом програмісту для створення нейронної мережі; Фіг. 5. - Пропонована структурна схема нейронної мережі з однаковими відрізками x1 і та x 2 вздовж кожної осі вхідних змінних ( x1, x 2 ) та виходу F ; Фіг. 6. - Пропонована структурна схема нейронної мережі з не однаковими відрізками вздовж кожної осі вхідних змінних ( x1, x 2 ) та виходу F . На Фіг. 1 застосовані позначення: x1 0...4 - вісь нечіткої вхідної змінної нейронної мережі, з вказаним експертом діапазоном (універсумом) числових значень Ux1 0...4 . Якщо змінна є якісною, то вона повинна переводитись експертом у числові значення, наприклад у діапазоні 0…1. Вісь спрямована лише у напрямку зростання значень x1 (це належить до всіх вказаних нижче осей); A x1 2,5 - числове значення координати на осі x 1 ; Ux1 0...4 - універсум нечіткої змінної на осі x1 (діапазон значень x1 , який розглядається при розв'язанні задачі); - Мале Х1, Середнє Х1, Велике Х1 - жирні чорні точки, які звуться термами. Кількість термів довільна. Ними експерт може розділити множину універсуму на довільну кількість відрізків. Терми мають лінгвістичне позначення з функцією належності, рівною 1, та конкретне числове значення. У даному випадку множина універсуму розділена трьома термами вздовж осі x1 на два відрізки ( x1,1 та x1,2 ) при розділі множини універсуму Ux1 0...4 на три підмножини, які виділені трьома жирними чорними точками термів і показаними пунктирними кривими. В результаті кожний терм – Мале Х1 (при x1 0 ), Середнє Х1 (при x1 2 ), Велике Х1 (при 40 45 x1 4 ) - має належну йому нечітку множину, яка виділена окремою пунктирною лінією. Сусідні нечіткі множини взаємно перекриваються, а належна термові нечітка множина продовжується лише до сусіднього терму. Терми Мале Х1 та Велике Х1 використовуються завжди (як початок та кінець універсуму), а кількість і місце розміщення "середніх" термів (розміщених між термами Мале Х1 та Велике Х1) довільно визначається експертом. У даному випадку використане лише одне значення терму СереднєХ1. МалеХ1, Середнє Х1, Велике Х1 - позначення термів з належними їм нечіткими множинами і функціями належності використовуються для визначення лінгвістичної змінної х1Л. Поняття лінгвістичної змінної ввів Л. Заде [8]: воно може бути позначеним довільним лінгвістичним реченням, а у даному випадку прийняте позначення х 1Л. При переведенні конкретного числа в еквівалентне однозначне (синонімальне) лінгвістичне значення, лінгвістична змінна х1Л повинна дорівнювати відповідному терму з вказівкою 4 UA 115590 U числового значення функції належності x1 : наприклад, числове значення х1=1 має лінгвістичне однозначне (синонімальне) значення х1Л = "Середнє Х1 з мірою впевненості C 0,5 "; x1 - x1 - позначення осі функції належності (функції впевненості) для множин універсуму Ux1 ; - M , C , B - функції належності (функції впевненості), яким описують нечіткі підмножини x1 x1 x1 5 термів Мале Х1, Середнє Х1, Велике Х1. Вони змінюються по лінійному закону, мають логічне значення 1 у місці розташування терму та приймають логічне значення 0 у місці розташування сусіднього терму. Щоб вилучити дублюючу інформацію та отримати однозначний (синонімальний) перехід від числа до лінгвістичного значення та навпаки використовуються лише ті частки функцій належності, які виділені жирними лініями і зростають із зростанням 10 змінної x1 . В результаті показані пунктирними лініями залежність M та частка залежності C x1 x1 при розрахунках не використовуються: логічна інформація M x 1 у діапазоні x1 0...2 не потрібна, бо дублюється залежністю C 1 M , яка виділена жирною прямою лінією; логічна x1 x1 інформація C у діапазоні x1 2... 4 дублюється залежністю B 1 C , яка виділена жирною x x x 1 15 1 1 прямою лінією. При розрахунках ураховуються під назвою "нечіткий фрагмент" лише ті частки нечітких множин, які мають зростаючу функцію належності при зростанні значень відповідної осі. Наприклад, у будь-яких розрахунках не використовується терм типу Мале Х1 із відповідною нечіткою множиною та функцією належності M , а терм типу Середнє Х1 не використовує одну x1 20 25 30 з двох часток своєї нечіткої множини з відповідною функцією належності; - x1,1 , x1,2 - нечіткі фрагменти, які ураховують відрізки осі Хі та відповідні функції належності. На Фіг. 2 застосовані позначення: - x 2 0...2 - ось нечіткої вхідної змінної нейронної мережі, з вказаним експертом діапазоном (універсумом) числових значень Ux2 0... 2 ; - Ux2 0... 2 - універсум нечіткої змінної на осі x 2 ; - Мале Х2, Середнє Х2, Велике Х2 - жирні чорні точки, які звуться термами і якими експерт розділив множину універсуму на два відрізки (x 2,1 та x 2,2 ) . В результаті кожний терм - Мале Х2 (при х2=0), Середнє Х2 (при х2=1), Велике Х2 (при х2=2) - має належну йому нечітку множину, яка виділена окремою пунктирною лінією. Мале Х2, Середнє Х2, Велике Х2 - позначення термів з належними їм нечіткими множинами, які використовуються з відповідними значеннями функції належності, як значення лінгвістичної змінної х2Л; - x2 - позначення осі функції належності для множин універсуму U x 2 ; - M , C , B x x x 2 35 2 - функції належності (функції впевненості), яким описують нечіткі підмножини 2 термів Мале Х2, Середнє Х2, Велике Х2. Вони змінюються по лінійному закону, мають логічне значення 1 у місці розташування терму та приймають логічне значення 0 у місці розташування сусіднього терму. Щоб позбутись дублюючої інформації та для отримання однозначного (синонімального) переходу від числа до лінгвістичного твердження та навпаки використовуються лише ті частки функцій належності, які виділені жирними лініями і зростають із зростанням змінної x 2 . В результаті показані пунктирними лініями залежність M та частка x2 залежності | C при розрахунках не використовуються; x2 40 45 - x 2,1, x 2,2 - нечіткі фрагменти, які ураховують відрізки осі х 2 та відповідні функції належності. На Фіг. 3 застосовані позначення: - F 0...8 - ось нечіткого виходу нейронної мережі, з вказаним експертом діапазоном (універсумом) числових значень UF 0...8 ; - UF 0...8 - універсум нечіткого виходу нейронної мережі на осі F ; - Мале F, Середнє F, Велике F - жирні чорні точки, які звуться термами і якими експерт розділив множину універсуму на два відрізки (F1 та F2 ) . В результаті кожний терм - ManeF (при F=0), СереднєF (при F=4), Велике F (при F=8) - має належну йому нечітку множину, яка 5 UA 115590 U виділена окремою пунктирною лінією. Мале F, Середнє F, Велике F - позначення термів з належними їм нечіткими множинами використовуються з відповідними значеннями функції належності як значення лінгвістичної змінної FЛ; - F - позначення осі функції належності для множин універсуму UF ; 5 10 C - M, F , B - функції належності (функції впевненості), яким описують нечіткі підмножини F F термів Мале F, Середнє F, Велике F. Вони змінюються по лінійному закону, мають логічне значення 1 у місці розташування терму та приймають логічне значення 0 у місці розташування сусіднього терму. Щоб позбутись дублюючої інформації та для отримання однозначного (синонімального) переходу від числа до лінгвістичного твердження та навпаки використовуються лише ті частки функцій належності, які виділені жирними лініями і зростають із зростанням змінної F. В результаті показані пунктирними лініями залежність M та частка F 15 20 C залежності F при розрахунках не використовуються; - F1 , F2 - нечіткі фрагменти, які ураховують відрізки осі F та відповідні функції належності. На Фіг. 4 застосовані позначення: - x1 , x 2 - осі нечітких вхідних змінних нейронної мережі, на основі яких нейронна мережа повинна давати на виході функціональну залежність F( x1, x 2 ) . Жирні чорні точки на осях ( x1, x 2 ) визначають положення відповідних термів, що розділяють осі на відрізки під назвою "нечіткі фрагменти"; - x1, x2 - позначення осей функцій належності для множин осей x1 та x 2 ; - ( C , B ) ; (C , B ) - позначення функції належності (функції впевненості), якими x1 x1 x2 x2 описують нечіткі фрагменти осей x1 та x 2 ; - ( x1,1 та x1,2 ) ; ( x1,1 , x1,2 ) - відрізки відповідних осей які ураховують нечіткі фрагменти з відповідними функціями належності; 25 30 D - D - деяка довільна точка з координатами ( x1 3,1 x D 116 ) , яка використовується для ; 2 , перевірки отриманої моделі; D - ( x1 3,1 x D 116 ) - координати довільної точки D; ; 2 , - дев'ять чорних точок (F1,..., F9 ) на площині системи координат ( x1, x 2 ) звуться "опорними точками" (по осях х1 та х2 частка цих точок співпадають з термами). Опорні точки знаходяться на пересіченні значень термів і мають визначені експертом значення виходів по нам "невідомій" "нечіткій" функціональній залежності F( x1, x 2 ) ( x1 2)2 4( x 2 1)2 . Терми сумісно з опорними точками (чи відрізками на осях х1 та х2) утворюють у просторі змінних ( x1, x 2 ) чотири інформаційних модуля. Кожний з цих інформаційних модулів має власну функцію виходу, яку ще належить визначити і яку помітимо як FB , де B (1, 2 ) - адреса інформаційного модуля у 35 вигляді нижніх індексів; 1 12 ; 2 12 - порядкові номери розміщених відрізків x j вздовж осі , , x j у бік зростання значень осі x j при j 12 . Для 4-х інформаційних модулів відповідна функція , FB позначена як F(1,1) , F(1,2) , F( 2,1) , F( 2,2) . Задачею програміста є визначення вихідних функцій нейронної мережі F(1,1) , F(1,2) , F( 2,1) , F( 2,2) для кожного інформаційного модуля. Для цього програміст отримує від експерта відповідні значення "невідомої" "нечіткої" функції F( x1, x 2 ) в F1=8 40 опорних точках F8=4 F2=4 , F3=8 F4=4 , , F6=4 F5=0 , , F7=8 , , F9=8 , , які далі використовуються програмістом для створення нейронної мережі з виходами F(1,1) , F( 2,1) , F(1, 2) , F( 2, 2) ; 6 UA 115590 U _ F2=4 F1=8 , F9=8 F3=8 , F4=4 F6=4 F5=0 , , , F7=8 , F8=4 , , _ значення "невідомої" "нечіткої" функції F( x1, x 2 ) ( x1 2)2 4( x 2 1)2 , які надаються експертом програмісту сумісно з відповідними координатами опорних точок для навчання F6=4 нейронної мережі. Наприклад, для 5 10 відповідні дані входів навчальної пари F8=4 ''(x1=4; x2=1) " визначаються з Фіг. 4 і дорівнюють при На Фіг. 5 застосовані позначення: - 1-й шар, 2-й шар, 3-й шар - позначення шарів нейронів нейронної мережі; - x1, x 2 - елементи вхідного вектора до 1-шару; - 1 - вагові коефіцієнти входів нейронів (вони не змінюються у процесі навчання); - x1 , x 2 - числові значення відрізків, на які діляться осі x1 та x 2 ; min - x1 , x min - найменші значення змінних ( x1, x 2 ) , з яких починається розділ на відповідні 2 рівні частки (x1 , x 2 ) кожної осі ( x1, x 2 ) ; 15 20 - 1,2 - позначення двох нейронів 2-го шару, які є однаковими з позначенням виходів цих нейронів. Виходи нейронів 1,2 дорівнюють порядковому номеру відповідних відрізків (x1 , x 2 ) , на які попала відповідна координата вхідного вектора; - FB - позначення одного нейрона 3-го шару, яке є однаковим з позначенням його виходу, що одночасно є виходом всієї нейронної мережі. На Фіг. 6 застосовані позначення: - 1-й шар, 2-й шар, 3-й шар - позначення шарів нейронів нейронної мережі; - x1, x 2 - елементи вхідного вектора; - 1 - вагові коефіцієнти входів нейронів (вони не змінюються у процесі навчання); max та min найбільше та найменше граничні значення max min - x1,1 , x1,1 - записані в векторах X1 X1 координати x1 для 1 -го за порядковим номером відрізка x1,1 серед неоднакових за розмірами відрізків, розміщених вздовж осі x1; 25 - xmax , та xmin - записані в векторах Xmax та Xmin найбільше та найменше граничні 2 2 2,2 2,2 значення координати х2 для 2 -го за порядковим номером відрізка x 2,2 серед неоднакових за розмірами відрізків, розміщених вздовж осі х2; - 1 12 - порядкові номери не однакових відрізків x1,1 вздовж осі x1 ; , - 2 12 - порядкові номери не однакових відрізків x 2,2 вздовж осі х2; , 30 - m2 - загальна кількість не однакових відрізків вздовж осі х 2; - 1,2 - позначення двох нейронів 2-го шару, які є однаковими з позначенням виходів цих нейронів. Виходи нейронів 1,2 дорівнюють порядковому номеру відповідних відрізків (x1,1, x 2,2 ) , на які попала відповідна координата вхідного вектора; 35 - FB - позначення одного нейрона 3-го шару, яке є однаковим з позначенням його виходу, що одночасно є виходом всієї нейронної мережі. Розглянемо алгоритм роботи пропонованого пристрою, згідно з Фіг. 1. Задане числове значення координати A x1 2,5 переводиться в однозначне (синонімальне) лінгвістичне значення х1Л = "Велике Х1 з функцією належності B 0,25 ". І навпаки - будь-яке лінгвістичне x 1 40 значення з функцією належності однозначно (синонімально) переводиться у числове значення. Аналогічні розрахунки можуть виконуватись і по іншим осям, згідно з Фіг. 2 та Фіг. 3. Внаслідок чіткості та однозначності подібних розрахунків, очевидно, що однозначні (синонімальні) перетворення чисел та лінгвістичних тверджень можна використати також і для чітких систем. 7 UA 115590 U 5 10 15 Це свідчить про те, що нейронні мережі, створені на основі теорії однозначних нечітких систем [6, 7] можна використати також для аналізу і моделювання чітких систем. На Фіг. 4 наведені основні навчальні дані, які видає експерт програмісту для навчання нейронної мережі і які визначаються на основі теорії однозначних нечітких систем. Кожну ось вхідних змінних експерт розділяє термами на нечіткі фрагменти ( x1,1 , x1,2 ) та (x 2,1 та x 2,2 ) . Лінії, проведені через координати термів на осях ( x1, x 2 ) , розділяють площину змінних ( x1, x 2 ) на чотири частки, які звуться інформаційними модулями [6, 7]. Вважаємо, що кожний з 4-х інформаційних модулів має власну функцію виходу F B, де B (1, 2 ) ; 1 12 ; 2 12 , з відповідними позначеннями F(1,1) , F(1,2) , F( 2,1) , F( 2,2) для всіх 4-х , , інформаційних модулів. За методом найменших квадратів можна отримати одну загальну функцію виходу одразу для всіх 4-х інформаційних модулів, але цей випадок не розглядається із-за зменшення точності розрахунків. З метою знаходження функцій виходу інформаційних модулів F(1,1) , F(2,1) , F(1,2) , F(2,2) в точках взаємного пересічення координат термів, які звуться опорними точками, визначають числові та лінгвістичні значення функції виходу. У нашому випадку числові значення виходу для опорних точок "визначені експертом" по "невідомій" формулі ( x1, x 2 ) ( x1 2)2 4( x 2 1)2 і наведені в F1=8 прямокутниках F2=4 на Фіг. біля кожної опорної точки у вигляді значень , _ F9=8 ,… 20 4 . D Припустимо, що точка D( x1 3,1; x D 116 ) Фіг. 4 відображує координати вхідного вектора. , 2 Для цієї точки потрібно визначити вихідну функцію FB відповідного інформаційного модуля F(2,2) C(2,2),0 x 0 C(2,2),1x1 C( 2,2),2 x 2 , (1) 25 де x0 1 const - штучно введена змінна (для зручності розрахунків); C( 2,2),0 , C(2,2),1, C(2,2),2 - невідомі постійні коефіцієнти функції F( 2,2) , які потрібно визначити; (2,2)= B (1, 2 ) - адреса інформаційного модуля, визначена через порядкові номери відрізків на осях. Щоб навчити нейронну мережу (знайти невідомі коефіцієнти C( 2,2),0 , C(2,2),1, C(2,2),2 функції F( 2,2) потрібно з матричного рівняння 30 FB X CB , (2) F2 F де FB 3 F5 F6 4 x 0 1 8 x ; X 0 1 x 0 1 0 4 x 0 1 x1 2 x 2 2 C( 2,2),0 x1 4 x 2 2 ; CB C( 2,2),1 ; (2) x1 2 x 2 1 C( 2,2),2 x1 4 x 2 1 FB - вектор вихідних значень для інформаційного модуля з вихідною функцією F( 2,2) , СB 35 вектор постійних коефіцієнтів вихідної функції F( 2,2) ; визначити невідомі елементи вектора постійних коефіцієнтів СB, згідно з виразу T CB ( X X) 40 1 C(2,2),0 8 X FB C(2,2),1 2 , (3) C(2,2),2 4 T звідки за формулою (1) отримуємо рівняння 8 UA 115590 U F( 2,2) 8 2x1 4x 2 . (4) D Для вхідної точки D( x1 3,1 xD 1,16 ) , згідно з рівнянням (4), отримуємо числове значення ; 2 D виходу F(D,2) 8 2x1 4xD 8 2 3,1 4 116 2,84 . "Перевірка експертом" цього рішення по , 2 2 5 "невідомій" нам функції ( x1, x 2 )D показує, що дійсне рішення D ( x1, x 2 )D ( x1 2)2 4( xD 1)2 (3,1 22 ) 4(116 1)2 131 має досить велике відхилення від , , 2 отриманого значення F(2,2) 2,84 ; в той же час перевірка виходу по кутовим точкам 10 інформаційного модуля показує їх співпадіння. Зменшити похибку можна збільшенням кількості інформаційних модулів. Після виконання подібних розрахунків по всіх інформаційних модулях отримуємо сукупності вагових коефіцієнтів 0 8 8 0 C(1,2) 2; C( 2,2) 2 ; C(1,1) 2; C( 2,2) 2 (5) 4 4 4 4 15 і відповідні значення функцій виходу для 4-х інформаційних модулів: F(1,2) 2x1 4x 2 ; F(2,2) 8 2x1 4x 2 ; (6) F(1,1) 8 2x1 4x 2 ; F( 2,1) 2x1 4x 2 . 20 25 30 35 40 По функціям (6) можна отримати чотири нейрони, які розраховуватимуть вихід нейронної мережі у залежності від того, у який з 4-х інформаційних модулів попали координати вхідного вектора. Саме так виконуються розрахунки в нейронній мережі прототипу [5]. У даному випадку, щоб не робити зайвих розрахунків для інформаційних модулів, дані яких не використовуються на виході нейронної мережі, в запропонованих нейронних мережах Фіг. 5 та Фіг. 6, аналіз яких виконується на основі теорії однозначних нечітких множин [6, 7], передбачається записувати постійні коефіцієнти (5) навченої нейронної мережі в окремий блок пам'яті у вигляді векторів (матриці) в вихідному 3-му шарі нейронної мережі, з якої обирається лише потрібний комплект постійних коефіцієнтів C(1,1) , C(2,1) , C(1,2) , C(2,2) для введення в один нейрон вихідного 3-го шару, який має один вихід, призначений для виведення вихідної функції всієї нейронної мережі. Нейронна мережа Фіг. 5 має 1-й шар, призначений для нормалізації та розмноження змінних вхідного вектора X ( x1, x 2 ), j 12 . 1-й шар складається з n=2 нейронів, кожний з яких має , один вхід з ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора X. 2-й шар нейронної мережі Фіг. 5 складається з n=2 нейронів з порядковими номерами j=1, 2, кожний з яких призначений для виведення порядкового номеру j (1j , 2 j ) ; відрізку, у якому знаходиться відповідна координата x j вхідного вектора X. Кожний нейрон 2-го шару має три входи з ваговим коефіцієнтом 1: - перший вхід має увімкнений до нього відповідний вихід x j 1-го шару нейронів; - другий вхід має увімкнене до нього відповідне найменше значення змінної xmin , з якого j починається розділ на рівні частки x j кожної осі x j ; - третій вхід має увімкнене до нього відповідне значення довжини відрізку x j , на які поділяються відповідні осі x j . 45 Вихід кожного нейрона 2-го шару, призначений для виведення значення порядкового номера j (1j , 2 j ) відрізку x j , у якому знаходиться координата кінця вхідного вектора X по осі 9 UA 115590 U x j і який дорівнює одному з порядкових номерів j (1j , 2 j ) розміщених відрізків x j вздовж осі x j у бік зростання значень осі x j , за виразом x x min j j 1 ,2 , j 1 Trunc j j x j 5 де Trunc (R) - функція усічення числа реального типу R до цілочислового значення у бік зменшення R шляхом вилучення його дробової частини; m j - загальна кількість відрізків x j 10 по осі x j . Вектор порядкових номерів відрізків B (1, 2 ) , як сукупний вихід 2-го шару для всіх осей x j , є адресою, що визначає інформаційний модуль (ділянку простору змінних x j ), у якому 15 знаходиться кінець вхідного вектора X і який обмежений відрізками з порядковими номерами B (1, 2 ) . 3-й шар складається з одного нейрона, який має: - першу групу п входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід x j з 1-го шару нейронів; - блок пам'яті, який складається з векторів (із загальною кількістю таких векторів " m1 m2 2 2 4 " ), елементи яких є постійними коефіцієнтами вихідної функції FB n (c B, x ) 0 В-го інформаційного модуля, і які мають вигляд 20 CB (c B,0 , c B,1, c B,3 ) , де B (1, 2 ) - адреса інформаційного модуля, яка в просторі змінних x j є незмінною для всіх постійних коефіцієнтів c B, вихідної функції FB n (c B, x ) інформаційного модуля з 0 адресою В і визначена через порядкові номери відрізків змінних x j , у які попала відповідна 25 змінна вхідного вектора X; j 12 - порядкові номери змінних x j вхідного вектора X; n=2 , загальна кількість змінних вхідного вектора X; 0,12 - порядкові номери постійних коефіцієнтів , c B, вихідної функції FB n (c B, x ) 0 інформаційного модуля з адресою В; x 0 1 const штучно введена змінна; x j x j - змінні вхідного вектора X; 1 11, 21 - порядковий номер 30 відрізків x1 на осі x1;...; 2 12, 22 - порядковий номер відрізків x 2 на осі x 2 ; m1 2, m2 2 загальна кількість відрізків x j на відповідних осях x j . Блок пам'яті має п=2 входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи B (1, 2 ) 2-го шару, та має (n+1)=(2+1)=3 виходи, кожний з яких призначений для виведення одного відповідного елемента вектора CB (c B,0 , c B,1, c B,3 ) і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості (n+1)=(2+1)=3 нейрона 3-го шару, який 35 призначений для отримання на виході функції FB n (c B, x ) відповідного В-го інформаційного 0 модуля, що є виходом всієї нейронної мережі. Нейронна мережа Фіг. 6 є аналогічною з нейронною мережею Фіг. 5 і відрізняється лише тим, що призначена для аналізу у випадку, коли відрізки x j, , j 1 2, j 1j , 2 вздовж осі x j є , j 40 неоднаковими. В результаті нейронна мережа Фіг. 6 відрізняється від нейронної мережі Фіг. 5 тим, що у 2-му шарі нейронів кожний j-й нейрон j , j=1, 2, має один вхід з ваговим коефіцієнтом 1, до якого увімкнений відповідний вихідx j нейрона 1-го шару, та має блок пам'яті у вигляді 10 UA 115590 U вектора Xmin ( xmin, xmin ) для початкових значень координат відрізків x j,j на осі x j та j j,1j j,2 j вектора Xmax (xmax , xmax ) для кінцевих значень координат відрізків x j,j на осі x j . j j,1j j,2 j Відрізки x j,j та x j,j розміщені вздовж осі x j за порядковим номером j 1j , 2 j . Позначимо через m j загальну кількість різних за числовим значенням відрізків x j,j на осі x j . 5 Кожний j-й нейрон j має один вихід, призначений для виведення значення порядкового номеру відрізку j , у якому знаходиться координата кінця вхідного вектора X по осі x j , згідно з даними активаційної функції For j : 1 to n do For i : 1 to m j do 10 if((x j xmin )and (x j xmax ))them j : i ; j,j j,j 15 Розглянемо роботу нейронної мережі Фіг. 5. Якщо на входи навченої нейронної мережі Фіг. 5 увімкнені змінні вхідного вектору X ( x1, x 2 ) , то у 1-му шарі вони нормалізуються і розмножуються. Кожний нейрон 2-го шару отримує на своєму вході вихідне значення x j 1-го шару і визначає значення порядкового номера j (1 2) відрізку x j , у якому знаходиться координата кінця вхідного вектора X по осі , x j , по формулі 20 x x min j 1 ,2 , ( j 1 Trunc j j x j де Trunc (R) - функція усічення числа реального типу R до цілочислового значення у бік зменшення R шляхом вилучення його дробової частини m j - загальна кількість відрізків x j по 25 осі x j . Адреса інформаційного модуля у вигляді вектора порядкових номерів відрізків B (1, 2 ) отримується як сукупність виходів нейронів 2-го шару для всіх осей x j . Однин нейрон 3-го шару через свої входи отримує: - значення змінних x j з 1-го шару нейронів, які з'єднані з першою групою входів у кількості 30 n=2 з ваговими коефіцієнтами 1 нейрона 3-го шару; - зі своєї другої групи входів у кількості (n+1)=(2+1)=3 з ваговими коефіцієнтами 1 - значення постійних коефіцієнтів c B, функції виходу FB 35 n (c B, x ) , які отримуються з блока пам'яті у вигляді вектора 0 CB (c B,0 , c B,1, c B,3 ) , де B (1, 2 ) - адреса інформаційного модуля, яка в просторі змінних x j є незмінною для всіх постійних коефіцієнтів c B, вихідної функції FB n (c B, x ) інформаційного модуля з 0 адресою В. 40 Нейрон 3-го шару отримує на виході функцію FB інформаційного модуля, що є виходом всієї нейронної мережі. 11 n (c B, x ) 0 відповідного В-го UA 115590 U Розглянемо роботу нейронної мережі Фіг. 6, яка відрізняється від роботи нейронної мережі Фіг. 5 лише у 2-му шарі. У 2-му шарі нейронів кожний j-й нейрон j , j 12 , виводить значення порядкового номеру , 5 відрізку j , у якому знаходиться координата кінця вхідного вектора X по осі x j , згідно з даними активаційної функції For j : 1 to 2 do For i : 1 to 2 do if((x j xmin )and (x j xmax ))them j : i , j,j j,j 10 xmin , xmax - початкові та кінцеві значення координат відрізків x j,, j на осі x j . j,j j,j Аналогічно до Фіг. 5, 3-й шар Фіг. 6 складається з одного нейрона, який має блок пам'яті у вигляді векторів (матриці) постійних коефіцієнтів для вихідних функцій FB, B (1, 2 ,..., j ,..., n ) , 15 20 25 всіх інформаційних модулів. Робота 3-го шару Фіг. 6 не відрізняється від роботи 3-го шару Фіг. 5. Навчання нейронних мереж Фіг. 5 та Фіг. 6 відбувається не стосовно вагових коефіцієнтів нейрона 3-го шару (бо для всієї мережі вагові коефіцієнти всіх нейронів дорівнюють 1 і не змінюються), а стосовно записаних в блоці пам'яті 3-го шару постійних коефіцієнтів CB (c B,0 , c B,1, c B,3 ) для вихідних функцій FB. Навчання нейронних мереж Фіг. 5 та Фіг. 6 виконується або за методом найменших квадратів, який використаний у рівняннях (1)-(6), або за дельта-правилом [9, 10]. Метод зворотного розповсюдження похибки (back propagation) не використовується. Процес навчання спрощується за рахунок використання лише "дельта-правила" ВідроуХоффа (Widrow-Hoff) [9, 10], згідно з яким на початку навчання ваговим коефіцієнтам нейронів надаються малі випадкові значення, наприклад, із діапазону [-0,3; …; +0,3] з випадковим призначенням знаків "+" та "-", а розрахунки вагових коефіцієнтів виконуються за формулою wHOBE wСТАРЕ ( y1E y1) x j wСТАРЕ x j , j j j 30 35 40 45 50 де ( y1E y1); w СТАРЕ , wHOBE - старе та нове значення вагових коефіцієнтів; 0...1 j j коефіцієнт навчання (звичайно приймається рівним 0,05…0,25); y1E , y1 - еталонне та реальне (розраховане) значення виходу. Тут використані традиційні позначення вагових коефіцієнтів для нейронів. У нашому випадку як вагові коефіцієнти w j слід використовувати постійні коефіцієнти функції виходу CB (c B,0 , c B,1, c B,3 ) . В процесі навчання на вхід нейрона подається одна навчальна еталонна пара (входів та виходу) за іншою, в результаті чого вагові коефіцієнти нейронів коригуються до тих пір, доки для усіх еталонів похибка у розпізнаванні об'єктів не стане меншою деякого прийнятого значення [9, 10]. За методом найменших квадратів для визначення постійних коефіцієнтів функції виходу матричне рівняння розв'язується лише один раз. При навчанні за методом найменших квадратів для уточнення розрахунків кількість "опорних точок" може бути збільшена введенням додаткових навчальних точок за інформацією експерта, або при використанні даних експлуатації. Наведений приклад для Фіг. 4 з формулами (1)-(6) для аналізу нечітких систем цілком заснований на чіткій системі, стосовно якої використані поняття теорії однозначних нечітких систем. Це означає можливість аналізу (при умові використання понять теорії однозначних нечітких систем) не лише нечітких систем, але й чітких систем, а також комбінованих систем. Прикладом комбінованої системи може бути система розрахунку нечіткого соціологічного стану підприємства у залежності від: чіткої середньої заробітної плати, чітких цін на ринку; нечітких даних по конкурентам та політичним рішенням тощо. Використання дозволяє розв'язувати складні задачі управління, навчати та перенавчати систему у процесі її роботи шляхом введення у матричне рівняння (1) нових навчальних точок і "забування" старих даних. 12 UA 115590 U 5 10 15 20 25 30 У пропонованій багатошаровій нейронній мережі навчається лише один шар (за дельтаправилом або за методом найменших квадратів); метод зворотного розповсюдження похибки (back propagation) не використовується; традиційна операція дефазифікації не виконується і замінена переведенням отриманого числового рішення у однозначне лінгвістичне твердження; не використовується база взаємно пов'язаних правил (бо всі правила є незалежними); надається можливість взагалі не використовувати задані експертом функції належності. У сукупності це спрощує нейронну мережу, зменшує час отримання рішення, вартість обладнання та експлуатації. Джерела інформації: 1. Штовба С.Д. Введение в теорию нечетких множеств и нечеткую логику [Електронний ресурс]. - Режим доступу: http://matlab.exponenta.ru/fazzylogic/bookl/index.php. 2. Шептунов С.А., Кабак И.С., Суханова Н.В. Интеллектуальная система управления на базе нечеткой логики // Международный научный интернет журнал "Конструкторско-технологическая информатика", 18 сентября 2012, (МГТУ "Станкин", Москва, РФ), http://journal.ikti.ru/index.php/online-magazine/number-1. 3. Нейронная сеть: патент на полезную модель № 66 831 / Кабак И.С., Суханова Н.В. опубл. 27.09.2007, Бюл. № 27. 4. Модульная вычислительная система: патент на ПМ № 75247 (2008.07.27) / Кабак И.С., Суханова Н.В. 5. Нечітка нейрона мережа: патент України на корисну модель G06N 3/02, G06N 7/02, № 97763 / Кутковецький В.Я., Турти М.В. - 10.04.2015, Бюл. № 7. - 3 с. 6. Турти М.В. Теорія однозначних нечітких систем та нейронні мережі. Монографія. Частина 1. - Миколаїв: Вид-во Європейський університет, Миколаївська філія, 2007. - 140 с. 7. Турти М.В. Теорія однозначних нечітких систем та нейронні мережі. Монографія. Частина 2. - Миколаїв: Вид-во Європейський університет, Миколаївська філія, 2007. - 114 с. 8. Заде Л. Понятие лингвистической переменной и его применение к понятию приближенных решений. - М.: Мир, 1976. - 165 с. 9. Widrow В., Hoff M.E.Jr. Adaptive switching circuits // Western Conference Rec, IRE.-1960. - № 4. - P. 94-104. 10. Руденко О.Г., Бодянський С.В. Штучні нейронні мережі. - Харків: ТОВ "Компанія СМІТ", 2006. - 404 с. ФОРМУЛА КОРИСНОЇ МОДЕЛІ 35 1. Нейронна мережа з прямим розповсюдженням сигналів, що призначена для моделювання на основі теорії однозначних нечітких систем функціональної залежності F( X) , де X ( x1, x 2 ,..., x j ,..., x n ) - вхідний вектор, j 12,..., n - порядковий номер змінної x j вхідного , вектора X , яка має нечіткі множини, розміщені вздовж осей змінних x j та виходу F( X) , кожна з 40 нечітких множин має лінгвістичну назву її терму і функцію належності, яка монотонно змінюється у межах "0…1" у діапазоні значень нечіткої множини з урахуванням замість всієї нечіткої множини лише її частки під назвою "нечіткий фрагмент", який охоплює частку нечіткої множини у межах зростання числового значення відповідної функції належності у напрямку збільшення числових значень x j та виходу F( X) , з 1-м шаром, призначеним для нормалізації та розмноження змінних вхідного вектора X ( x1, x 2 ,..., x j ,..., x n ) , j 12,..., n , який складається з , 45 50 n нейронів, кожний з яких має один вхід з ваговим коефіцієнтом 1 з увімкненою до цього входу відповідною змінною вхідного вектора X , яка відрізняється тим, що кожний нейрон 1-го шару має два виходи, перший з яких з'єднаний з першим входом відповідного нейрона 2-го шару, а другий вихід з'єднаний з відповідним входом, який належить до першої групи входів нейрона 3го шару, 2-й шар складається з п нейронів з порядковими номерами j 12,..., n , кожний з яких , призначений для виведення порядкового номеру j 1j , 2 j ,..., m j відрізку, у якому знаходиться відповідна координата x j вхідного вектора X , і має три входи з ваговим коефіцієнтом 1, з яких перший вхід має увімкнений до нього відповідний вихід x j 1-го шару нейронів, другий вхід має увімкнене до нього відповідне найменше значення змінної x min , з якого починається розділ на j рівні частки x j кожної осі x j , третій вхід має увімкнене до нього відповідне значення довжини 55 відрізку x j , на які поділяються відповідні осі x j , та вихід, призначений для виведення 13 UA 115590 U значення порядкового номера j (1j , 2 j ,..., m j ) відрізку x j , у якому знаходиться координата кінця вхідного вектора X по осі і який дорівнює одному з порядкових номерів xj j (1j , 2 j ,..., m j ) розміщених відрізків x j вздовж осі x j у бік зростання значень осі x j , за виразом 5 x x min j j 1 , 2 ,..., m , j 1 Trunc j j j x j де Trunc (R) - функція усічення числа реального типу R до цілочислового значення у бік зменшення R шляхом вилучення його дробової частини; m j - загальна кількість відрізків x j по осі x j , причому вектор порядкових номерів відрізків B (1, 2 ,..., j ,..., n ) , як сукупний вихід 2-го шару для всіх осей x j , є адресою, що визначає інформаційний модуль (ділянку простору 10 змінних x j ), у якому знаходиться кінець вхідного вектора X і який обмежений відрізками з порядковими номерами B (1, 2 ,..., j ,..., n ) , 3-й шар складається з одного нейрона, який має першу групу n входів з ваговими коефіцієнтами 1, до кожного з яких увімкнений один відповідний вихід x j з 1-го шару нейронів, має блок пам'яті, який складається з векторів (із загальною кількістю таких векторів 15 коефіцієнти c B, вихідної функції FB " m1 m 2 ... m j ... mn " ), елементами яких є постійні n (c B, x ) В-го інформаційного модуля, і які мають 0 вигляд CB (c B,0 , c B,1,..., c B, ,..., c B,n ) , де B (1, 2 ,..., j ,..., n ) - адреса інформаційного модуля, яка в просторі змінних x j є незмінною для всіх постійних коефіцієнтів c B, вихідної функції FB 20 n (c B, x ) інформаційного 0 модуля з адресою B і визначена через порядкові номери відрізків змінних x j , у які попала відповідна змінна вхідного вектора X ; j 12,..., n - порядкові номери змінних x j вхідного , вектора X ; n - загальна кількість змінних вхідного вектора X ; 0,12,..., n - порядкові номери , постійних коефіцієнтів c B, вихідної функції FB 25 n (c B, x ) 0 інформаційного модуля з адресою В; x 0 1 const - штучно введена змінна; x j x j - змінні вхідного вектора X ; 1 11, 21,..., m1 - порядковий номер відрізків x1 на осі x1;...; j 1j , 2 j ,..., m j - порядковий номер відрізків x j на осі x j ;...; n 1n , 2n ,..., mn - порядковий номер відрізків x n на осі x n ; m1,m2 ,..., m j ,..., mn - загальна кількість відрізків x j на відповідних осях x j , блок пам'яті має n входів з ваговими коефіцієнтами 1, на які увімкнені відповідні виходи B (1, 2 ,..., j ,..., n ) 2-го шару, та має (n 1) виходів, кожний з яких 30 призначений для виведення одного відповідного елемента вектора CB (c B,0 , c B,1,..., c B, ,..., c B,n ) і увімкнений до відповідного входу з ваговим коефіцієнтом 1 другої групи входів у кількості (n 1) нейрону 3-го шару, який призначений для отримання на виході функції FB 35 n (c B, x ) відповідного B -го інформаційного модуля, що є виходом всієї 0 нейронної мережі.. 2. Нейронна мережа за п. 1, що призначена для аналізу у випадку, коли відрізки x j, j , j 1 2,..., n, j 1j , 2 j ,..., m j вздовж осі x j є неоднаковими, яка відрізняється тим, що у 2-му , шарі нейронів кожний j-й нейрон j, j 1j, 2 j,..., n , має один вхід з ваговим коефіцієнтом 1, до якого увімкнений відповідний вихід x j нейрону 1-го шару, має блок пам'яті у вигляді вектора 14 UA 115590 U Xmin ( xmin, xmin,..., xmin,..., xmin ) для початкових значень координат відрізків x j,j на осі x j та j j,1j j,2 j j,j j,mj вектора Xmax (xmax , x max ,...x max ,...x max ) для кінцевих значень координат відрізків x j,j на j j,1j j,2 j j,j j,mj осі x j , розміщених вздовж осі x j за порядковим номером j 1j , 2 j ,..., m j , де m j - загальна кількість різних за числовим значенням відрізків x j,j на осі x j , та має один вихід, призначений 5 для виведення значення порядкового номеру відрізку j , у якому знаходиться координата кінця вхідного вектора X по осі x j , згідно з даними активаційної функції For j : 1 to n do For i : 1 to m j do if ((x j xmin )and ( x j xmax ))them j : i . j,j j,j 3. Нейронна мережа за п. 1 та п. 2, що призначена для аналізу, коли одна частка осей x j 10 розділена на незмінні відрізки, а інша частка осей x j розділена на змінні відрізки. 4. Нейронна мережа за пп. 1-3, що призначена для аналізу у випадку, коли для чітких систем з чіткою функціональною залежністю F( x1, x 2 ,..., x j ,..., x n ) використані поняття теорії однозначних 15 нечітких систем. 5. Нейронна мережа за пп. 1-4, що призначена для аналізу у випадку, коли одна частка даних (змінні x j та вихід F ) є нечіткими, а інша частка даних є чіткими. 15 UA 115590 U 16 UA 115590 U Комп’ютерна верстка Т. Вахричева Державна служба інтелектуальної власності України, вул. Василя Липківського, 45, м. Київ, МСП, 03680, Україна ДП "Український інститут інтелектуальної власності", вул. Глазунова, 1, м. Київ – 42, 01601 17

ДивитисяДодаткова інформація

МПК / Мітки

МПК: G06N 7/00

Код посилання

<a href="https://ua.patents.su/19-115590-nejjronna-merezha.html" target="_blank" rel="follow" title="База патентів України">Нейронна мережа</a>

Попередній патент: Нейронна мережа

Наступний патент: Комплект дерев’яних профілів для виготовлення віконних блоків

Випадковий патент: Гербіцидна композиція